labuladong的算法笔记

章节

(一)

(二)

(三)

(四)

(五)

(六)

(七)

基础 03.01

03.01

03.01

03.01

03.01

03.01

03.01

03.02

03.02

03.02

\

\

\

\

第零章 03.04

03.05

03.06

03.07

03.08

03.09

03.09

03.10

03.11

03.12

03.13

03.13

03.14

\

第一章 03.15

04.08

04.09

04.09

04.10

\

\

\

\

\

\

第二章 \

\

\

\

\

第三章 04.11

04.11

\

第四章 \

\

\

\

\

机试的环境一般是 Dev C++,请自行打开 C++11 语法支持。

打开上方工具 Tools 的编译选项 Compiler Options。

勾选 编译时加入以下命令。填写入 -std=c++11 即可。

前言:标准模板库 STL

数据结构

1. vector

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 #include <vector> vector<int > a; vector<int > a (n) ;vector<int > a (n, 0 ) ;vector<vector<int > b; vector<vector<int > b(n, vector<int >(5, 0)); a.resize(m); a.resize(m, 0); a.assign(n, 0); a[0] = 5; a.push_back(666); a.insert(a.begin() + 2, e); // 插入为第三个元素 a.insert(a.end(), c.begin(), c.end()); // a+c a.erase(a.begin() + 2); // 删除第三个元素 a.clear(); a.size(); a.empty(); a.front(); a.back();

2. stack

1 2 3 4 5 6 7 8 9 10 #include <stack> stack<int > stk; stk.push (4 ); stk.pop (); stk.top (); stk.empty (); stk.size ();

3. queue

1 2 3 4 5 6 7 8 9 10 11 #include <queue> queue<int > Q; Q.push (4 ); Q.pop (); Q.front (); Q.back (); Q.empty (); Q.size ();

4. deque

1 2 3 4 5 6 7 8 9 10 11 12 13 14 #include <deque> deque<int > DQ; DQ.push_front (e); DQ.push_back (e); DQ.pop_front (); DQ.pop_back (); DQ.front (); DQ.back (); DQ.empty (); DQ.size (); DQ.clear ();

5. unordered_set

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 #include <unordered_set> unorder_set<int > Table; Table.insert (e); Table.erase (e); Table.emplace (e); Table.count (e); Table.find (e); Table.empty (); Table.size (); Table.clear (); for (auto &x: Table) cout << x << endl;

6. unordered_map

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 #include <unordered_map> unordered_map<string, int > Map; Map["apple" ] = 1 ; Map.insert ({"banana" , 2 }); Map.erase ("apple" ); Map.emplace ("cherry" , 3 ); int e = Map["apple" ];Map.count ("apple" ); Map.find ("apple" ); Map.empty (); Map.size (); Map.clear (); for (auto &x: Map) cout << x.first << x.second << endl;

7. priority_queue

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 #include <priority_queue> priority_queue<int > maxHeap; priority_queue<int , vector<int >, less<int >> maxHeap; priority_queue<int , vector<int >, greater<int >> minHeap; maxHeap.push (5 ); maxHeap.pop (); maxHeap.top (); maxHeap.empty (); maxHeap.size (); struct DT { int no; string name; DT (int n, string na): no (n), name (na) {} }; struct Cmp { bool operator () (const DT &a, const DT &b) const return a.no < b.no; } }; priority_queue<DT, vector<DT>, Cmp> maxHeap; maxHeap.push (DT (3 , "Mary" )); maxHeap.push (DT (1 , "Smith" )); maxHeap.push (DT (2 , "John" )); DT std = maxHeap.top (); std.no; std.name; maxHeap.pop (); auto cmp = [](ListNode* a, ListNode* b) { return a->val > b->val; };priority_queue<ListNode*, vector<ListNode*>, decltype (cmp)> minHeap;

8. string

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 #include <string> string s1; s1 = "apple" ; string s2 ("hello" ) ;string s3 (s2) ; string s4 (5 , 'A' ) ; s = s1 + s2; s += "app" ; s1.find ('p' ); s1.find ("le" ); s1.find ("banana" ); s.size (); s.length (); char ch = s[0 ];char ch = s.at (3 );s[5 ] = 'k' ; s2.substr (2 , 3 ); str.insert (5 , "Insert" ); str.erase (5 , 6 ); string s5 = "abcdefg" ; s5.replace (2 , 3 , "AAAAA" ); bool r1 = (s1 == s2); int r2 = s1.compare (s2); for (int i=0 ; i<s.size (); i++) cout << s[i];for (char &c : s) cout << c;string numS = "1234" ; int numI = numS.stoi (numS);double numD = numS.stod (numS);int ai = 34 ;string aiS = to_string (ai); reverse (s.begin (), s.end ()); sort (s.begin (), s.end ()); s.empty (); s.clear ();

9、list

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 #include <list> list<int > myList; list<int > l2 (n) ; list<int > l3 (n, 8 ) ; list<int > l4 = {1 , 2 , 3 }; list<int > l5 (l4) ;myList.push_back (10 ); myList.push_front (20 ); myList.insert (++myList.begin (), 30 ); myList.pop_back (); myList.pop_front (); myList.erase (myList.begin ()); myList.remove (10 ); myList.clear (); int first = myList.front (); int last = myList.back (); int size = myList.size ();bool isEmpty = myList.empty ();for (auto it = myList.begin (); it != myList.end (); ++it) { cout << *it << " " ; } for (int val : myList) { cout << val << " " ; } for (list<int >::iterator it = myList.begin (); it != myList.end (); ++it) { cout << *it << " " ; } for (list<int >::reverse_iterator rit = myList.rbegin (); rit != myList.rend (); ++rit) { cout << *rit << " " ; } list<int > list1 = {1 , 3 , 5 }; list<int > list2 = {2 , 4 , 6 }; list1.merge (list2); myList.sort (); myList.sort (greater <int >()); myList.unique (); myList.reverse (); list<int > otherList = {7 , 8 , 9 }; myList.splice (myList.end (), otherList);

算法与心得

1. algorithm

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 #include <algorithm> swap (vec[0 ], vec[1 ]);sort (vec.begin (), vec.end ()); min (a, b);max (a, b);min ({a, b, c, d});max ({a, b, c, d, e});min_element (vec.begin (), vec.end ());max_element (vec.begin (), vec.end ());#include <numeric> int sum = accumulate (vec.begin (), vec.end (), 0 );bool r = binary_search (vec.begin (), vec.end (), 3 ); auto it = find (vec.begin (), vec.end (), 3 );if (it != vec.end ()) cout << *it << (it-vec.begin ()) << endl;int cnt = count (vec.begin (), vec.end (), 3 );fill (vec.begin (), vec.end (), 0 ); replace (vec.begin (), vec.end (), 3 , 99 ); vector<int > vec2 (vec.size()) ;copy (vec.begin (), vec.end (), vec2.begin ());reverse (vec.begin (), vec.end ());

2. cmath

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 #include <cmath> sqrt (x); cbrt (x); abs (a);fabs (f);labs (l);ceil (a);floor (a);round (a);exp (k); exp2 (k); pow (a, k); log (x); log10 (x); log2 (x); sin (x);cos (x);tan (x);asin (x);acos (x);atan (x);sinh (x);cosh (x);tanh (x);

3. 必备实现

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 int gcd (int a, int b) a = abs (a); b = abs (b); while (b != 0 ) { int temp = b; b = a % b; a = temp; } return a; } int lcm (int a, int b) if (a == 0 || b == 0 ) return 0 ; a = abs (a); b = abs (b); return a * b / gcd (a, b); }

4. 心得操作与失误总结

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 for (int i=0 ; i<n; i++){ .... .... while (i+1 <n && nums[i]==nums[i+1 ]) i++; } if (color[i]==color[j]) flag = false ; flag = color[i] != color[j]; Q.front (); Q.pop (); S.top (); S.pop (); vector<vector<int >> G1; vector<vector<bool >> G2; vector<vector<int >> G3; vector<vector<int >> MD; MD.push_back ({1 , 2 , 88 }); MD.push_back ({2 , 2 , 66 }); MD.push_back ({5 , 1 , 99 }); sort (MD.begin (), MD.end (), [](const vector<int >& A, const vector<int >& B){ return A[2 ] < B[2 ]; }); Q.front (); S.top (); PQ.top (); auto cmp = [](const vector<int >& a, const vector<int >& b){ return a[2 ] < b[2 ]; } sort (vc.begin (), vc.end (), cmp);auto cmp = [](const vector<int >& a, const vector<int >& B){ return A[2 ] > B[2 ]; } priority_quque<vector<int >, vector<vector<int >>, decltype (cmp)> PQ; for (int i=0 ; i<=n; i++) dp[i][0 ] = true ;for (int j=0 ; j<=m; j++) dp[0 ][j] = false ;for (int i=0 ; i<=n; i++) dp[i][0 ] = true ;for (int j=1 ; j<=m; j++) dp[0 ][j] = false ;unordered_map<string, int > memo; string key = to_string (i) + ',' + to_string (remain); memo[key] = 88 ; string cur = to_string (i) + ',' + to_string (remain); if (memo.find (cur) != memo.end ()) return memo[cur]; return dp (nums, i+1 , remain-nums[i]) + dp (nums, i+1 , remain+nums[i]);string cur = to_string (i) + ',' + to_string (remain); if (memo.find (cur) != memo.end ()) return memo[cur]; int res = dp (nums, i+1 , remain-nums[i]) + dp (nums, i+1 , remain+nums[i]);memo[cur] = res; return res;

基础:数据结构及排序

(一) 数组(静态、动态)

动态数组底层还是静态数组,只是自动帮我们进行数组空间的扩缩容 ,并把增删查改操作进行了封装,让我们使用起来更方便而已。

(二) 链表(单、双)

略

(三) 变种:环形数组、跳表

环形数组:

环形数组技巧利用求模(余数)运算,将普通数组变成逻辑上的环形数组,可以让我们用 O ( 1 ) O(1) O ( 1 )

核心原理:环形数组的关键在于,它维护了两个指针 start 和 end,start 指向第一个有效元素的索引,end 指向最后一个有效元素的下一个位置索引。

理论上,你可以随意设计区间的开闭,但一般设计为左闭右开 区间是最方便处理的。因为这样初始化 start = end = 0 时,区间 [0, 0) 中没有元素,但只要让 end 向右移动(扩大)一位,区间 [0, 1) 就包含一个元素 0 了。

跳表

1 2 index 0 1 2 3 4 5 6 7 8 9 node a->b->c->d->e->f->g->h->i->j

如果我们想查询索引为 7 的元素是什么,只能从索引 0 头结点开始往后遍历,直到遍历到索引 7,找到目标节点 h。

而跳表则是这样的:

1 2 3 4 5 indexLevel 0-----------------------8-----10 indexLevel 0-----------4-----------8-----10 indexLevel 0-----2-----4-----6-----8-----10 indexLevel 0--1--2--3--4--5--6--7--8--9--10 nodeLevel a->b->c->d->e->f->g->h->i->j->k

此时,如果我们想查询索引为 7 的元素,可以从最高层索引开始一层一层地往下找,这个搜索过程中,会经过 log N \log N log N O ( log N ) O(\log N) O ( log N )

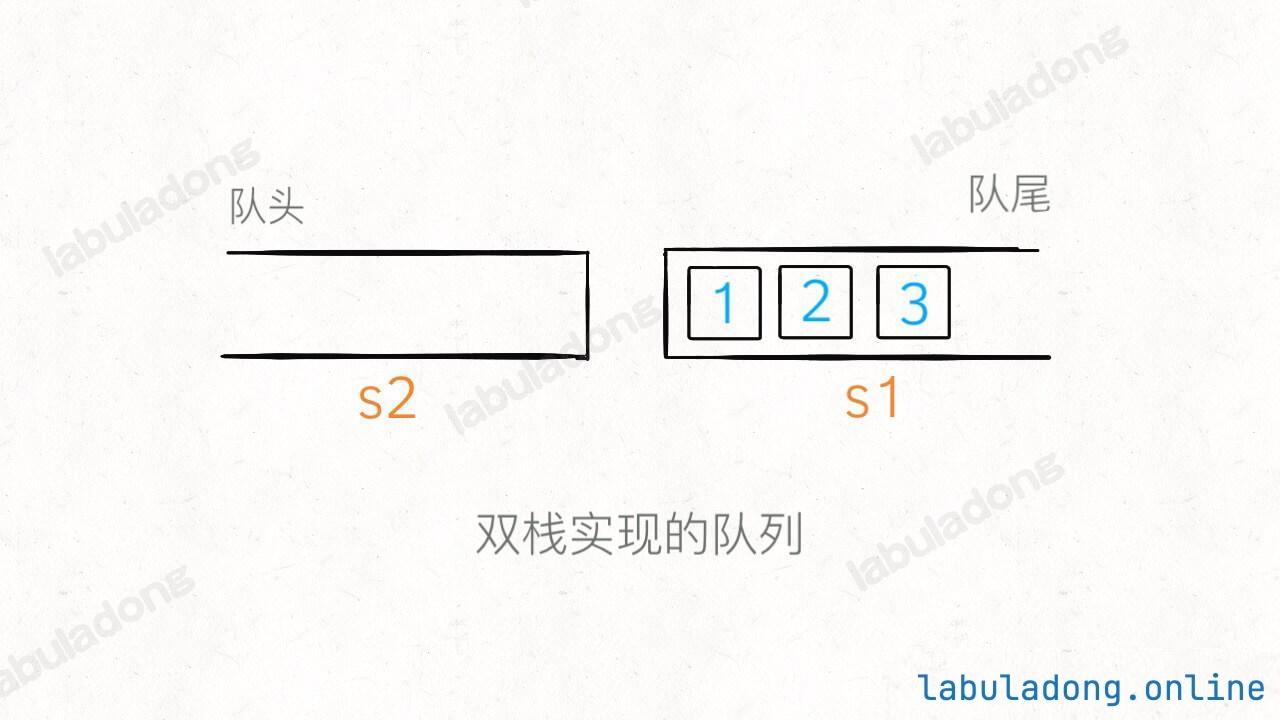

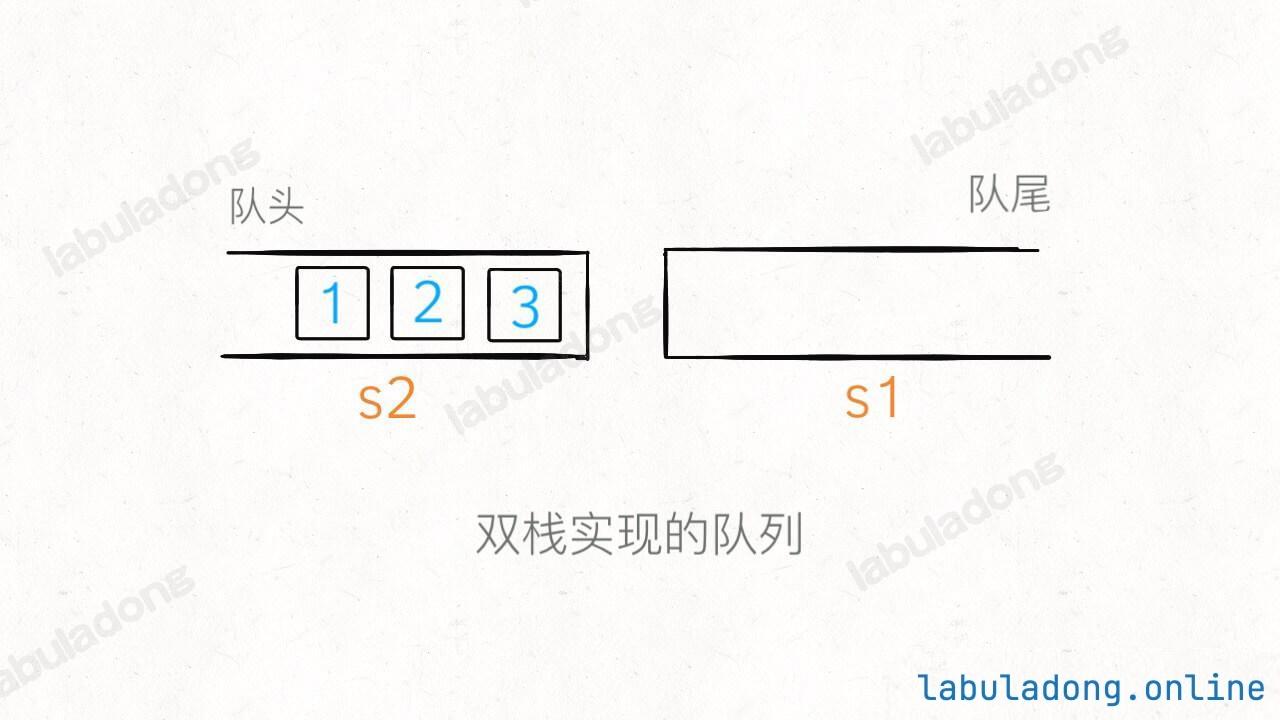

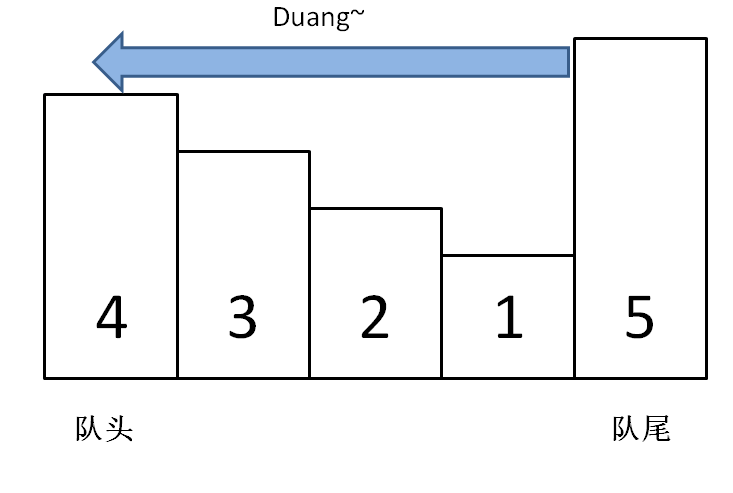

(四) 队列、栈、双端队列

其实队列和栈都是操作受限的数据结构。

队列只能在一端插入元素,另一端删除元素;

(五) 哈希表、哈希集合、加强哈希表

略

(六) 二叉树

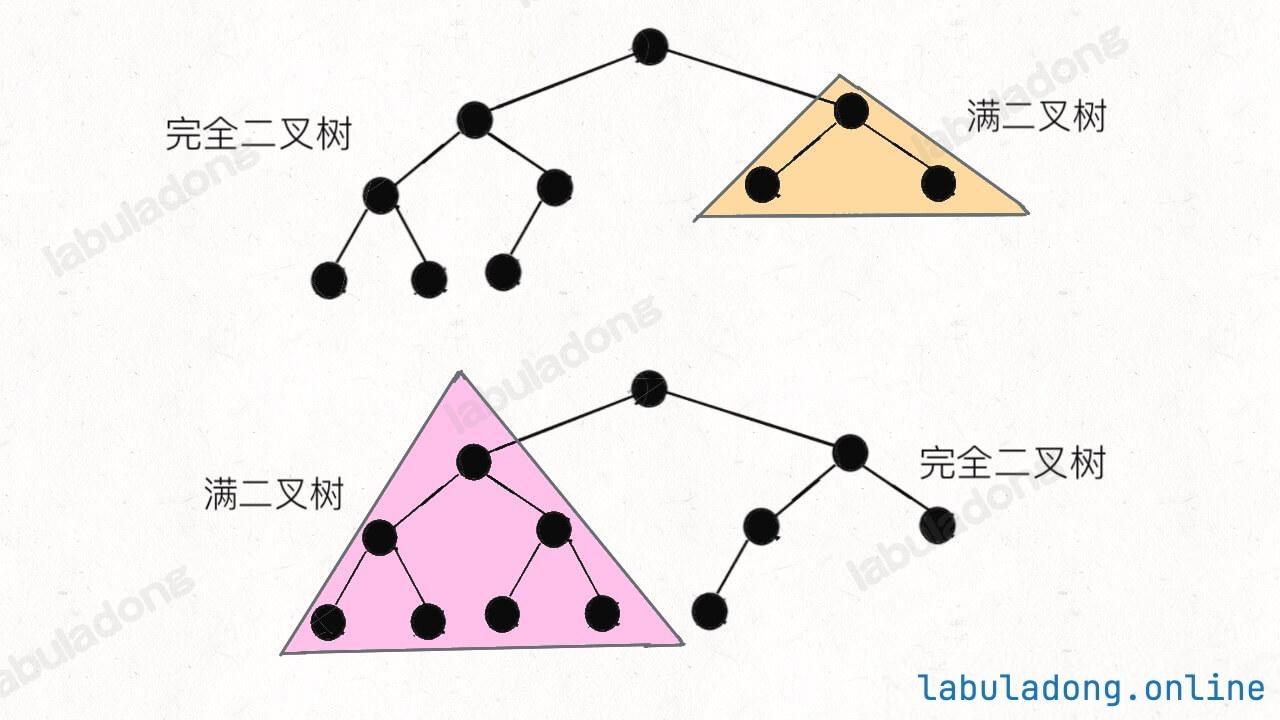

1. 满二叉树

直接看图比较直观,满二叉树就是每一层节点都是满的,整棵树像一个正三角形:

满二叉树有个优势,就是它的节点个数很好算。假设深度为 h h h 2 h − 1 2^h - 1 2 h − 1

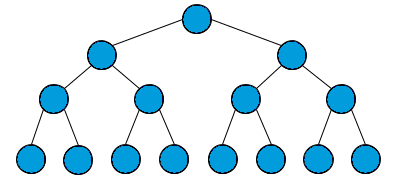

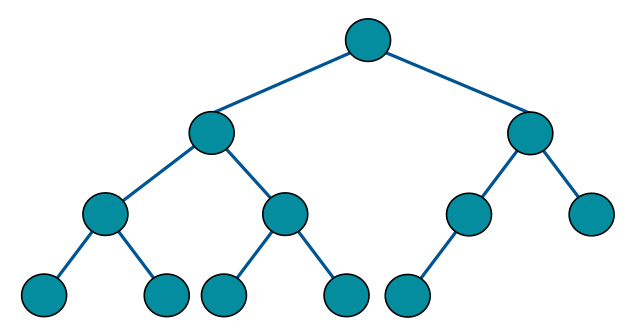

2. 完全二叉树

完全二叉树是指,二叉树的每一层的节点都紧凑靠左排列,且除了最后一层,其他每层都必须是满的:

不难发现,满二叉树其实是一种特殊的完全二叉树。

完全二叉树的特点 :由于它的节点紧凑排列,如果从左到右从上到下对它的每个节点编号,那么父子节点的索引存在明显的规律。

这个特点在讲到 二叉堆核心原理 和 线段树核心原理 时会用到:完全二叉树可以用数组来存储,不需要真的构建链式节点 。

完全二叉树还有个比较难发觉的性质:完全二叉树的左右子树也是完全二叉树 。

或者更准确地说应该是:完全二叉树的左右子树中,至少有一棵是满二叉树 。

3. 平衡二叉树

平衡二叉树(Balanced Binary Tree)是一种特殊的二叉树,它的每个节点的左右子树的高度差不超过 1 。

要注意是每个节点,而不仅仅是根节点。

假设平衡二叉树中共有 N N N O ( l o g N ) O(logN) O ( l o g N )

这是非常重要的性质,后面讲到的 红黑树 和 线段树 会利用平衡二叉树的这个性质,保证算法的高效性。

4. 二叉搜索树

二叉搜索树(Binary Search Tree,简称 BST)是一种很常见的二叉树,它的定义是:对于树中的每个节点,其左子树的每个节点 的值都要小于这个节点的值,右子树的每个节点 的值都要大于这个节点的值。你可以简单记为 左小右大 。

BST 是非常常用的数据结构。因为左小右大的特性,可以让我们在 BST 中快速找到某个节点,或者找到某个范围内的所有节点,这是 BST 的优势所在。

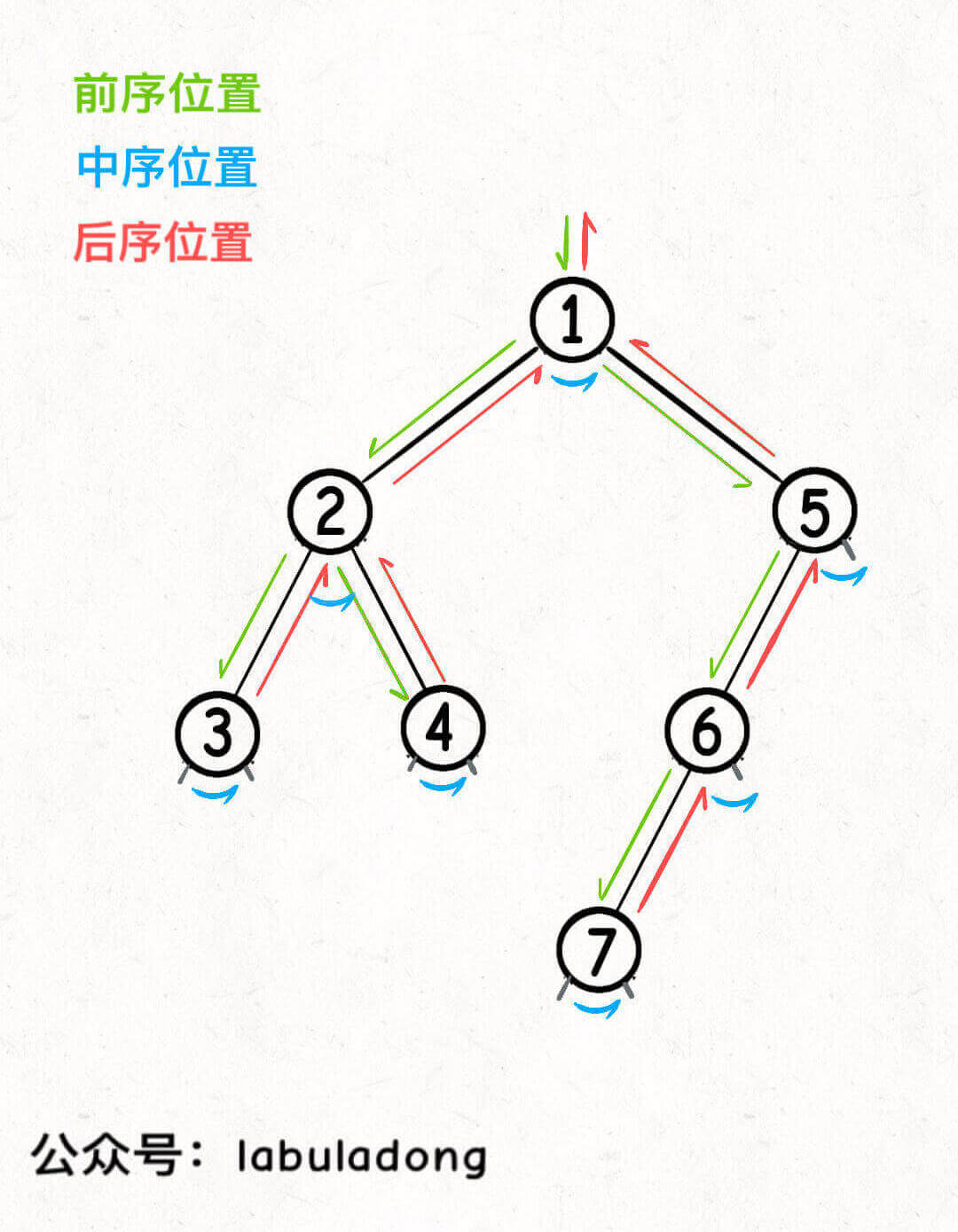

5. 递归遍历(DFS)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 class TreeNode {public : int val; TreeNode* left; TreeNode* right; TreeNode (int x) : val (x), left (nullptr ), right (nullptr ) {} }; void traverse (TreeNode* root) if (root == nullptr ) { return ; } traverse (root->left); traverse (root->right); }

这个递归遍历节点顺序是固定的 ,务必记住这个顺序,否则你肯定玩不转二叉树结构。

二叉树有前/中/后序三种遍历,会得到三种不同顺序的结果。为啥你这里说递归遍历节点的顺序是固定的呢?

BST 的中序遍历结构有序。

6. 层序遍历(BFS)

二叉树的层序遍历,顾名思义,就是一层一层地遍历二叉树。

这个遍历方式需要借助队列来实现,而且根据不同的需求,主要有三种不同的写法,下面一一列举。

(1)写法一

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 void levelOrderTraverse (TreeNode* root) if (root == nullptr ) { return ; } std::queue<TreeNode*> q; q.push (root); while (!q.empty ()) { TreeNode* cur = q.front (); q.pop (); std::cout << cur->val << std::endl; if (cur->left != nullptr ) { q.push (cur->left); } if (cur->right != nullptr ) { q.push (cur->right); } } }

知道节点的层数是个常见的需求,比方说让你收集每一层的节点,或者计算二叉树的最小深度等等。

所以这种写法虽然简单,但用的不多,下面介绍的写法会更常见一些。

(2)写法二

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 void levelOrderTraverse (TreeNode* root) if (root == nullptr ) { return ; } queue<TreeNode*> q; q.push (root); int depth = 1 ; while (!q.empty ()) { int sz = q.size (); for (int i = 0 ; i < sz; i++) { TreeNode* cur = q.front (); q.pop (); cout << "depth = " << depth << ", val = " << cur->val << endl; if (cur->left != nullptr ) { q.push (cur->left); } if (cur->right != nullptr ) { q.push (cur->right); } } depth++; } }

这个变量 i 记录的是节点 cur 是当前层的第几个,大部分算法题中都不会用到这个变量。

但是注意队列的长度 sz 一定要在循环开始前保存 下来,因为在循环过程中队列的长度是会变化的,不能直接用 q.size() 作为循环条件。

这种写法就可以记录下来每个节点所在的层数,可以解决诸如二叉树最小深度这样的问题,是我们最常用的层序遍历写法。

(3)写法三

既然写法二是最常见的,为啥还有个写法三呢?因为要给后面的进阶内容做铺垫。

回顾写法二,我们每向下遍历一层,就给 depth 加 1,可以理解为每条树枝的权重是 1,二叉树中每个节点的深度,其实就是从根节点到这个节点的路径权重和,且同一层的所有节点,路径权重和都是相同的。

那么假设,如果每条树枝的权重和可以是任意值,现在让你层序遍历整棵树,打印每个节点的路径权重和,你会怎么做?

写法三就是为了解决这个问题,在写法一的基础上添加一个 State 类,让每个节点自己负责维护自己的路径权重和,代码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 class State {public : TreeNode* node; int depth; State (TreeNode* node, int depth) : node (node), depth (depth) {} }; void levelOrderTraverse (TreeNode* root) if (root == nullptr ) { return ; } queue<State> q; q.push (State (root, 1 )); while (!q.empty ()) { State cur = q.front (); q.pop (); cout << "depth = " << cur.depth << ", val = " << cur.node->val << endl; if (cur.node->left != nullptr ) { q.push (State (cur.node->left, cur.depth + 1 )); } if (cur.node->right != nullptr ) { q.push (State (cur.node->right, cur.depth + 1 )); } } }

这样每个节点都有了自己的 depth 变量,是最灵活的,可以满足所有 BFS 算法的需求。

其实你很快就会学到,这种边带有权重的场景属于图结构算法,在之后的 BFS 算法习题集 和 dijkstra 算法 中,才会用到这种写法。

二叉树的遍历方式只有上面两种,也许有其他的写法,但都是表现形式上的差异,本质上不可能跳出上面两种遍历方式。

DFS 算法在寻找所有路径的问题中更常用。

而 BFS 算法在寻找最短路径的问题中更常用。

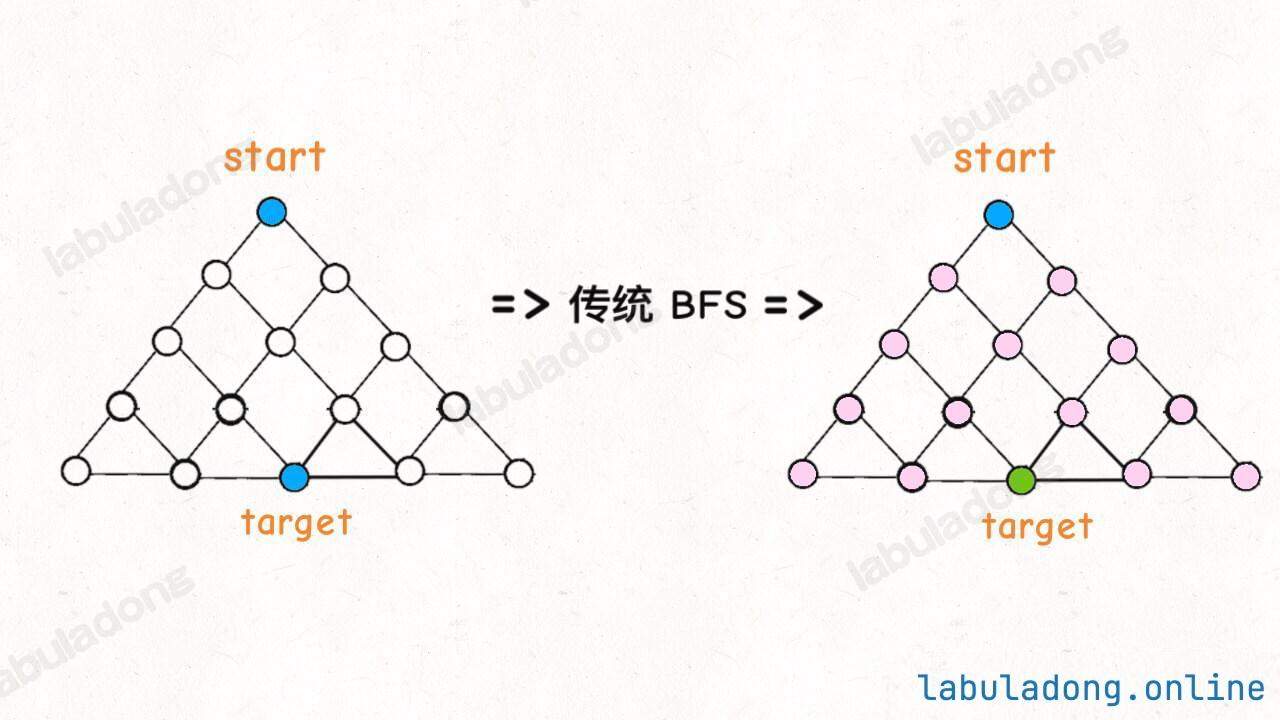

为什么 BFS 常用来寻找最短路径?

对于 DFS,你能不能在不遍历完整棵树的情况下,提前结束算法?DFS 遍历当然也可以用来寻找最短路径,但必须遍历完所有节点才能得到最短路径 。

对于 BFS,由于 BFS 逐层遍历的逻辑,第一次遇到目标节点时,所经过的路径就是最短路径,算法可能并不需要遍历完所有节点就能提前结束 。

从时间复杂度的角度来看,两种算法在最坏情况下都会遍历所有节点,时间复杂度都是 O ( N ) O(N) O ( N ) 寻找最短路径的问题中,BFS 算法是首选 。

为什么 DFS 常用来寻找所有路径?

(七) 多叉树

二叉树的节点长这样,每个节点有两个子节点。多叉树的节点长这样,每个节点有任意个子节点。就这点区别,其他没了。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 class TreeNode {public : int val; TreeNode* left; TreeNode* right; TreeNode (int v) : val (v), left (nullptr ), right (nullptr ) {} }; class Node {public : int val; vector<Node*> children; };

森林:森林就是多个多叉树的集合。一棵多叉树其实也是一个特殊的森林。

在并查集算法中,我们会同时持有多棵多叉树的根节点,那么这些根节点的集合就是一个森林。

1. 递归遍历(DFS)

唯一的区别是,多叉树没有了中序位置,因为可能有多个节点嘛,所谓的中序位置也就没什么意义了。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 void traverse (TreeNode* root) if (root == nullptr ) { return ; } traverse (root->left); traverse (root->right); } void traverse (Node* root) if (root == nullptr ) { return ; } for (Node* child : root->children) { traverse (child); } }

2. 层序遍历(BFS)

多叉树的层序遍历和 二叉树的层序遍历 一样,都是用队列来实现,无非就是把二叉树的左右子节点换成了多叉树的所有子节点。所以多叉树的层序遍历也有三种写法,下面一一列举。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 void levelOrderTraverse (Node* root) if (root == nullptr ) { return ; } std::queue<Node*> q; q.push (root); while (!q.empty ()) { Node* cur = q.front (); q.pop (); std::cout << cur->val << std::endl; for (Node* child : cur->children) { q.push (child); } } } #include <iostream> #include <queue> #include <vector> void levelOrderTraverse (Node* root) if (root == nullptr ) { return ; } std::queue<Node*> q; q.push (root); int depth = 1 ; while (!q.empty ()) { int sz = q.size (); for (int i = 0 ; i < sz; i++) { Node* cur = q.front (); q.pop (); std::cout << "depth = " << depth << ", val = " << cur->val << std::endl; for (Node* child : cur->children) { q.push (child); } } depth++; } } class State {public : Node* node; int depth; State (Node* node, int depth) : node (node), depth (depth) {} }; void levelOrderTraverse (Node* root) if (root == nullptr ) { return ; } std::queue<State> q; q.push (State (root, 1 )); while (!q.empty ()) { State state = q.front (); q.pop (); Node* cur = state.node; int depth = state.depth; std::cout << "depth = " << depth << ", val = " << cur->val << std::endl; for (Node* child : cur->children) { q.push (State (child, depth + 1 )); } } }

。

(八) 二叉树变种

1. 二叉搜索树

二叉搜索树是特殊的 二叉树结构,其主要的实际应用是 TreeMap 和 TreeSet。

对于树中的每个节点,其左子树的每个节点 的值都要小于这个节点的值,右子树的每个节点 的值都要大于这个节点的值。

这个左小右大 的特性,可以让我们在 BST 中快速找到某个节点,或者找到某个范围内的所有节点,这是 BST 的优势所在。

理想的时间复杂度是树的高度 O ( l o g N ) O(logN) O ( l o g N ) O ( N ) O(N) O ( N )

增删改的时间复杂度也是 O ( l o g N ) O(logN) O ( l o g N )

前文说复杂度是树的高度 O ( l o g N ) ( N 为节点总数) O(logN)(N 为节点总数) O ( l o g N ) ( N 为节点总数) 二叉搜索树要是平衡的,也就是左右子树的高度差不能太大 。O ( N ) O(N) O ( N ) O ( N ) O(N) O ( N )

二叉搜索树的性能取决于树的高度,树的高度取决于树的平衡性。 大家熟知的红黑树就是一类自平衡的二叉搜索树,它的平衡性能非常好,但是实现起来比较复杂,这就是完美所需付出的代价。

1 2 3 4 5 7 / \ 4 9 / \ \ 1 5 10

TreeMap/TreeSet 实现原理

它和前文介绍的 哈希表 HashMap 的结构是类似的,都是存储键值对 的,HashMap 底层把键值对存储在一个 table 数组里面,而 TreeMap 底层把键值对存储在一棵二叉搜索树的节点 里面。

至于 TreeSet,它和 TreeMap 的关系正如哈希表 HashMap 和哈希集合 HashSet 的关系一样,说白了就是 TreeMap 的简单封装,所以下面主要讲解 TreeMap 的实现原理。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 class TreeNode {public : int val; TreeNode* left; TreeNode* right; TreeNode (int x) : val (x), left (nullptr ), right (nullptr ) {} }; template <typename K, typename V>class TreeNode {public : K key; V value; TreeNode<K, V>* left; TreeNode<K, V>* right; TreeNode (K key, V value) : key (key), value (value), left (nullptr ), right (nullptr ) {} };

get 方法其实就类似上面可视化面板中查找目标节点的操作,根据目标 key 和当前节点的 key 比较,决定往左走还是往右走,可以一次性排除掉一半的节点,复杂度是 O ( log N ) O(\log N) O ( log N ) 至于 put, remove, containsKey 方法,其实也是要先利用 get 方法找到目标键所在的节点,然后做一些指针操作,复杂度都是 O ( log N ) O(\log N) O ( log N )

keys 方法返回所有键,且结果有序。可以利用 BST 的中序遍历结果有序的特性。

2. 红黑树

红黑树是自平衡的二叉搜索树,它的树高在任何时候都能保持在 O ( log N ) O(\log N) O ( log N ) O ( log N ) O(\log N) O ( log N )

3. Tire(字典树/前缀树)

Trie 树本质上就是一棵从二叉树衍生出来的多叉树。

Trie 树就是 多叉树结构 的延伸,是一种针对字符串进行特殊优化的数据结构。

Trie 树在处理字符串相关操作时有诸多优势,比如节省公共字符串前缀的内存空间、方便处理前缀操作、支持通配符匹配等。

这里要特别注意,TrieNode 节点本身只存储 val 字段,并没有一个字段来存储字符,字符是通过子节点在父节点的 children 数组中的索引确定的。形象理解就是,Trie 树用树枝 存储字符串(键),用节点 存储字符串(键)对应的数据(值)。所以我在图中把字符标在树枝,键对应的值 val 标在节点上:

1 2 3 4 5 6 template <typename V>struct TrieNode { V val = NULL ; TrieNode<V>* children[256 ] = { NULL }; };

这个 val 字段存储键对应的值,children 数组存储指向子节点的指针。但是和之前的普通多叉树节点不同,TrieNode 中 children 数组的索引是有意义的,代表键中的一个字符。

比如在实际做题时,题目说了只包含字符 a-z,那么你可以把大小改成 26;或者你不想用字符索引来映射,直接用哈希表 HashMap<Character, TrieNode> 也可以,都是一样的效果。

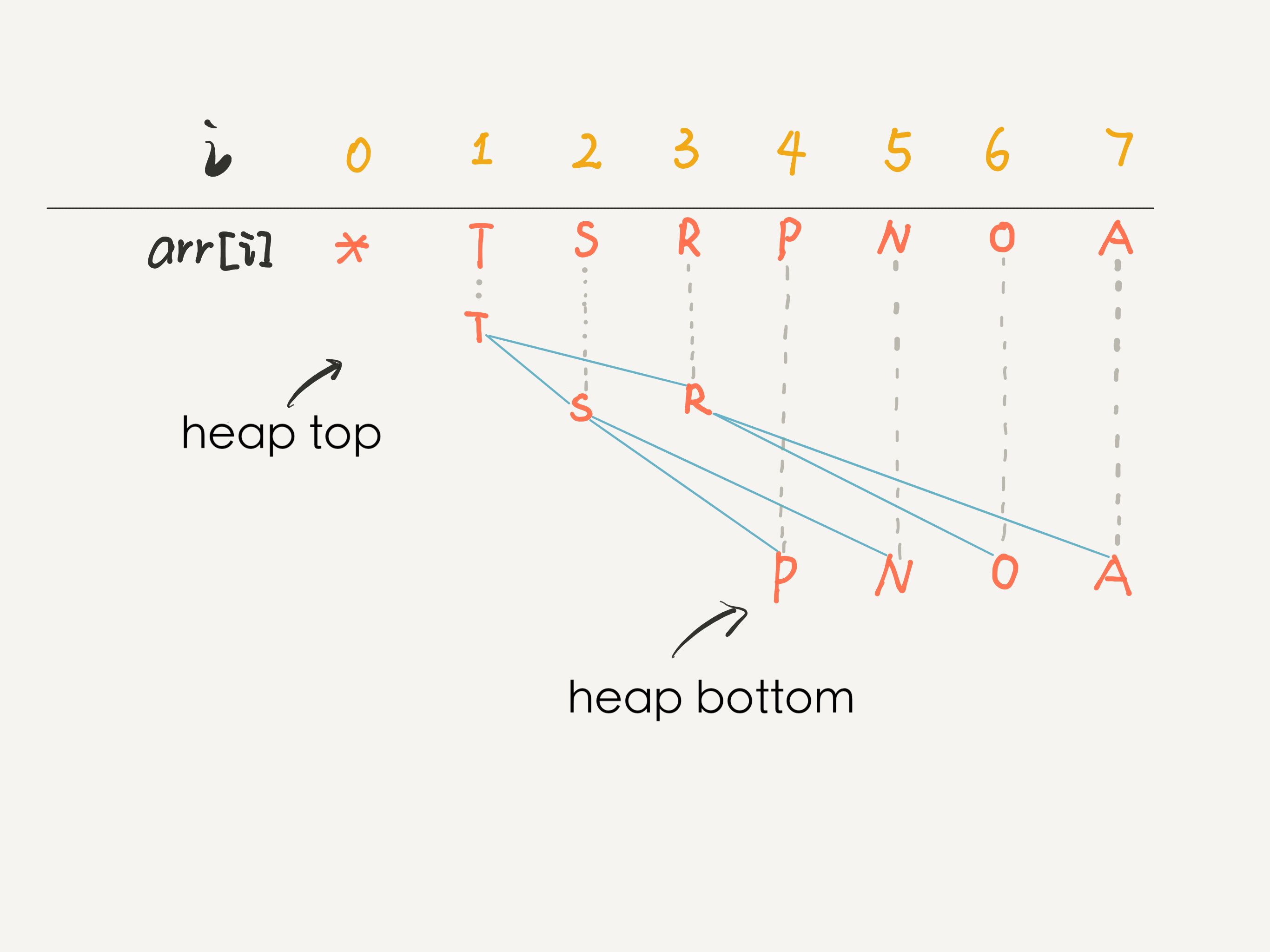

4. 二叉堆

二叉堆是一种能够动态排序的数据结构,是二叉树结构的延伸。

两个核心操作:下沉sink和上浮swim。

主要应用:优先队列priority_queue、堆排序heap_sort。

能够动态排序的数据结构,只有两个:1. 优先队列(底层采用二叉堆实现)2. 二叉搜索树

你可以认为二叉堆是一种特殊的二叉树,这棵二叉树上的任意节点的值,都必须大于等于(或小于等于)其左右子树所有 节点的值。如果是大于等于,我们称之为大顶堆,如果是小于等于,我们称之为小顶堆。

二叉堆可以辅助我们快速找到最大值或最小值。

二叉堆还有个性质:一个二叉堆的左右子堆(子树)也是一个二叉堆 。

应用 1:优先队列

自动排序是有代价的,注意优先级队列 API 的时间复杂度,增删元素 的复杂度是 O ( log N ) 其中 N 是当前二叉堆中的元素个数 O(\log N)其中 N 是当前二叉堆中的元素个数 O ( log N ) 其中 N 是当前二叉堆中的元素个数

标准队列是先进先出的顺序,而二叉堆可以理解为一种会自动排序的队列 ,所以叫做优先级队列感觉也挺贴切的。当然,你也一定要明白,虽然它的 API 像队列,但它的底层原理和二叉树有关,和队列没啥关系 。

以小顶堆为例,向小顶堆中插入 新元素遵循两个步骤:

以小顶堆为例,删除 小顶堆的堆顶元素遵循两个步骤:

在数组上模拟二叉树: O ( N ) O(N) O ( N ) push 和 pop 方法的时间复杂度退化到 O ( N ) O(N) O ( N ) O ( 1 ) O(1) O ( 1 ) 底层最右侧节点 。

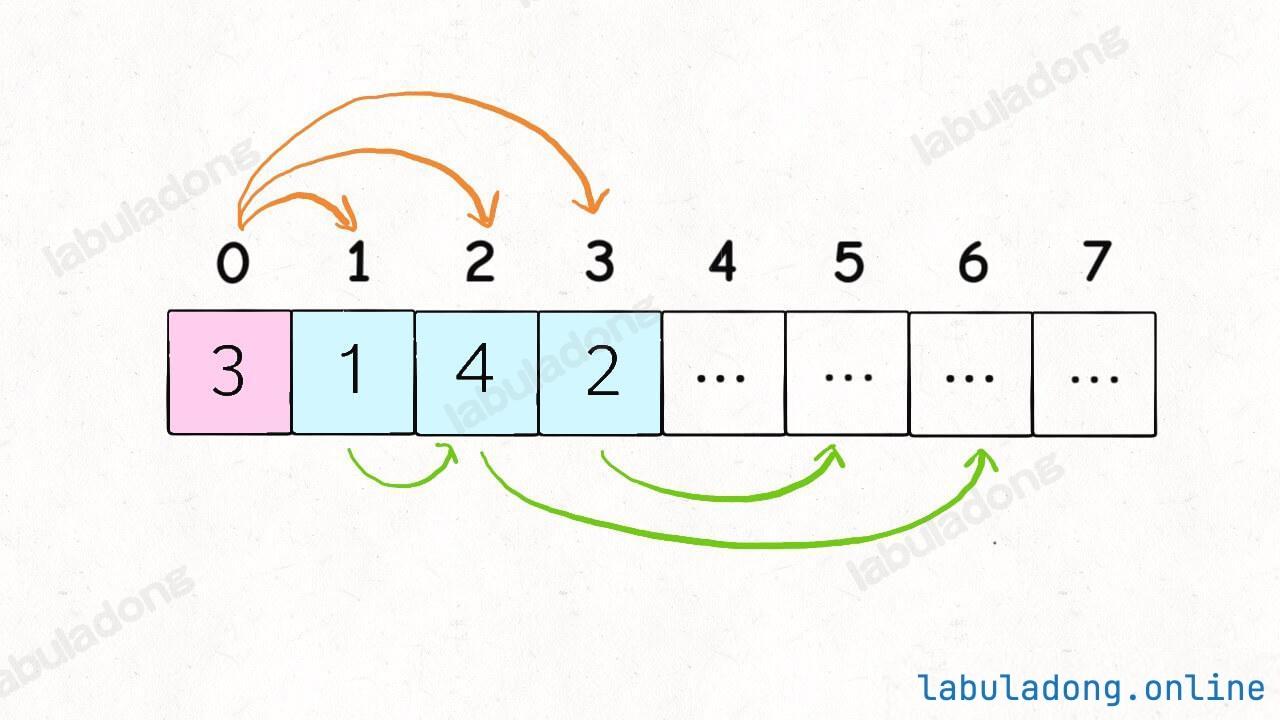

完全二叉树是关键:必须是完全二叉树 。

在这个数组中,索引 0 空着不用,就可以根据任意节点的索引计算出父节点或左右子节点的索引:

1 2 3 4 5 6 7 8 9 10 11 12 int parent (int node) return node / 2 ; } int left (int node) return node * 2 ; } int right (int node) return node * 2 + 1 ; }

其实从 0 开始也是可以的,稍微改一改计算公式就行了。

完整实现:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 #include <iostream> #include <vector> using namespace std;class SimpleMinPQ { vector<int > heap; int size; static int parent (int node) return (node - 1 ) / 2 ; } static int left (int node) return node * 2 + 1 ; } static int right (int node) return node * 2 + 2 ; } void swim (int node) while (node > 0 && heap[parent (node)] > heap[node]) { swap (heap[parent (node)], heap[node]); node = parent (node); } } void sink (int node) while (left (node) < size || right (node) < size) { int min = node; if (left (node) < size && heap[left (node)] < heap[min]) { min = left (node); } if (right (node) < size && heap[right (node)] < heap[min]) { min = right (node); } if (min == node) { break ; } swap (heap[node], heap[min]); node = min; } } public : SimpleMinPQ (int capacity) { heap.resize (capacity); size = 0 ; } int getSize () const return size; } int peek () return heap[0 ]; } void push (int x) heap[size] = x; swim (size); size++; } int pop () int res = heap[0 ]; heap[0 ] = heap[size - 1 ]; size--; sink (0 ); return res; } }; int main () SimpleMinPQ pq (5 ) ; pq.push (3 ); pq.push (2 ); pq.push (1 ); pq.push (5 ); pq.push (4 ); cout << pq.pop () << endl; cout << pq.pop () << endl; cout << pq.pop () << endl; cout << pq.pop () << endl; cout << pq.pop () << endl; return 0 ; }

应用 2:堆排序

它的原理特别简单,就相当于把一个乱序的数组都 push 到一个二叉堆(优先级队列)里面,然后再一个个 pop 出来,就得到了一个有序的数组。

1 2 3 4 5 6 7 8 9 10 11 12 vector<int > heapSort (vector<int >& arr) { vector<int > res (arr.size()) ; MyPriorityQueue pq; for (int x : arr) pq.push (x); for (int i = 0 ; i < arr.size (); i++) res[i] = pq.pop (); return res; }

当然,正常的堆排序算法的代码并不依赖优先级队列,且空间复杂度是 O ( 1 ) O(1) O ( 1 ) push 和 pop 的代码逻辑展开了,再加上直接在数组上原地建堆,这样就不需要额外的空间了。二叉树 是一种逻辑概念 ,并不是说只有 TreeNode 类构造出来的那个结构才是二叉树,其实数组也可以抽象成一棵树,一切分治穷举的思想都可以抽象成一棵树,递归函数的那个递归栈也可以理解成一棵树。

5. 线段树

线段树是二叉树结构的衍生,用于高效解决区间查询和动态修改的问题。

区间查询:O ( log n ) O(\log n) O ( log n )

动态修改单个元素:O ( log n ) O(\log n) O ( log n )

这棵二叉树的叶子节点是数组中的元素,非叶子节点就是索引区间(线段)的汇总信息。

希望对整个区间进行查询,同时支持动态修改元素的场景,是线段树结构的应用场景。

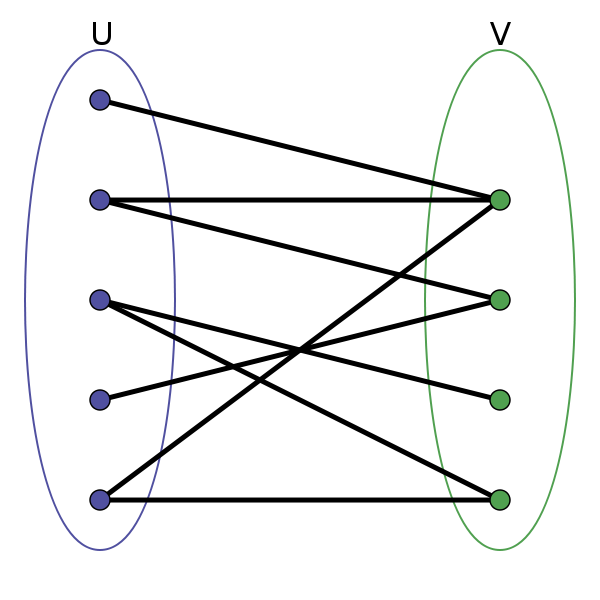

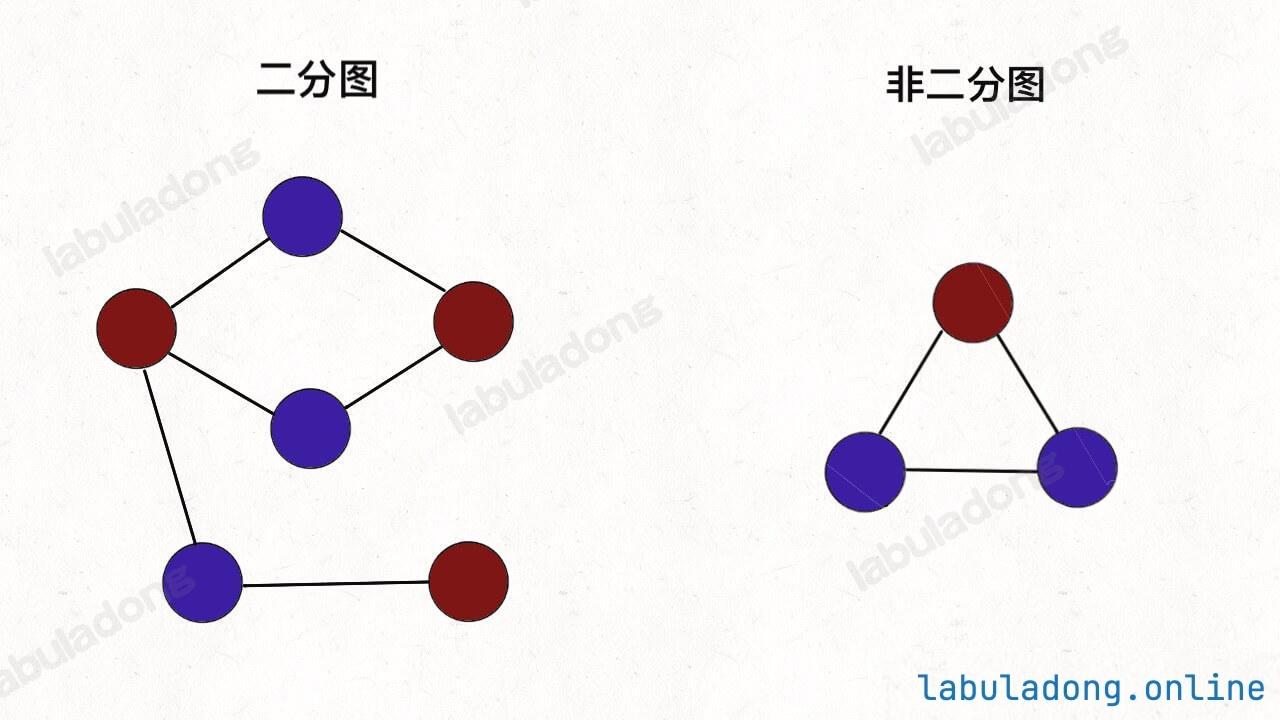

(九) 图论

1. 图结构

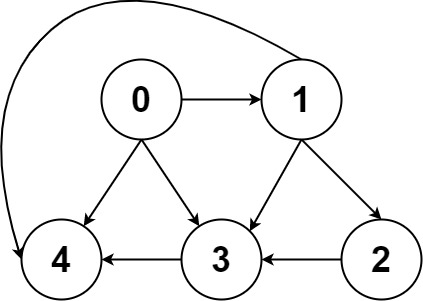

图结构就是 多叉树结构 的延伸。图结构逻辑上由若干节点(Vertex)和边(Edge)构成,我们一般用邻接表、邻接矩阵等方式来存储图。

在树结构中,只允许父节点指向子节点,不存在子节点指向父节点的情况,子节点之间也不会互相链接;而图中没有那么多限制,节点之间可以相互指向,形成复杂的网络结构。

图的逻辑结构:一幅图是由节点 (Vertex) 和边 (Edge) 构成的,逻辑结构如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 class Vertex {public : int id; std::vector<Vertex*> neighbors; }; vector<vector<int >> graph; vector<vector<bool >> matrix; class TreeNode {public : int val; std::vector<TreeNode*> children; };

节点类型不是 int 怎么办? 哈希表 ,把实际节点和整数 id 映射起来,然后就可以用邻接表和邻接矩阵存储整数 id 了。对于一幅有 V V V E E E O ( V + E ) O(V+E) O ( V + E ) O ( V 2 ) O(V^2) O ( V 2 ) 邻接表 的使用更多一些。邻接矩阵的最大优势在于,矩阵是一个强有力的数学工具 ,图的一些隐晦性质可以借助精妙的矩阵运算展现出来。不过本文不准备引入数学内容,所以有兴趣的读者可以自行搜索学习。这也是为什么一定要把图节点类型转换成整数 id 的原因 ,不然的话你怎么用矩阵运算呢?

完整实现(邻接表):

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 #include <iostream> #include <vector> #include <stdexcept> using namespace std;class WeightedDigraph {public : struct Edge { int to; int weight; Edge (int to, int weight) { this ->to = to; this ->weight = weight; } }; private : vector<vector<Edge>> graph; public : WeightedDigraph (int n) { graph = vector<vector<Edge>>(n); } void addEdge (int from, int to, int weight) graph[from].emplace_back (to, weight); } void removeEdge (int from, int to) for (auto it = graph[from].begin (); it != graph[from].end (); ++it) { if (it->to == to) { graph[from].erase (it); break ; } } } bool hasEdge (int from, int to) for (const auto & e : graph[from]) { if (e.to == to) { return true ; } } return false ; } int weight (int from, int to) for (const auto & e : graph[from]) { if (e.to == to) { return e.weight; } } throw invalid_argument ("No such edge" ); } const vector<Edge>& neighbors (int v) return graph[v]; } }; int main () WeightedDigraph graph (3 ) ; graph.addEdge (0 , 1 , 1 ); graph.addEdge (1 , 2 , 2 ); graph.addEdge (2 , 0 , 3 ); graph.addEdge (2 , 1 , 4 ); cout << boolalpha << graph.hasEdge (0 , 1 ) << endl; cout << boolalpha << graph.hasEdge (1 , 0 ) << endl; for (const auto & edge : graph.neighbors (2 )) { cout << "2 -> " << edge.to << ", wight: " << edge.weight << endl; } graph.removeEdge (0 , 1 ); cout << boolalpha << graph.hasEdge (0 , 1 ) << endl; return 0 ; }

完整实现(邻接矩阵):

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 #include <iostream> #include <vector> class WeightedDigraph {public : struct Edge { int to; int weight; Edge (int to, int weight) : to (to), weight (weight) {} }; WeightedDigraph (int n) { matrix = std::vector<std::vector<int >>(n, std::vector <int >(n, 0 )); } void addEdge (int from, int to, int weight) matrix[from][to] = weight; } void removeEdge (int from, int to) matrix[from][to] = 0 ; } bool hasEdge (int from, int to) return matrix[from][to] != 0 ; } int weight (int from, int to) return matrix[from][to]; } std::vector<Edge> neighbors (int v) { std::vector<Edge> res; for (int i = 0 ; i < matrix[v].size (); i++) { if (matrix[v][i] > 0 ) { res.push_back (Edge (i, matrix[v][i])); } } return res; } private : std::vector<std::vector<int >> matrix; }; int main () WeightedDigraph graph (3 ) ; graph.addEdge (0 , 1 , 1 ); graph.addEdge (1 , 2 , 2 ); graph.addEdge (2 , 0 , 3 ); graph.addEdge (2 , 1 , 4 ); std::cout << std::boolalpha; std::cout << graph.hasEdge (0 , 1 ) << std::endl; std::cout << graph.hasEdge (1 , 0 ) << std::endl; for (const auto & edge : graph.neighbors (2 )) { std::cout << "2 -> " << edge.to << ", weight: " << edge.weight << std::endl; } graph.removeEdge (0 , 1 ); std::cout << graph.hasEdge (0 , 1 ) << std::endl; return 0 ; }

2. 图的遍历

图的遍历就是 多叉树遍历 的延伸,主要遍历方式还是深度优先搜索(DFS)和 广度优先搜索(BFS) 。

唯一的区别是,树结构中不存在环,而图结构中可能存在环 ,所以我们需要标记遍历过的节点 ,避免遍历函数在环中死循环。

遍历图的「节点」和「路径」略有不同,遍历「节点 」时,需要 visited 数组在前序位置 标记节点;遍历图的所有「路径 」时,需要 onPath 数组在前序位置 标记节点,在后序位置 撤销标记。

深度优先搜索(DFS)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 class Node {public : int val; std::vector<Node*> children; }; void traverse (Node* root) if (root == nullptr ) { return ; } std::cout << "visit " << root->val << std::endl; for (auto child : root->children) { traverse (child); } } class Vertex {public : int id; std::vector<Vertex*> neighbors; }; void traverse (Vertex* s, std::vector<bool >& visited) if (s == nullptr ) { return ; } if (visited[s->id]) { return ; } visited[s->id] = true ; std::cout << "visit " << s->id << std::endl; for (auto neighbor : s->neighbors) { traverse (neighbor); } }

(2)遍历所有路径(onPath 数组)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 vector<bool > onPath (graph.size()) ;list<int > path; void traverse (Graph& graph, int src, int dest) if (src < 0 || src >= graph.size ()) { return ; } if (onPath[src]) { return ; } onPath[src] = true ; path.push_back (src); if (src == dest) { cout << "find path: " ; for (int node : path) { cout << node << " " ; } cout << endl; } for (const Edge& e : graph.neighbors (src)) { traverse (graph, e.to, dest); } path.pop_back (); onPath[src] = false ; }

(3)同时使用 visited 和 onPath 数组剪枝 ,提前排除一些不符合条件的路径,从而降低复杂度。

(4)完全不用 visited 和 onPath 数组题目告诉你输入的图结构不包含环 ,那么你就不需要考虑成环的情况了。

广度优先搜索(BFS)

图结构的广度优先搜索其实就是 多叉树的层序遍历 ,无非就是加了一个 visited 数组来避免重复遍历节点 。

理论上 BFS 遍历也需要区分遍历所有「节点」和遍历所有「路径」,但是实际上 BFS 算法一般只用来寻找那条最短路径 ,不会用来求所有路径。

(1)写法一:不记录遍历步数

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 void levelOrderTraverse (Node* root) if (root == nullptr ) { return ; } std::queue<Node*> q; q.push (root); while (!q.empty ()) { Node* cur = q.front (); q.pop (); std::cout << cur->val << std::endl; for (Node* child : cur->children) { q.push (child); } } } void bfs (const Graph& graph, int s) std::vector<bool > visited (graph.size(), false ) ; std::queue<int > q; q.push (s); visited[s] = true ; while (!q.empty ()) { int cur = q.front (); q.pop (); std::cout << "visit " << cur << std::endl; for (const Edge& e : graph.neighbors (cur)) { if (!visited[e.to]) { q.push (e.to); visited[e.to] = true ; } } } }

(2)写法二:记录遍历步数

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 void levelOrderTraverse (Node* root) if (root == nullptr ) { return ; } queue<Node*> q; q.push (root); int depth = 1 ; while (!q.empty ()) { int sz = q.size (); for (int i = 0 ; i < sz; i++) { Node* cur = q.front (); q.pop (); cout << "depth = " << depth << ", val = " << cur->val << endl; for (Node* child : cur->children) { q.push (child); } } depth++; } } void bfs (const Graph& graph, int s) vector<bool > visited (graph.size(), false ) ; queue<int > q; q.push (s); visited[s] = true ; int step = 0 ; while (!q.empty ()) { int sz = q.size (); for (int i = 0 ; i < sz; i++) { int cur = q.front (); q.pop (); cout << "visit " << cur << " at step " << step << endl; for (const Edge& e : graph.neighbors (cur)) { if (!visited[e.to]) { q.push (e.to); visited[e.to] = true ; } } } step++; } }

(3)写法三:适配不同权重边

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 class State {public : Node* node; int depth; State (Node* node, int depth) : node (node), depth (depth) {} }; void levelOrderTraverse (Node* root) if (root == nullptr ) { return ; } queue<State> q; q.push (State (root, 1 )); while (!q.empty ()) { State state = q.front (); q.pop (); Node* cur = state.node; int depth = state.depth; cout << "depth = " << depth << ", val = " << cur->val << endl; for (Node* child : cur->children) { q.push (State (child, depth + 1 )); } } } class State {public : int node; int weight; State (int node, int weight) : node (node), weight (weight) {} }; void bfs (const Graph& graph, int s) vector<bool > visited (graph.size(), false ) ; queue<State> q; q.push (State (s, 0 )); visited[s] = true ; while (!q.empty ()) { State state = q.front (); q.pop (); int cur = state.node; int weight = state.weight; cout << "visit " << cur << " with path weight " << weight << endl; for (const Edge& e : graph.neighbors (cur)) { if (!visited[e.to]) { q.push (State (e.to, weight + e.weight)); visited[e.to] = true ; } } } }

3. 并查集

并查集 Union Find 是一种二叉树结构的衍生,用于高效解决无向图的连通性 问题。

查询两个节点是否连通:O ( 1 ) O(1) O ( 1 )

合并两个连通分量:O ( 1 ) O(1) O ( 1 )

查询连通分量的个数:O ( 1 ) O(1) O ( 1 )

你单纯去查邻接表/邻接矩阵,只能判断两个节点是否直接 相连,而无法处理这种传递 的连通关系。

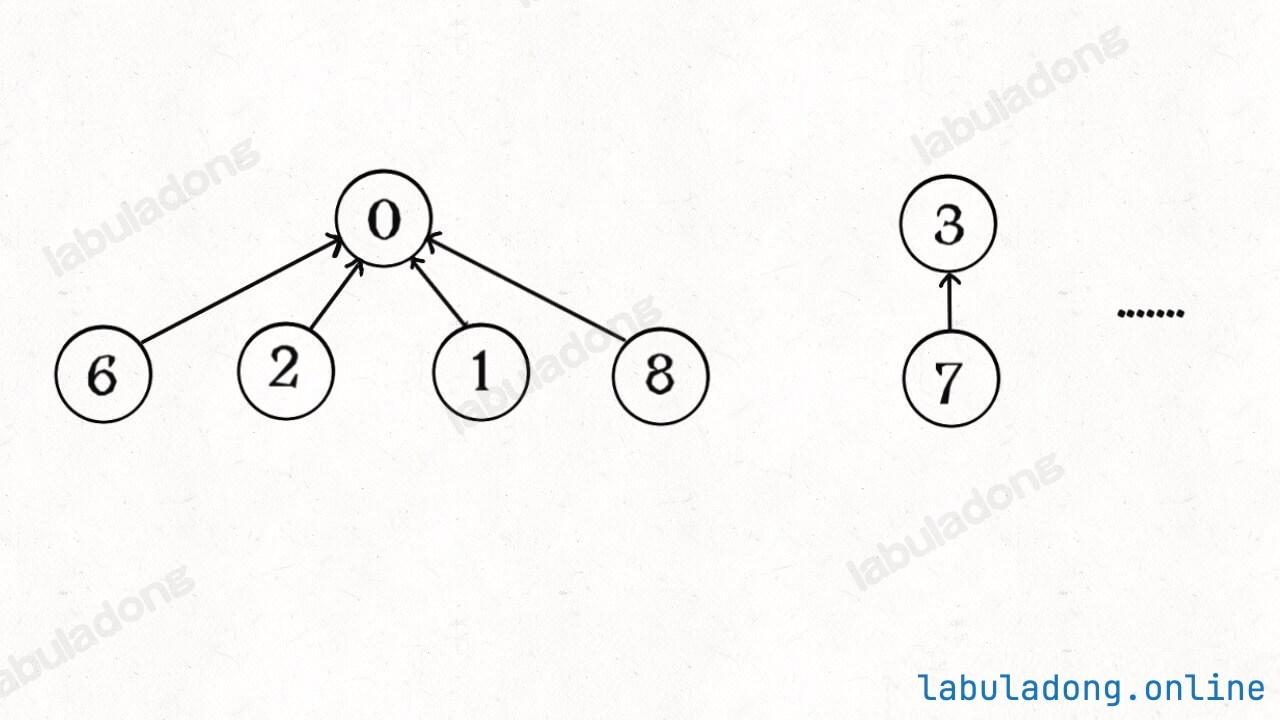

如果我们想办法把同一个连通分量的节点 都放到同一棵树 中,把这棵树的根节点 作为这个连通分量的代表,那么我们就可以高效实现上面的操作了。

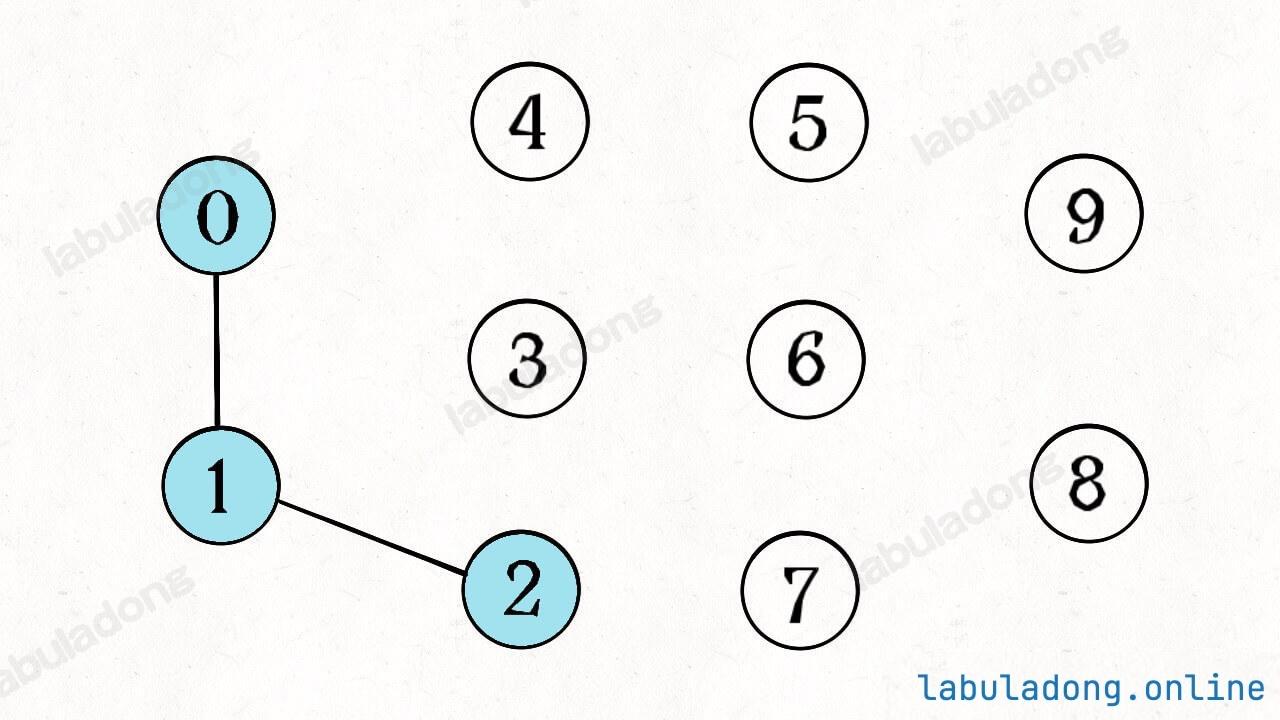

并查集底层其实是一片森林(若干棵多叉树) ,每棵树代表一个连通分量 :

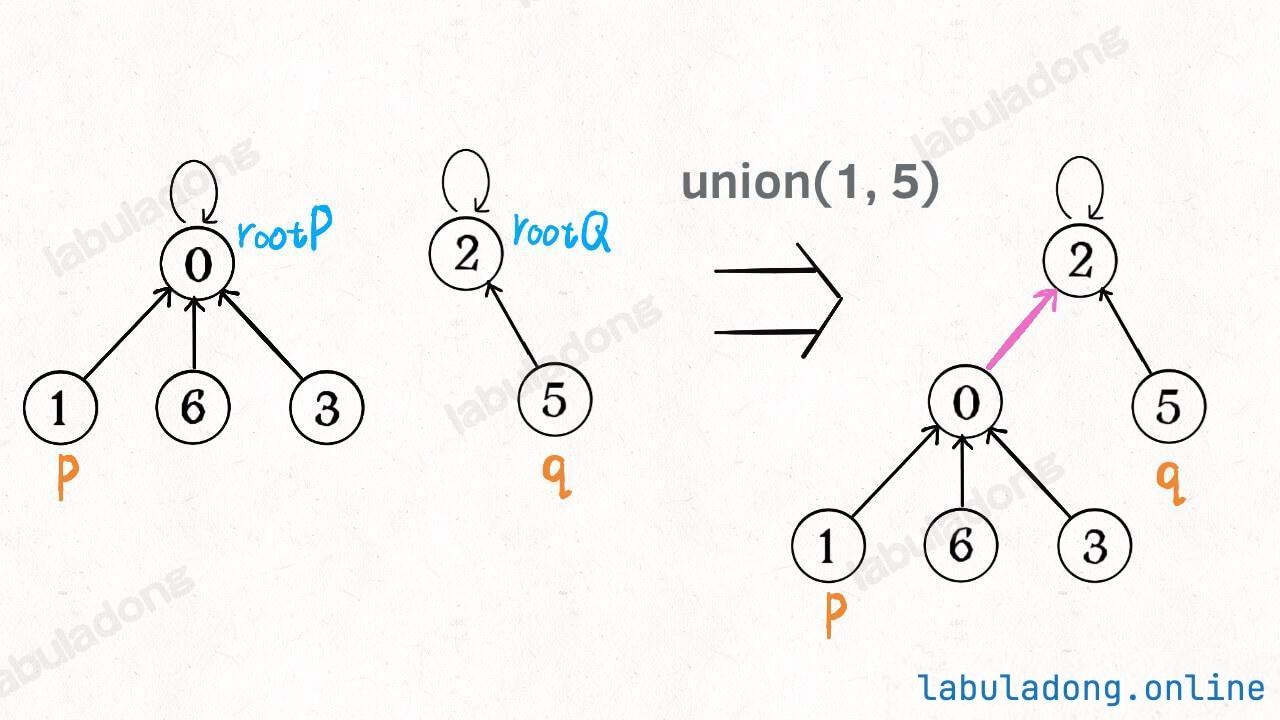

connected(p, q):只需要判断 p 和 q 所在的多叉树的根节点 ,若相同 ,则 p 和 q 在同一棵树中,即连通,否则不连通。count():只需要统计一下总共有多少棵树 ,即可得到连通分量的数量。union(p, q):只需要将 p 节点所在的这棵树的根节点,接入到 q 节点所在的这棵树的根节点下面,即可完成连接操作。注意这里并不是 p, q 两个节点的合并,而是两棵树根节点的合并 。因为 p, q 一旦连通,那么他们所属的连通分量就合并成了同一个更大的连通分量。每个节点其实不在乎自己的子节点是谁 ,只在乎自己的根节点是谁 ,所以一个并查集节点类似于下面这样:

所以并查集算法最终的目标 ,就是要尽可能降低树的高度 ,如果能保持树高为常数,那么上述方法的复杂度就都是 O ( 1 ) O(1) O ( 1 )

(1)权重数组的优化效果union 操作都是将节点个数较多的树接到了节点个数较少的树下面,这就很容易让树高增加,很不明智。一种优化思路是引入一个权重数组,记录以每个节点的为根的树的节点个数,然后在 union 方法中,总是将节点个数较少的树接到节点个数较多的树下面,这样可以保证树尽可能平衡,树高也就不会线性增长。

(2)路径压缩的优化效果O ( 1 ) O(1) O ( 1 ) O ( 1 ) O(1) O ( 1 )

(十) 十大排序

排序算法的关键指标

时空复杂度

排序稳定性

是否原地排序

1. 选择排序

选择排序是最简单朴素的排序算法,但是时间复杂度较高,且不是稳定排序。其他基础排序算法都是基于选择排序的优化。

每次都去遍历选择最小的元素。

分析:

选择排序算法是个不稳定排序算法,因为每次都要交换最小元素和当前元素的位置,这样可能会改变相同元素的相对位置。

选择排序的时间复杂度和初始数据的有序度完全没有关系,即便输入的是一个已经有序的数组,选择排序的时间复杂度依然是 O ( n 2 ) O(n^2) O ( n 2 )

选择排序的时间复杂度是 O ( n 2 ) O(n^2) O ( n 2 ) n 2 / 2 n^2 / 2 n 2 /2

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 void sort (vector<int >& nums) int n = nums.size (); int sortedIndex = 0 ; while (sortedIndex < n) { int minIndex = sortedIndex; for (int i = sortedIndex + 1 ; i < n; i++) { if (nums[i] < nums[minIndex]) { minIndex = i; } } int tmp = nums[sortedIndex]; nums[sortedIndex] = nums[minIndex]; nums[minIndex] = tmp; sortedIndex++; } }

2. 冒泡排序(解决稳定)

冒泡算法是对 选择排序 的一种优化,通过交换 nums[sortedIndex] 右侧的逆序对完成排序,是一种稳定 排序算法。

优化的方向就在这里,你不要图省事儿直接把本次查找的最小的直接一次交换到前面;而应该一步一步交换,慢慢到最前面。

这个算法的名字叫做冒泡排序,因为它的执行过程就像从数组尾部向头部冒出水泡,每次都会将最小值顶到正确的位置。

如果一次交换操作都没有进行,说明数组已经有序,可以提前终止算法。

唯一的遗憾是,时间复杂度依然是 O ( n 2 ) O(n^2) O ( n 2 )

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 void sort (int [] nums) int n = nums.length; int sortedIndex = 0 ; while (sortedIndex < n) { for (int i = n - 1 ; i > sortedIndex; i--) { if (nums[i] < nums[i - 1 ]) { int tmp = nums[i]; nums[i] = nums[i - 1 ]; nums[i - 1 ] = tmp; } } sortedIndex++; } }

3. 插入排序(逆向提高效率)

插入排序是基于 选择排序 的一种优化,将 nums[sortedIndex] 插入到左侧的有序数组中。对于有序度较高的数组,插入排序的效率比较高。

选择排序和冒泡排序是在 nums[sortedIndex..] 中找到最小值,然后将其插入到 nums[sortedIndex] 的位置。

那么我们能不能反过来想,在 nums[0..sortedIndex-1] 这个部分有序的数组中,找到 nums[sortedIndex] 应该插入的位置插入。

这个算法的名字叫做插入排序,它的执行过程就像是打扑克牌时,将新抓到的牌插入到手中已经排好序的牌中。

插入排序的空间复杂度 是 O ( 1 ) O(1) O ( 1 ) 原地 排序算法。时间复杂度 是 O ( n 2 ) O(n^2) O ( n 2 ) n 2 / 2 n^2 / 2 n 2 /2

插入排序是一种稳定 排序,因为只有在 nums[i] < nums[i - 1] 的情况下才会交换元素,所以相同元素的相对位置不会发生改变。

初始有序度越高,效率越高。插入排序的综合性能应该要高于冒泡排序。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 void sort (int [] nums) int n = nums.length; int sortedIndex = 0 ; while (sortedIndex < n) { for (int i = sortedIndex; i > 0 ; i--) { if (nums[i] < nums[i - 1 ]) { int tmp = nums[i]; nums[i] = nums[i - 1 ]; nums[i - 1 ] = tmp; } else { break ; } } sortedIndex++; } }

4. 希尔排序(突破n^2)

希尔排序是基于 插入排序 的简单改进,通过预处理增加数组的局部有序性,突破了插入排序的 O ( N 2 ) O(N^2) O ( N 2 )

希尔排序是不稳定 排序。这个比较容易理解吧,当 h 大于 1 时进行的排序操作,就可能打乱相同元素的相对位置了。

空间复杂度是 O ( 1 ) O(1) O ( 1 ) 原地 排序算法。

希尔排序的时间复杂度是小于 O ( N 2 ) O(N^2) O ( N 2 )

h 有序数组:一个数组是 h 有序的,是指这个数组中任意间隔为 h(或者说间隔元素的个数为 h-1)的元素都是有序的。当一个数组完成排序的时候,其实就是 1 有序数组。

1 2 3 4 5 6 7 8 9 nums: [1, 2, 4, 3, 5, 7, 8, 6, 10, 9, 12, 11] ^--------^--------^---------^ ^--------^--------^---------^ ^--------^--------^----------^ 1--------3--------8---------9 2--------5--------6---------12 4--------7--------10---------11

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 void sort (int [] nums) int n = nums.length; int h = 1 ; while (h < n / 2 ) { h = 2 * h; } while (h >= 1 ) { int sortedIndex = h; while (sortedIndex < n) { for (int i = sortedIndex; i >= h; i -= h) { if (nums[i] < nums[i - h]) { int tmp = nums[i]; nums[i] = nums[i - h]; nums[i - h] = tmp; } else { break ; } } sortedIndex++; } h /= 2 ; } }

希尔排序的性能和递增函数的选择 有很大关系,上面的代码中我们使用的递增函数是 2 k − 1 2^k−1 2 k − 1 ( 3 k − 1 ) / 2 (3^k−1)/2 ( 3 k − 1 ) /2 1,4,13,40,121,364...

1 2 3 4 5 6 7 8 9 10 int h = 1 ;while (h < n / 3 ) { h = 3 * h + 1 ; } .... h /= 3 ; ....

5. 快速排序(二叉树前序位置)

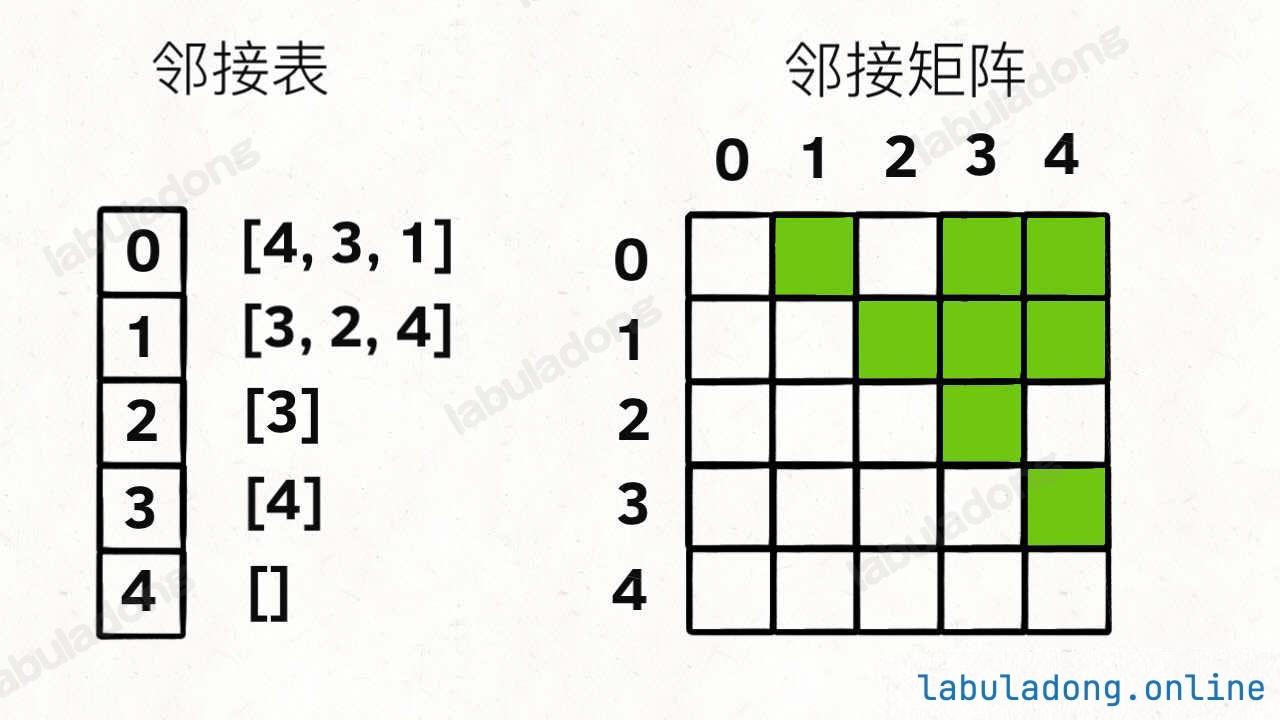

快速排序的核心思路需要结合 二叉树的前序遍历 来理解:在二叉树遍历的前序位置将一个元素排好位置,然后递归地将剩下的元素排好位置。

快速排序的思路是:先把一个元素排好序,然后去把剩下的元素排好序。

任意选择一个元素作为切分元素 pivot(一般选择第一个元素)

对数组中的元素进行若干交换操作,将小于 pivot 的元素放到 pivot 的左边,大于 pivot 的元素放到 pivot 的右边(换句话说,其实就是将 pivot 这一个元素排好序 )

递归的去把 pivot 左右两侧的其他元素排好序 。

本质是二叉树的前序遍历,在前序位置将 nums[p] 排好序,然后递归排序左右元素

其中 partition 函数的实现是快速排序的核心,即遍历 nums[lo..hi],将切分点元素 pivot 放到正确的位置,并返回该位置的索引 p。

每层元素总和仍然是 O ( n ) O(n) O ( n ) O ( log n ) O(\log n) O ( log n ) O ( n log n ) O(n\log n) O ( n log n )

快速排序不需要额外的辅助空间,是原地排序算法。递归遍历二叉树时,递归函数的堆栈深度为树的高度,所以空间复杂度是 O ( log n ) O(\log n) O ( log n )

快速排序是不稳定 排序算法,因为在 partition 函数中,不会考虑相同元素的相对位置。

1 2 3 4 5 6 7 8 9 10 11 void sort (int nums[], int lo, int hi) if (lo >= hi) { return ; } int p = partition (nums, lo, hi); sort (nums, lo, p - 1 ); sort (nums, p + 1 , hi); }

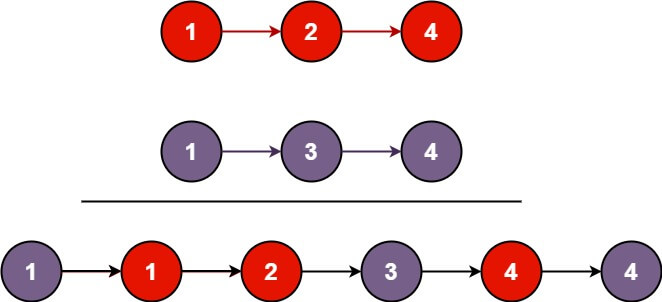

6. 归并排序(二叉树后序位置)

归并排序的核心思路需要结合 二叉树的后序遍历 来理解:先利用递归把左右两半子数组排好序,然后在二叉树的后序位置合并 两个有序数组。

归并排序的稳定性取决于 merge 函数的实现,需要用到 双指针技巧 ,是稳定 排序。

每层元素总和仍然是 O ( n ) O(n) O ( n ) O ( log n ) O(\log n) O ( log n ) O ( n log n ) O(n\log n) O ( n log n )

不是原地 排序。归并排序的 merge 函数需要一个额外的数组来辅助进行有序数组的合并操作,消耗 O ( n ) O(n) O ( n )

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 void sort (int [] nums, int lo, int hi) if (lo == hi) { return ; } int mid = (lo + hi) / 2 ; sort (nums, lo, mid); sort (nums, mid + 1 , hi); merge (nums, lo, mid, hi); }

7. 堆排序(运用二叉堆)

堆排序是从 二叉堆结构 衍生出来的排序算法,复杂度为 O ( N log N ) O(N\log N) O ( N log N )

堆排序主要分两步,第一步是在待排序数组上原地创建二叉堆 (Heapify),然后进行原地排序 (Sort)。

堆排序是一种不稳定 的排序算法,因为二叉堆本质上是把数组结构抽象成了二叉树结构,在二叉树逻辑结构上的元素交换操作映射回数组上,无法顾及相同元素的相对位置。

分析:

二叉堆(优先级队列)底层是用数组 实现的,但是逻辑上是一棵完全二叉树 ,主要依靠 上浮swim, 下沉sink 方法来维护堆的性质。

优先级队列可以分为小顶堆 和大顶堆 ,小顶堆会将整个堆中最小的元素维护在堆顶,大顶堆会将整个堆中最大的元素维护在堆顶。

优先级队列插入 元素时:首先把元素追加到二叉堆底部 ,然后调用 swim 方法把该元素上浮 到合适的位置,时间复杂度是 O ( log N ) O(\log N) O ( log N )

优先级队列删除 堆顶元素时:首先把堆底的最后一个元素交换到堆顶 作为新的堆顶元素,然后调用 sink 方法把这个新的堆顶元素下沉 到合适的位置,时间复杂度是 O ( log N ) O(\log N) O ( log N )

那么最简单的堆排序算法思路就是直接利用优先级队列,把所有元素塞到优先级队列里面,然后再取出来,就完成排序了。

优先级队列的 push, pop 方法的复杂度都是 O ( log N ) O(\log N) O ( log N ) O ( N log N ) O(N\log N) O ( N log N )

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 void sort (int [] nums) SimpleMinPQ pq = new SimpleMinPQ (nums.length); for (int num : nums) { pq.push (num); } for (int i = 0 ; i < nums.length; i++) { nums[i] = pq.pop (); } }

堆排序的两个关键步骤:

原地建堆(Heapify):直接把待排序数组原地变成一个二叉堆。

排序(Sort):将元素不断地从堆中取出,最终得到有序的结果。

时间复杂度,假设 nums 的元素个数为 N:

第一步建堆的过程中,swim 方法的时间复杂度是 O ( log N ) O(\log N) O ( log N ) swim 方法,所以总时间复杂度是 O ( N log N ) O(N\log N) O ( N log N )

第二步排序的过程中,每次 sink 方法的时间复杂度是 O ( log N ) O(\log N) O ( log N ) sink 方法,所以总时间复杂度是 O ( N log N ) O(N\log N) O ( N log N ) O ( N log N ) O(N\log N) O ( N log N )

空间复杂度是 O ( 1 ) O(1) O ( 1 )

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 void minHeapSwim (std::vector<int >& heap, int node) while (node > 0 && heap[parent (node)] > heap[node]) { swap (heap, parent (node), node); node = parent (node); } } void minHeapSink (std::vector<int >& heap, int node, int size) while (left (node) < size || right (node) < size) { int min = node; if (left (node) < size && heap[left (node)] < heap[min]) { min = left (node); } if (right (node) < size && heap[right (node)] < heap[min]) { min = right (node); } if (min == node) { break ; } swap (heap, node, min); node = min; } } void maxHeapSwim (std::vector<int >& heap, int node) while (node > 0 && heap[parent (node)] < heap[node]) { swap (heap, parent (node), node); node = parent (node); } } void maxHeapSink (std::vector<int >& heap, int node, int size) while (left (node) < size || right (node) < size) { int max = node; if (left (node) < size && heap[left (node)] > heap[max]) { max = left (node); } if (right (node) < size && heap[right (node)] > heap[max]) { max = right (node); } if (max == node) { break ; } swap (heap, node, max); node = max; } } int parent (int node) return (node - 1 ) / 2 ; } int left (int node) return node * 2 + 1 ; } int right (int node) return node * 2 + 2 ; } void swap (std::vector<int >& heap, int i, int j) int temp = heap[i]; heap[i] = heap[j]; heap[j] = temp; } void sort (std::vector<int >& nums) for (int i = 0 ; i < nums.size (); i++) { maxHeapSwim (nums, i); } int heapSize = nums.size (); while (heapSize > 0 ) { swap (nums, 0 , heapSize - 1 ); heapSize--; maxHeapSink (nums, 0 , heapSize); } }

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 void sort (int [] nums) for (int i = 0 ; i < nums.length; i++) { maxHeapSwim (nums, i); } int heapSize = nums.length; while (heapSize > 0 ) { swap (nums, 0 , heapSize - 1 ); heapSize--; maxHeapSink (nums, 0 , heapSize); } }

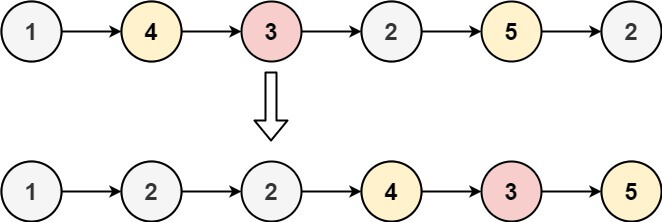

再优化:对于一个二叉堆来说,其左右子堆(子树)也是一个二叉堆 。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 void sort (vector<int >& nums) int n = nums.size (); for (int i = n / 2 - 1 ; i >= 0 ; i--) { maxHeapSink (nums, i, n); } int heapSize = n; while (heapSize > 0 ) { swap (nums, 0 , heapSize - 1 ); heapSize--; maxHeapSink (nums, 0 , heapSize); } }

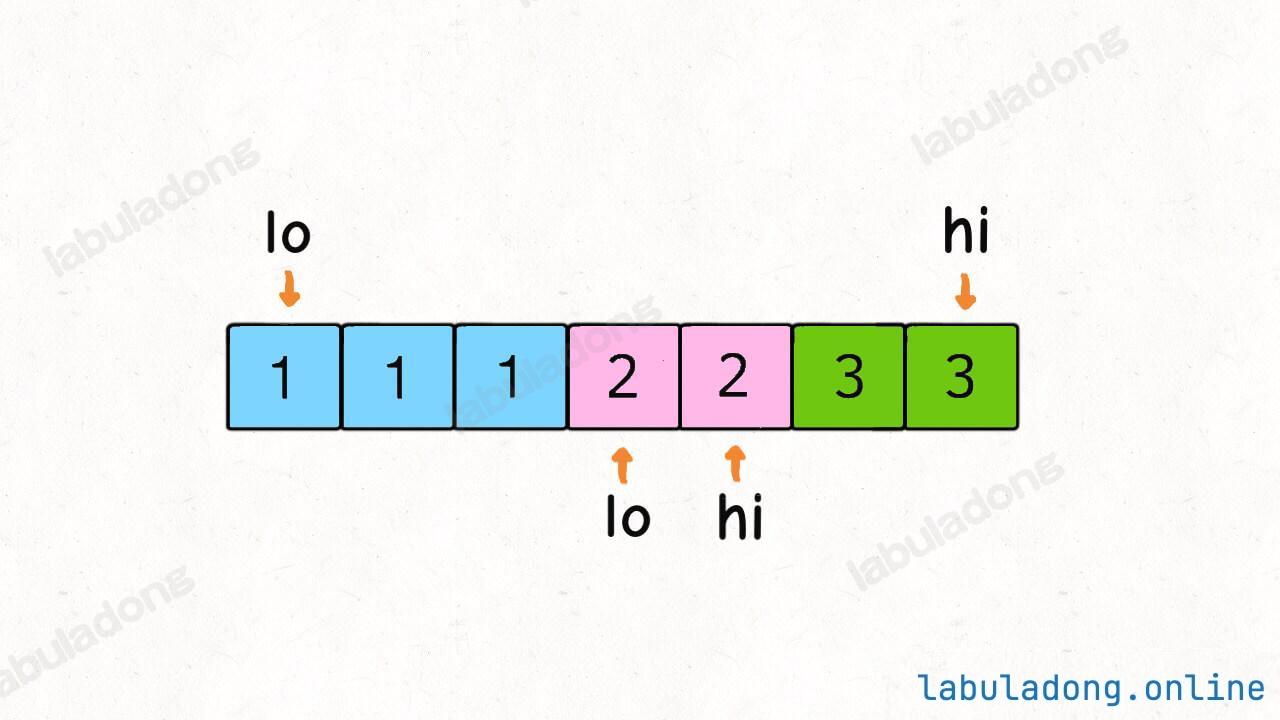

8. 计数排序(新原理)

计数排序的原理比较简单:统计每种元素出现的次数,进而推算出每个元素在排序后数组中的索引位置,最终完成排序。

在它的算法思想中同时看到前面讲的 归并排序 和 计数排序 的影子。

计数排序的时间和空间复杂度都是 O ( n + m a x − m i n ) ,其中 n 是待排序数组长度, m a x − m i n 是待排序数组的元素范围 O(n+max−min),其中 n 是待排序数组长度,max−min 是待排序数组的元素范围 O ( n + ma x − min ) ,其中 n 是待排序数组长度, ma x − min 是待排序数组的元素范围

处理负数和自定义类型:简单映射技巧

非比较排序:计数排序都不需要比较元素的大小,代码中不包含 if (nums[i] > nums[j]) 这样的比较逻辑,那么到底是什么让他能够完成排序呢?答案是,它依靠数组索引的有序性 ,所以不用对元素进行比较。(也因此,不能使用哈希表作为 count计数数组。

计数排序以及后面介绍到的其他非比较排序算法,在特定场景下的时间复杂度是线性 的O ( n ) O(n) O ( n )

9. 桶排序(博采众长)

桶排序算法的核心思想分三步:

将待排序数组中的元素使用映射函数 分配到若干个「桶 」中。

对每个桶 中的元素进行排序 。

最后将这些排好序的桶进行合并 ,得到排序结果。

求模的方法不可行,我们需要用除法向下取整 的方式来将元素分配到桶 中。

对于桶合并可以有多种排序方法:使用插入排序的桶排序、使用递归的桶排序。

桶排序的稳定性主要取决于对每个桶的排序 算法。

空间复杂度是 O ( n + k ) O(n+k) O ( n + k ) O ( n + k ) O(n+k) O ( n + k ) O ( n 2 ) O(n^2) O ( n 2 )

10. 基数排序(Radix Sort)

基数排序是 计数排序 算法的扩展,它的主要思路是对待排序元素的每一位依次进行计数排序。由于计数排序是稳定的,所以对每一位完成计数排序后,所有元素就完成了排序。

基数排序的原理很简单,比方说输入的数组都是三位数 nums = [329, 457, 839, 439, 720, 355, 350],我们先按照个位 数排序,然后按照十位 数排序,然后按照百位 数排序,最终就完成了整个数组的排序。这里面的关键在于,对每一位的排序都必须是稳定排序,否则最终结果就不对了。

使用什么稳定排序比较好?计数排序,复杂度O ( n + 10 ) O(n+10) O ( n + 10 )

位数不同怎么办?前缀补 0

有负数?正数分数分开排序

采用 LSD 算法(Least Significant Digit first,最低位优先)。对应的是 MSD(Most Significant Digit first,最高位优先)

对于 LSD 基数排序,由于对每一位的排序都是稳定的,所以最终的排序结果也是稳定 的。

假设待排序数组长度为 n,最大元素的位数为 m,LSD 计数排序本质上就是执行了 m 次计数排序。前文分析过,计数排序的时空复杂度都是 O ( n + m a x − m i n ) O(n+max−min) O ( n + ma x − min ) m a x − m i n max−min ma x − min 10,可以忽略,所以每次计数排序的时空复杂度都是 O ( n ) O(n) O ( n ) O ( m n ) O(mn) O ( mn ) O ( n ) O(n) O ( n )

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 void radixSortLSD (std::vector<int >& nums) int min = INT_MAX; for (int num : nums) { min = std::min (min, num); } int offset = -min; for (int i = 0 ; i < nums.size (); i++) { nums[i] += offset; } int max = INT_MIN; for (int num : nums) { max = std::max (max, num); } int maxLen = 0 ; while (max > 0 ) { max /= 10 ; maxLen++; } for (int k = 0 ; k < maxLen; k++) { countSort (nums, k); } for (int i = 0 ; i < nums.size (); i++) { nums[i] -= offset; } } void countSort (std::vector<int >& nums, int k) std::vector<int > count (10 , 0 ) ; for (int num : nums) { int digit = (num / static_cast <int >(std::pow (10 , k))) % 10 ; count[digit]++; } for (int i = 1 ; i < count.size (); i++) { count[i] += count[i - 1 ]; } std::vector<int > sorted (nums.size()) ; for (int i = nums.size () - 1 ; i >= 0 ; i--) { int digit = (nums[i] / static_cast <int >(std::pow (10 , k))) % 10 ; sorted[count[digit] - 1 ] = nums[i]; count[digit]--; } for (int i = 0 ; i < nums.size (); i++) { nums[i] = sorted[i]; } }

第零章、核心刷题框架汇总

(零) 万剑归宗

几句话总结一切数据结构和算法:

种种数据结构,皆为数组 (顺序存储)和链表 (链式存储)的变换。

数据结构的关键点在于遍历和访问 ,即增删查改等基本操作。

种种算法,皆为穷举 。

穷举的关键点在于无遗漏和无冗余 。熟练掌握算法框架,可以做到无遗漏;充分利用信息,可以做到无冗余。

鞭辟入里:原文链接

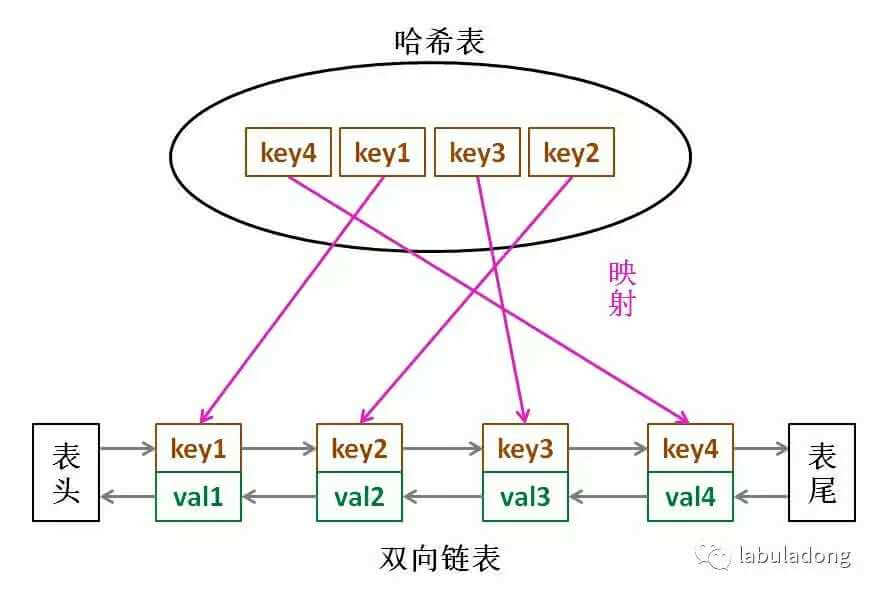

1. 数据结构的存储

队列、栈 这两种数据结构既可以使用链表也可以使用数组实现。用数组实现,就要处理扩容缩容的问题;用链表实现,没有这个问题,但需要更多的内存空间存储节点指针。图结构 的两种存储方式,邻接表就是链表,邻接矩阵就是二维数组。邻接矩阵判断连通性迅速,并可以进行矩阵运算解决一些问题,但是如果图比较稀疏的话很耗费空间。邻接表比较节省空间,但是很多操作的效率上肯定比不过邻接矩阵。哈希表 就是通过散列函数把键映射到一个大数组里。而且对于解决散列冲突的方法,拉链法 需要链表特性,操作简单,但需要额外的空间存储指针;线性探查法 需要数组特性,以便连续寻址,不需要指针的存储空间,但操作稍微复杂些。树结构 ,用数组实现就是「堆」,因为「堆」是一个完全二叉树,用数组存储不需要节点指针,操作也比较简单,经典应用有 二叉堆;用链表实现就是很常见的那种「树」,因为不一定是完全二叉树,所以不适合用数组存储。为此,在这种链表「树」结构之上,又衍生出各种巧妙的设计,比如 二叉搜索树、AVL 树、红黑树、区间树、B 树等等,以应对不同的问题。

综上,数据结构种类很多,甚至你也可以发明自己的数据结构,但是底层存储无非数组或者链表,二者的优缺点如下:

数组 由于是紧凑连续存储,可以随机访问,通过索引快速找到对应元素,而且相对节约存储空间。但正因为连续存储,内存空间必须一次性分配够,所以说数组如果要扩容,需要重新分配一块更大的空间,再把数据全部复制过去,时间复杂度 O(N);而且你如果想在数组中间进行插入和删除,每次必须搬移后面的所有数据以保持连续,时间复杂度 O ( N ) O(N) O ( N )

链表 因为元素不连续,而是靠指针指向下一个元素的位置,所以不存在数组的扩容问题;如果知道某一元素的前驱和后驱,操作指针即可删除该元素或者插入新元素,时间复杂度 O ( 1 ) O(1) O ( 1 )

2. 数据结构的操作

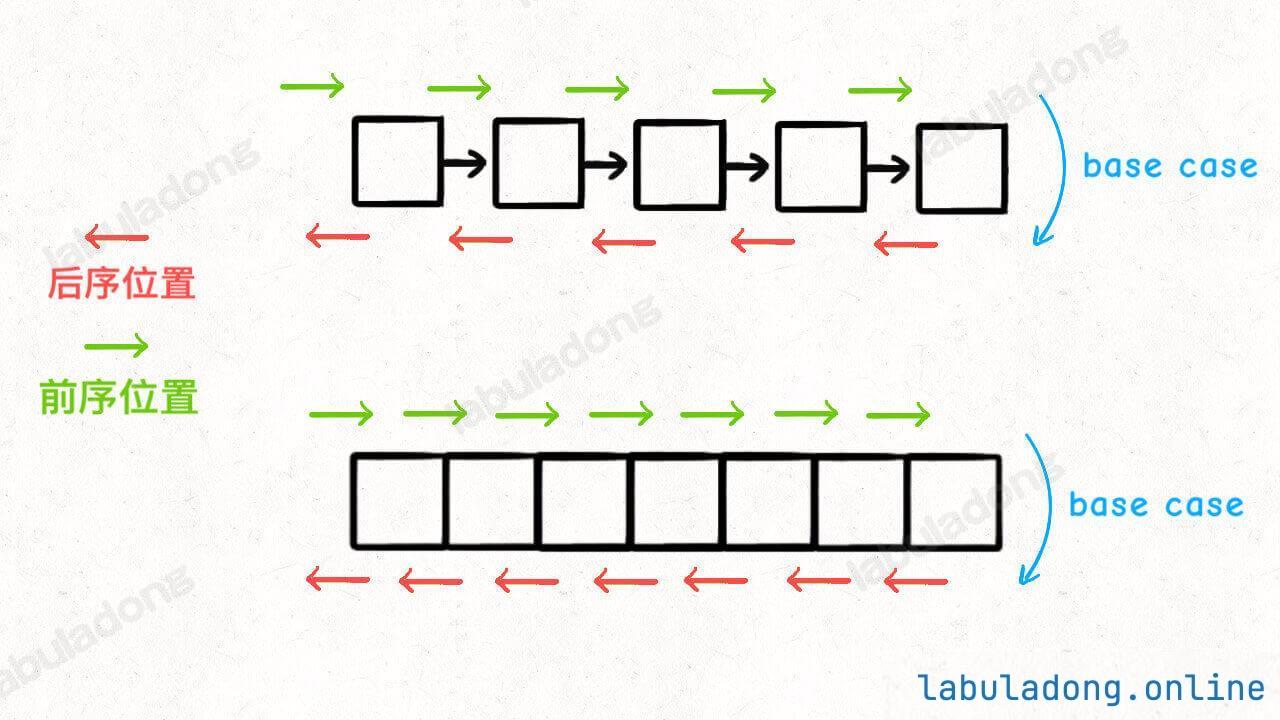

线性 就是 for/while 迭代为代表,非线性 就是递归为代表。

数组 遍历框架,典型的线性迭代结构:

1 2 3 4 5 void traverse (vector<int >& arr) for (int i = 0 ; i < arr.size (); i++) { } }

链表 遍历框架,兼具迭代和递归结构:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 class ListNode { public : int val; ListNode* next; }; void traverse (ListNode* head) for (ListNode* p = head; p != nullptr ; p = p->next) { } } void traverse (ListNode* head) traverse (head->next); }

二叉树 遍历框架,典型的非线性递归遍历结构:

1 2 3 4 5 6 7 8 9 10 11 struct TreeNode { int val; TreeNode* left; TreeNode* right; }; void traverse (TreeNode* root) traverse (root->left); traverse (root->right); }

二叉树框架可以扩展为 N 叉树的遍历框架:

1 2 3 4 5 6 7 8 9 10 11 class TreeNode {public : int val; vector<TreeNode*> children; }; void traverse (TreeNode* root) for (TreeNode* child : root->children) traverse (child); }

图 :N 叉树的遍历又可以扩展为图的遍历,因为图就是好几 N 叉棵树的结合体 。visited 做标记就行了。

3. 算法的本质

4. 穷举的难点

穷举有两个关键难点:无遗漏 、无冗余 。

当你看到一道算法题,可以从这两个维度去思考:

如何穷举?即无遗漏地穷举所有可能解。

如何聪明地穷举?即避免所有冗余的计算,消耗尽可能少的资源求出答案。

后续会有的系列:

数组/单链表系列算法:单指针、双指针、二分搜索、滑动窗口、前缀和、差分数组。

二叉树系列算法:动态规划、回溯(DFS)、层序(BFS)、分治。附加技巧剪枝、备忘录。

图系列算法:二叉树算法的延续。

(一) 双指针(链表)

技巧目录:

1、合并两个有序链表

链接:合并两个有序链表

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 class Solution {public : ListNode* mergeTwoLists (ListNode* l1, ListNode* l2) { ListNode dummy (-1 ) , *p = &dummy; ListNode *p1 = l1, *p2 = l2; while (p1 != nullptr && p2 != nullptr ) { if (p1->val > p2->val) { p->next = p2; p2 = p2->next; } else { p->next = p1; p1 = p1->next; } p = p->next; } if (p1 != nullptr ) p->next = p1; if (p2 != nullptr ) p->next = p2; return dummy.next; } };

什么时候需要用虚拟头结点?当你需要创造一条新链表 的时候,可以使用虚拟头结点 简化边界情况的处理。

2、单链表的分解

链接:分割链表

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 class Solution {public : ListNode* partition (ListNode* head, int x) { ListNode* dummy1 = new ListNode (-1 ); ListNode* dummy2 = new ListNode (-1 ); ListNode* p1 = dummy1, *p2 = dummy2; ListNode* p = head; while (p != nullptr ) { if (p->val >= x) { p2->next = p; p2 = p2->next; } else { p1->next = p; p1 = p1->next; } ListNode* temp = p->next; p->next = nullptr ; p = temp; } p1->next = dummy2->next; return dummy1->next; } };

3、合并 k 个有序链表

链接:合并k个有序链表

合并 k 个有序链表的逻辑类似合并两个有序链表,难点在于,如何快速得到 k 个节点中的最小节点,接到结果链表上?优先级队列 这种数据结构,把链表节点放入一个最小堆 ,就可以每次获得 k 个节点中的最小节点 。

优先队列 pq 中的元素个数最多是 k,所以一次 push 或者 pop 方法的时间复杂度是 O ( log k ) O(\log k) O ( log k ) O ( N log k ) 其中 k 是链表的条数, N 是这些链表的节点总数 O(N\log k)其中 k 是链表的条数,N 是这些链表的节点总数 O ( N log k ) 其中 k 是链表的条数, N 是这些链表的节点总数

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 class Solution {public : ListNode* mergeKLists (vector<ListNode*>& lists) { if (lists.empty ()) return NULL ; ListNode* dumy = new ListNode (); ListNode* p = dumy; auto cmp = [](ListNode* a, ListNode* b){ return a->val > b->val; }; priority_queue<ListNode*, vector<ListNode*>, decltype (cmp)> heap; for (ListNode* t: lists) if (t != NULL ) heap.push (t); while (!heap.empty ()){ ListNode* minp = heap.top (); heap.pop (); p->next = minp; p = p->next; if (minp->next != NULL ) heap.push (minp->next); } p->next = NULL ; return dumy->next; } };

4、单链表的倒数第 k 个节点

那你可能说,假设链表有 n 个节点,倒数第 k 个节点就是正数第 n - k + 1 个节点,不也是一个 for 循环的事儿吗?

这个解法需要遍历两次链表才能得到出倒数第 k 个节点。

能不能只遍历一次 链表,就算出倒数第 k 个节点?

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 class Solution {public : ListNode* findFromEnd (ListNode* head, int k) { ListNode* p1 = head; for (int i=0 ; i<k; i++) p1 = p1->next; ListNode* p2 = head; while (p1 != NULL ){ p1 = p1->next; p2 = p2->next; } return p2; } ListNode* removeNthFromEnd (ListNode* head, int n) { ListNode* dummy = new ListNode (); dummy->next = head; ListNode* p = findFromEnd (dummy, n+1 ); p->next = p->next->next; return dummy->next; } };

无论遍历一次链表和遍历两次链表的时间复杂度都是 O ( N ) O(N) O ( N ) 技巧性 。

我们又使用了虚拟头结点的技巧,也是为了防止出现空指针的情况,比如说链表总共有 5 个节点,题目就让你删除倒数第 5 个节点,也就是第一个节点,那按照算法逻辑,应该首先找到倒数第 6 个节点。但第一个节点前面已经没有节点了,这就会出错。

5、单链表的中点

参考:中点

我们让两个指针 slow 和 fast 分别指向链表头结点 head。每当慢指针 slow 前进一步,快指针 fast 就前进两步,这样,当 fast 走到链表末尾时,slow 就指向了链表中点。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 class Solution {public : ListNode* middleNode (ListNode* head) { ListNode* slow = head; ListNode* fast = head; while (fast != nullptr && fast->next != nullptr ) { slow = slow->next; fast = fast->next->next; } return slow; } };

6、判断链表是否包含环

参考:判断环

判断链表是否包含环属于经典问题了,解决方案也是用快慢指针:slow 前进一步,快指针 fast 就前进两步。

如果 fast 最终能正常走到链表末尾,说明链表中没有环;

如果 fast 走着走着竟然和 slow 相遇了,那肯定是 fast 在链表中转圈了,说明链表中含有环。

如果链表中含有环,如何计算这个环的起点?

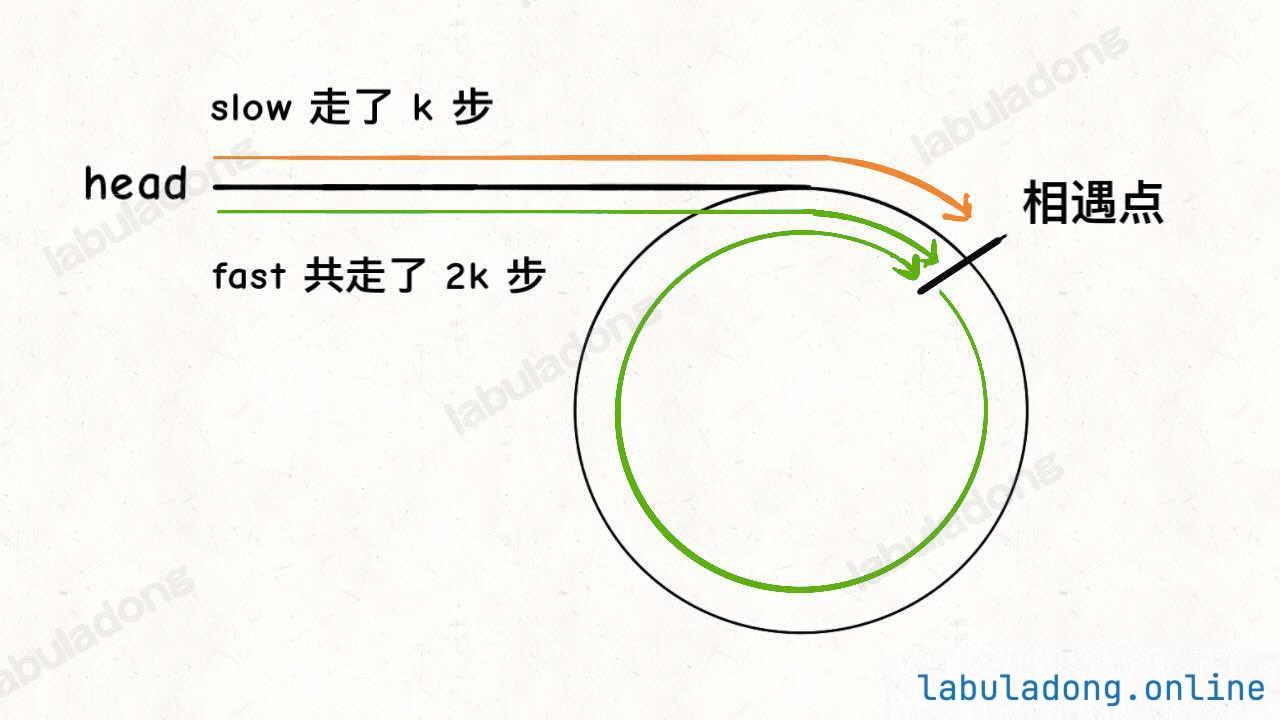

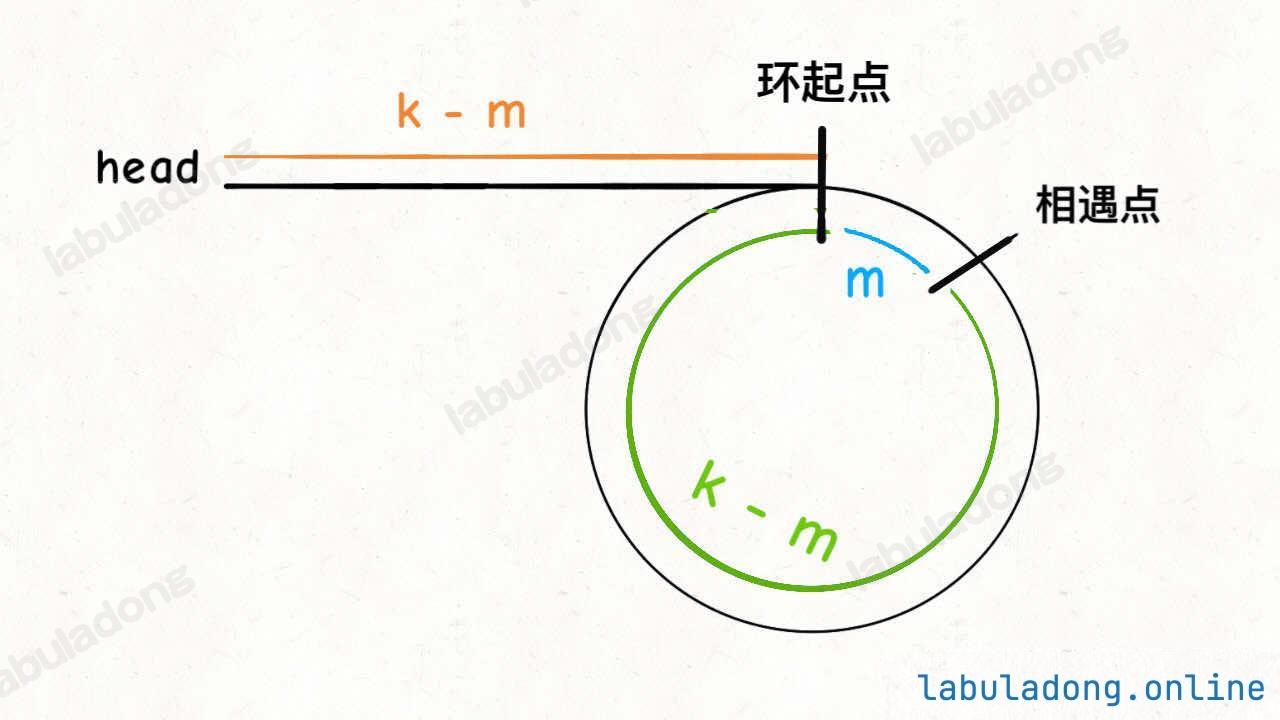

fast 一定比 slow 多走了 k 步,这多走的 k 步其实就是 fast 指针在环里转圈圈,所以 k 的值就是环长度 的「整数倍」。假设相遇点距环的起点的距离为 m,那么结合上图的 slow 指针,环的起点距头结点 head 的距离为 k - m,也就是说如果从 head 前进 k - m 步就能到达环起点。

巧的是,如果从相遇点继续前进 k - m 步,也恰好到达环起点。因为结合上图的 fast 指针,从相遇点开始走 k 步可以转回到相遇点,那走 k - m 步肯定就走到环起点了

所以,只要我们把快慢指针中的任一个重新指向 head,然后两个指针同速前进,k - m 步后一定会相遇,相遇之处就是环的起点了。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 class Solution {public : ListNode *detectCycle (ListNode *head) { ListNode* slow = head; ListNode* fast = head; while (fast != NULL && fast->next != NULL ){ slow = slow->next; fast = fast->next->next; if (slow == fast) break ; } if (fast == NULL || fast->next == NULL ) return NULL ; slow = head; while (slow != fast){ slow = slow->next; fast = fast->next; } return slow; } };

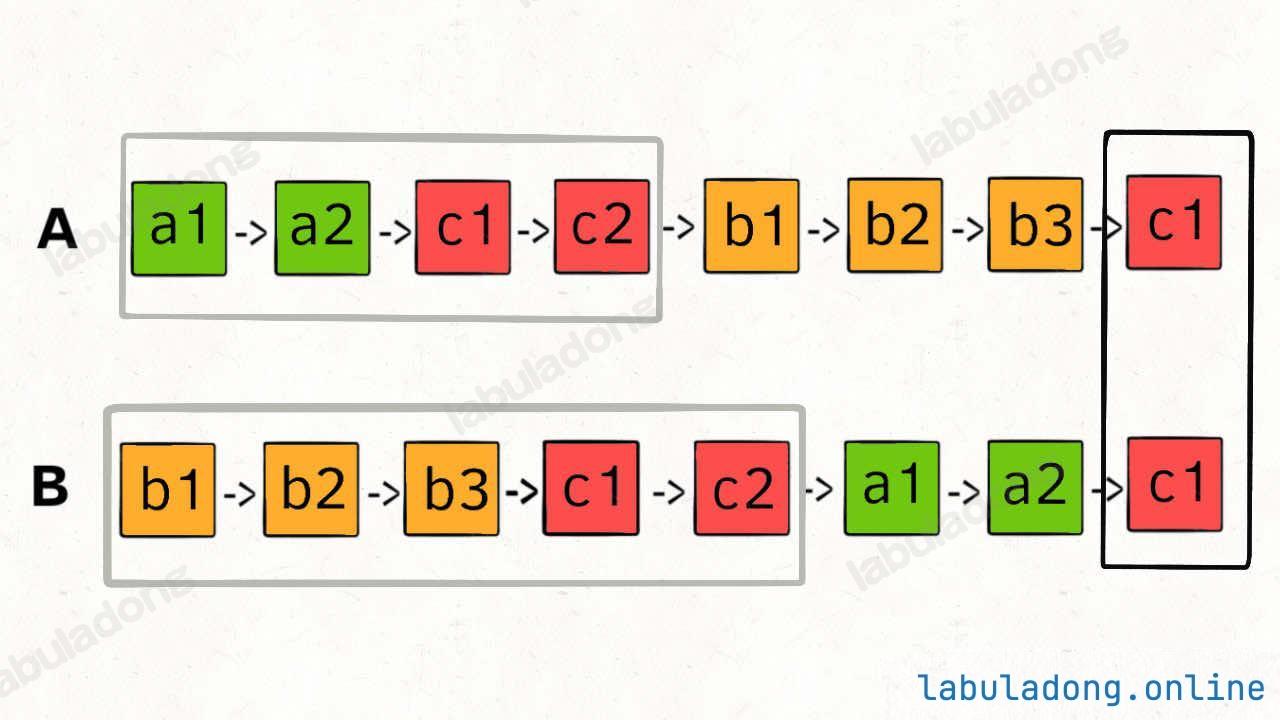

7、两个链表是否相交

参考:相交

这个题直接的想法可能是用 HashSet 记录一个链表的所有节点 ,然后和另一条链表对比 ,但这就需要额外的空间。

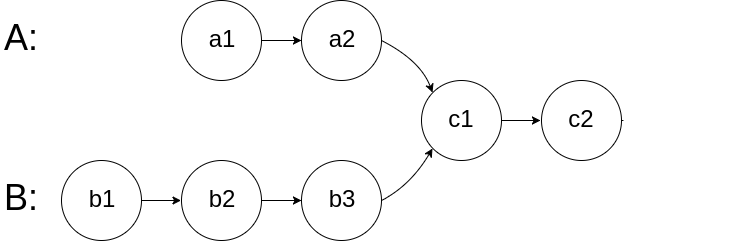

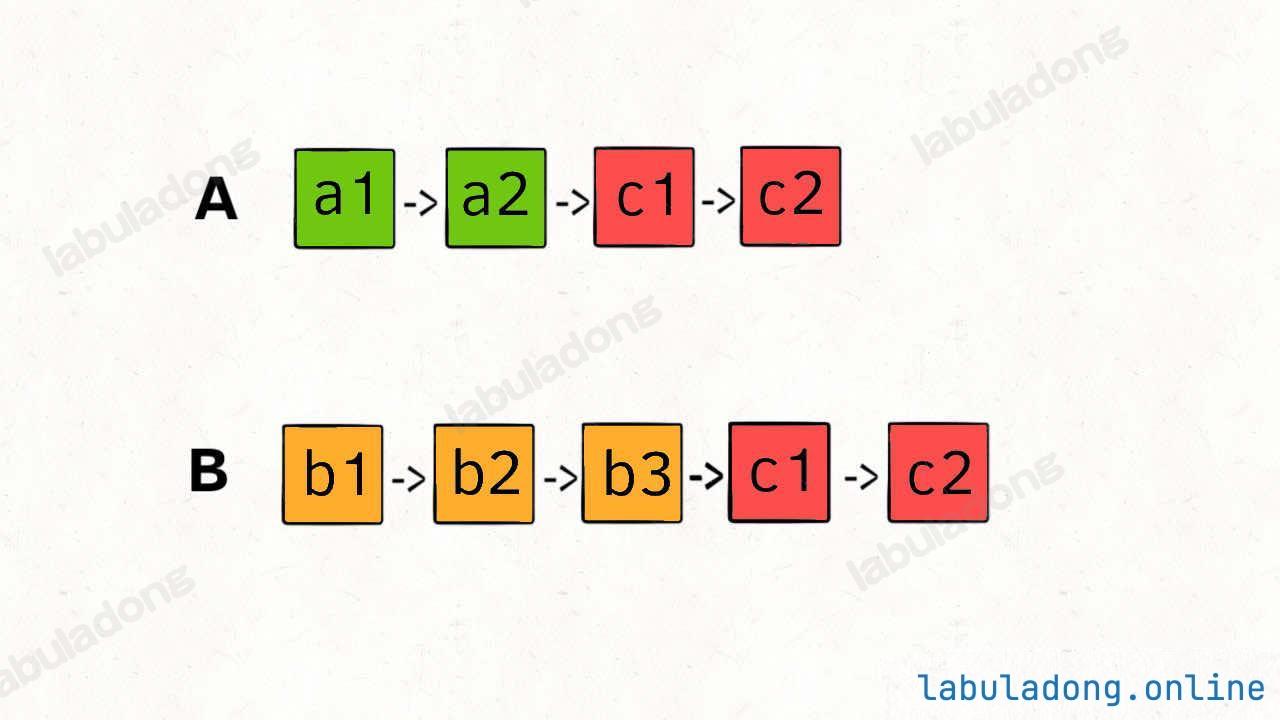

如果不用额外的空间,只使用两个指针,你如何做呢?难点在于,由于两条链表的长度可能不同,两条链表之间的节点无法对应。

如果用两个指针 p1 和 p2 分别在两条链表上前进,并不能同时走到公共节点,也就无法得到相交节点 c1。解决这个问题的关键是,通过某些方式,让 p1 和 p2 能够同时到达相交节点 c1 。所以,我们可以让 p1 遍历完链表 A 之后开始遍历链表 B,让 p2 遍历完链表 B 之后开始遍历链表 A,这样相当于「逻辑上」两条链表接在了一起。如果这样进行拼接,就可以让 p1 和 p2 同时进入公共部分,也就是同时到达相交节点 c1:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 class Solution {public : ListNode *getIntersectionNode (ListNode *headA, ListNode *headB) { ListNode *p1 = headA, *p2 = headB; while (p1 != p2){ if (p1 != NULL ) p1 = p1->next; else p1 = headB; if (p2 != NULL ) p2 = p2->next; else p2 = headA; } return p1; } };

(二) 双指针(数组)

一、快慢指针技巧

原地修改

滑动窗口

二、左右指针的常用算法

1、原地修改

参考:删除有序数组中的重复项

数组问题中比较常见的快慢指针技巧,是让你原地修改数组。

由于数组已经排序,所以重复的元素一定连在一起,找出它们并不难。但如果毎找到一个重复元素就立即原地删除它,由于数组中删除元素涉及数据搬移 ,整个时间复杂度是会达到 O ( N 2 ) O(N^2) O ( N 2 )

们让慢指针 slow 走在后面,快指针 fast 走在前面探路,找到一个不重复的元素就赋值给 slow 并让 slow 前进一步。这样,就保证了 nums[0..slow] 都是无重复的元素,当 fast 指针遍历完整个数组 nums 后,nums[0..slow] 就是整个数组去重之后的结果。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 class Solution {public : int removeDuplicates (vector<int >& nums) int n = nums.size (); if (n == 0 ) return 0 ; int slow = 0 , fast = 0 ; while (fast < n){ if (nums[fast] != nums[slow]) nums[++slow] = nums[fast]; fast++; } return slow + 1 ; } };

再简单扩展一下,看看力扣第 83 题「删除排序链表中的重复元素」,如果给你一个有序的单链表,如何去重呢?其实和数组去重是一模一样的,唯一的区别是把数组赋值操作变成操作指针而已。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 class Solution {public : ListNode* deleteDuplicates (ListNode* head) { if (head == NULL ) return NULL ; ListNode *slow = head, *fast = head; while (fast != NULL ){ if (fast->val != slow->val){ slow->next = fast; slow = slow->next; } fast = fast->next; } slow->next = NULL ; return head; } };

除了让你在有序数组/链表中去重,题目还可能让你对数组中的某些元素进行「原地删除 」。

参考:移除元素

题目要求我们把 nums 中所有值为 val 的元素原地删除,依然需要使用快慢指针技巧:fast 遇到值为 val 的元素,则直接跳过,否则就赋值给 slow 指针,并让 slow 前进一步。

1 2 3 4 5 6 7 8 9 10 11 12 13 class Solution {public : int removeElement (vector<int >& nums, int val) int fast = 0 , slow = 0 ; while (fast < nums.size ()){ if (nums[fast] != val) nums[slow++] = nums[fast]; fast++; } return slow; } };

给你输入一个数组 nums,请你原地修改,将数组中的所有值为 0 的元素移到数组末尾。

参考:移动零

1 2 3 4 5 6 7 8 9 10 11 12 13 14 class Solution {public : void moveZeroes (vector<int >& nums) int fast = 0 , slow = 0 ; while (fast < nums.size ()){ if (nums[fast] != 0 ) nums[slow++] = nums[fast]; fast++; } while (slow < nums.size ()) nums[slow++] = 0 ; } };

到这里,原地修改数组的这些题目就已经差不多了。

2、滑动窗口

数组中另一大类快慢指针的题目就是「滑动窗口算法」。在下文 【(三)滑动窗口】给出了滑动窗口的代码框架:

1 2 3 4 5 6 7 8 9 10 11 12 13 int left = 0 , right = 0 ;while (right < nums.size ()){ window.push_back (nums[right]); right++; while (window needs shrink){ window.pop_front (); left++; } }

具体的题目本文就不重复了,这里只强调滑动窗口算法的快慢指针特性:left 指针在后,right 指针在前,两个指针中间的部分就是「窗口 」,算法通过扩大和缩小「窗口 」来解决某些问题。

3、二分查找

在另一篇文章 【二分查找框架详解】 中有详细探讨二分搜索代码的细节问题,这里只写最简单的二分算法,旨在突出它的双指针特性:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 #include <vector> using namespace std;int binarySearch (vector<int >& nums, int target) int left = 0 , right = nums.size () - 1 ; while (left <= right) { int mid = (right + left) / 2 ; if (nums[mid] == target) return mid; else if (nums[mid] < target) left = mid + 1 ; else if (nums[mid] > target) right = mid - 1 ; } return -1 ; }

4、n 数之和

参考:两数之和 II

给你一个下标从 1 开始的整数数组 numbers ,该数组已按 非递减顺序排列 ,请你从数组中找出满足相加之和等于目标数 target 的两个数。如果设这两个数分别是 numbers[index1] 和 numbers[index2] ,则 1 <= index1 < index2 <= numbers.length 。

只要数组有序,就应该想到双指针技巧。这道题的解法有点类似二分查找,通过调节 left 和 right 就可以调整 sum 的大小:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 class Solution {public : vector<int > twoSum (vector<int >& numbers, int target) { int left = 0 , right = numbers.size ()-1 ; while (left < right){ int sum = numbers[left] + numbers[right]; if (sum == target) return vector<int >{left+1 , right+1 }; else if (sum > target) right--; else left++; } return vector<int >{-1 , -1 }; } };

在另一篇文章 【一个函数秒杀所有nSum问题】 中也运用类似的左右指针技巧给出了 nSum 问题的一种通用思路,本质上利用的也是双指针技巧。

5、反转数组

一般编程语言都会提供 reverse 函数,其实这个函数的原理非常简单,力扣第 344 题「反转字符串」就是类似的需求,让你反转一个 char[] 类型的字符数组,我们直接看代码吧:

参考:反转字符串

1 2 3 4 5 6 7 8 9 10 11 12 13 class Solution {public : void reverseString (vector<char >& s) int left = 0 , right = s.size ()-1 ; while (left < right){ char t = s[left]; s[left] = s[right]; s[right] = t; left++, right--; } } };

关于数组翻转的更多进阶问题,可以参见 【二维数组的花式遍历】。

6、回文串判断

1 2 3 4 5 6 7 8 bool isPalindrome (string s) int left = 0 , right = s.size ()-1 ; while (left < right){ if (s[left] != s[right]) return false ; left++, right--; } return true ; }

提升一点难度,给你一个字符串,让你用双指针技巧从中找出最长的回文串 ?

参考:最长回文子串

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 class Solution {public : string palindrome (string& s, int l, int r) { while (l>=0 && r<s.size () && s[l]==s[r]) l--, r++; return s.substr (l+1 , r-l-1 ); } string longestPalindrome (string s) { string ans = "" ; for (int i=0 ; i<s.size (); i++){ string s1 = palindrome (s, i, i); string s2 = palindrome (s, i, i+1 ); ans = s1.size () > ans.size () ? s1 : ans; ans = s2.size () > ans.size () ? s2 : ans; } return ans; } };

你应该能发现最长回文子串使用的左右指针和之前题目的左右指针有一些不同:之前的左右指针都是从两端向中间相向而行,而回文子串问题则是让左右指针从中心向两端扩展。不过这种情况也就回文串这类问题会遇到,所以我也把它归为左右指针了。

(三) 滑动窗口

滑动窗口可以归为快慢双指针,一快一慢两个指针前后相随,中间的部分就是窗口。

滑动窗口算法技巧主要用来解决子数组问题,比如让你寻找符合某个条件的最长/最短子数组 。

1、框架概述

如果用暴力解的话,你需要嵌套 for 循环这样穷举所有子数组,时间复杂度是 O ( N 2 ) O(N^2) O ( N 2 )

1 2 3 4 5 for (int i = 0 ; i < nums.size (); i++) { for (int j = i; j < nums.size (); j++) { } }

滑动窗口算法技巧的思路也不难,就是维护一个窗口,不断滑动,然后更新答案,该算法的大致逻辑如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 int left = 0 , right = 0 ;while (right < nums.size ()){ window.push_back (nums[right]); right++; while (window needs shrink){ window.pop_front (); left++; } }

基于滑动窗口算法框架写出的代码,时间复杂度是 O ( N ) O(N) O ( N ) for 循环的暴力解法效率高。

为啥是 O ( N ) O(N) O ( N )

简单说,指针 left, right 不会回退(它们的值只增不减),所以字符串/数组中的每个元素都只会进入窗口一次,然后被移出窗口一次。

反观嵌套 for 循环的暴力解法,那个 j 会回退,所以某些元素会进入和离开窗口多次,所以时间复杂度就是 O ( N 2 ) O(N^2) O ( N 2 )

为啥滑动窗口能在 O ( N ) O(N) O ( N )

这个问题本身就是错误的,滑动窗口并不能穷举出所有子串 。要想穷举出所有子串,必须用那个嵌套 for 循环。

然而对于某些题目,并不需要穷举所有子串 ,就能找到题目想要的答案。滑动窗口就是这种场景下的一套算法模板,帮你对穷举过程进行剪枝优化,避免冗余计算。

因为本文的例题大多是子串相关的题目,字符串实际上就是数组,所以我就把输入设置成字符串了。你做题的时候根据具体题目自行变通即可:

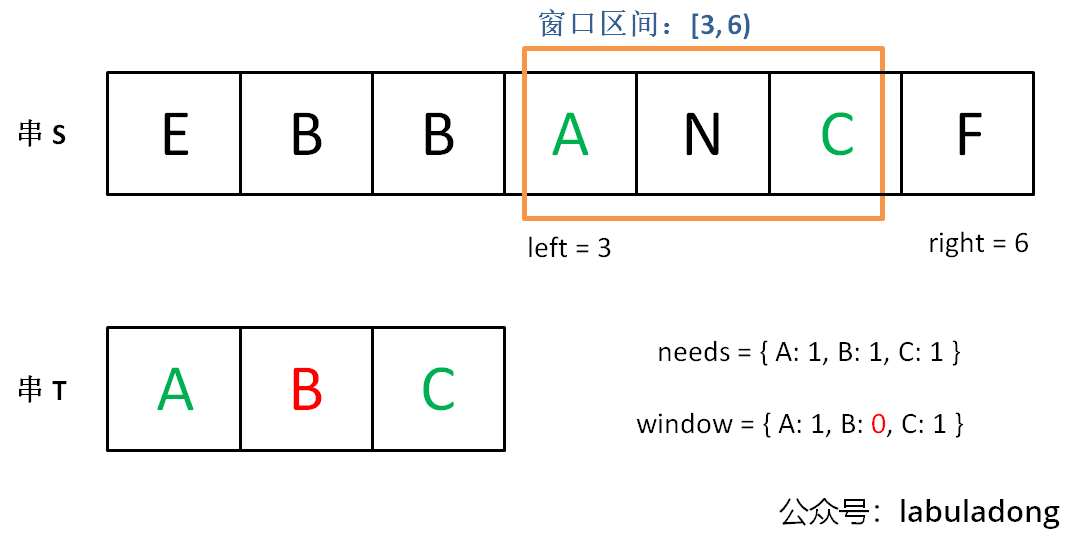

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 void slidingWindow (string s) auto window = ... int left = 0 , right = 0 ; while (right < s.size ()) { char c = s[right]; window.add (c); right++; ... printf ("window: [%d, %d)\n" , left, right); while (window needs shrink) { char d = s[left]; window.remove (d); left++; ... } } }

框架中两处 ... 表示的更新窗口数据的地方,在具体的题目中,你需要做的就是往这里面填代码逻辑。

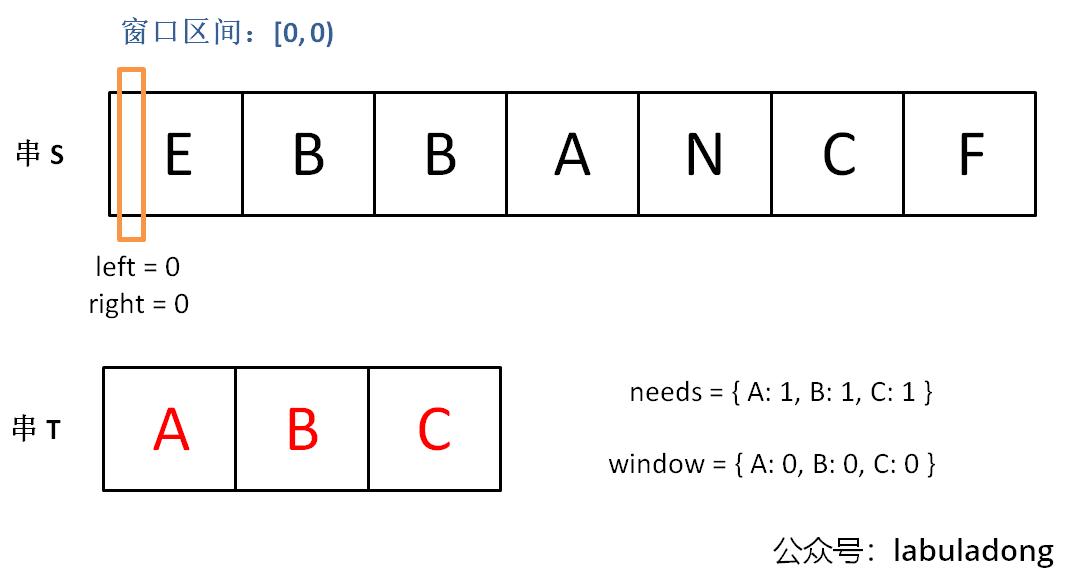

2、最小覆盖子串

参考:最小覆盖子串

给你一个字符串 s 、一个字符串 t 。返回 s 中涵盖 t 所有字符的最小子串。如果 s 中不存在涵盖 t 所有字符的子串,则返回空字符串 "" 。

注:对于 t 中重复字符,我们寻找的子字符串中该字符数量必须不少于 t 中该字符数量。如果 s 中存在这样的子串,我们保证它是唯一的答案。

示例:s = "ADOBECODEBANC", t = "ABC""BANC"

滑动窗口算法的思路是这样:

我们在字符串 S 中使用双指针中的左右指针技巧,初始化 left = right = 0,把索引左闭右开区间 [left, right) 称为一个「窗口」。

为什么要「左闭右开 」区间?

理论上你可以设计两端都开或者两端都闭的区间,但设计为左闭右开区间是最方便处理的。

因为这样初始化 left = right = 0 时区间 [0, 0) 中没有元素,但只要让 right 向右移动(扩大)一位,区间 [0, 1) 就包含一个元素 0 了。

另外,注意:当前窗口长度,就是 right-left,不需要right-left+1的 。

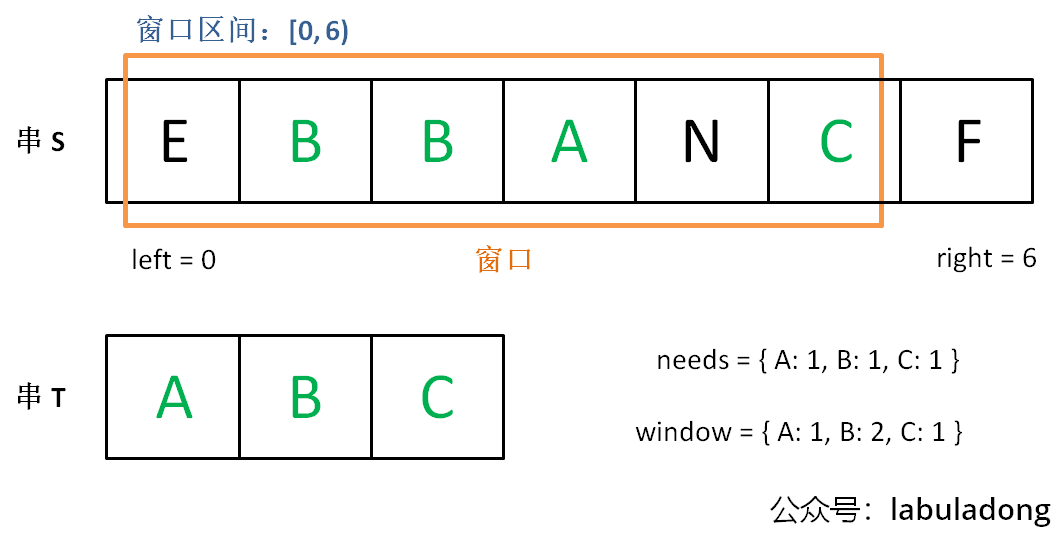

我们先不断地增加 right 指针扩大窗口 [left, right),直到窗口中的字符串符合要求(包含了 T 中的所有字符)。

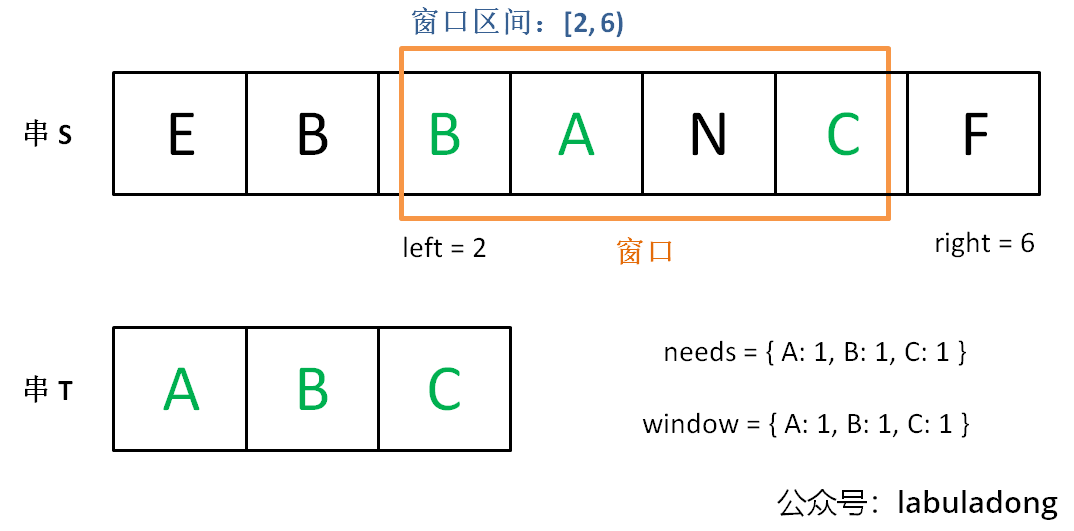

此时,我们停止增加 right,转而不断增加 left 指针缩小窗口 [left, right),直到窗口中的字符串不再符合要求(不包含 T 中的所有字符了)。同时,每次增加 left,我们都要更新一轮结果。

重复第 2 和第 3 步,直到 right 到达字符串 S 的尽头。

这个思路其实也不难,第 2 步相当于在寻找一个「可行解」,然后第 3 步在优化这个「可行解」,最终找到最优解 ,也就是最短的覆盖子串。左右指针轮流前进,窗口大小增增减减,就好像一条毛毛虫,一伸一缩,不断向右滑动,这就是「滑动窗口」这个名字的来历。

现在开始套模板,只需要思考以下几个问题:

什么时候应该移动 right 扩大窗口?窗口加入字符时,应该更新哪些数据?

什么时候窗口应该暂停扩大,开始移动 left 缩小窗口?从窗口移出字符时,应该更新哪些数据?

我们要的结果应该在扩大窗口时还是缩小窗口时进行更新?

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 class Solution {public : string minWindow (string s, string t) { int n = s.size (); unordered_map<char , int > need, window; for (char & c: t) need[c]++; int left = 0 , right = 0 ; int valid = 0 ; int start = 0 , len = n+1 ; while (right < n){ char c = s[right]; right++; if (need.count (c)){ window[c]++; if (window[c] == need[c]) valid++; } while (valid == need.size ()){ if (right-left < len){ start = left; len = right-left; } char d = s[left]; left++; if (need.count (d)){ if (window[d] == need[d]) valid--; window[d]--; } } } return len>n ? "" : s.substr (start, len); } };

这里再强调一下,里面的if(window[d] == need[d])用的很妙的,保证了不会多加少加、多减少减。

3、字符串排列

参考:字符串的排列

给你两个字符串 s1 和 s2 ,写一个函数来判断 s2 是否包含 s1 的 排列 (排列是字符串中所有字符的重新排序。)。如果是,返回 true ;否则,返回 false 。换句话说,s1 的排列之一是 s2 的 子串 。

示例1:s1 = "ab" s2 = "eidbaooo"trues2 包含 s1 的排列之一 ("ba").

示例2:s1= "ab" s2 = "eidboaoo"false

相当给你一个 S 和一个 T,请问你 S 中是否存在一个子串,包含 T 中所有字符且不包含其他字符?

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 class Solution {public : bool checkInclusion (string s1, string s2) int n1 = s1.size (), n2 = s2.size (); unordered_map<char , int > need, window; for (char & c: s1) need[c]++; int valid = 0 ; int left = 0 , right = 0 ; while (right < n2){ char c = s2[right]; right++; if (need.count (c)){ window[c]++; if (window[c] == need[c]) valid++; } if (right-left == n1){ if (valid == need.size ()) return true ; char d = s2[left]; left++; if (need.count (d)){ if (window[d] == need[d]) valid--; window[d]--; } } } return false ; } };

其实,你会发现,若是匹配的小窗是固定长度的,那么里面收缩的条件就是 if 而不是 while,当然你使用 while (right - left >= t.size()) 也是能做的,只不过实际上就只执行一次。

4、找所有字母异位词

参考:找到字符串中所有字母异位词

给定两个字符串 s 和 p,找到 s 中所有 p 的 异位词 (字母异位词是通过重新排列不同单词或短语的字母而形成的单词或短语,并使用所有原字母一次) 的子串,返回这些子串的起始索引。不考虑答案输出的顺序。

示例:s = "cbaebabacd", p = "abc"[0,6]0 的子串是 "cba", 它是 "abc" 的异位词。起始索引等于 6 的子串是 "bac", 它是 "abc" 的异位词。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 class Solution {public : vector<int > findAnagrams (string s, string p) { int n = s.size (), m = p.size (); unordered_map<char , int > need, window; for (char &t: p) need[t]++; int valid = 0 ; vector<int > ans; int left = 0 , right = 0 ; while (right < n){ char c = s[right]; right++; if (need.count (c)){ window[c]++; if (window[c] == need[c]) valid++; } if (right-left == m){ if (valid == need.size ()) ans.push_back (left); char d = s[left]; left++; if (need.count (d)){ if (window[d] == need[d]) valid--; window[d]--; } } } return ans; } };

5、最长无重复子串

参考:无重复字符的最长子串

给定一个字符串 s ,请你找出其中不含有重复字符的 最长 子串(连续的非空字符序列) 的长度。

示例:s = "abcabcbb"3"abc",所以其长度为 3。

下面是我的解法:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 class Solution {public : int lengthOfLongestSubstring (string s) int n = s.size (); unordered_set<char > window; int ans = 0 ; int left = 0 , right = 0 ; while (right < n){ char c = s[right]; right++; while (window.find (c) != window.end ()){ char d = s[left]; left++; window.erase (d); } if (window.find (c) == window.end ()){ window.insert (c); ans = max (ans, right-left); } } return ans; } };

如若套用前面模版,也可以:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 class Solution {public : int lengthOfLongestSubstring (string s) int n = s.size (); unordered_map<char , int > window; int ans = 0 ; int left = 0 , right = 0 ; while (right < n){ char c = s[right]; right++; window[c]++; while (window[c] > 1 ){ char d = s[left]; left++; window[d]--; } ans = max (ans, right-left); } return ans; } };

你只要能回答出来以下几个问题,就能运用滑动窗口算法:

什么时候应该扩大窗口?

什么时候应该缩小窗口?

什么时候应该更新答案?

更多强化经典题:滑动窗口-强化

将 x 减到 0 的最小操作数 乘积小于 K 的子数组 最大连续1的个数 III 替换后的最长重复字符

建议在第二天来完成。

(四) 二分搜索

1、代码框架

1 2 3 4 5 6 7 8 9 10 11 12 13 14 int binarySearch (vector<int >& nums, int target) int left = 0 , right = nums.size () - 1 ; while (...) { int mid = left + (right - left) / 2 ; if (nums[mid] == target) { ... } else if (nums[mid] < target) { left = ... } else if (nums[mid] > target) { right = ... } } }

分析二分查找的一个技巧是:不要出现 else,而是把所有情况用 else if 写清楚,这样可以清楚地展现所有细节。

其中 ... 标记的部分,就是可能出现细节问题的地方,当你见到一个二分查找的代码时,首先注意这几个地方。

另外提前说明一下,计算 mid 时需要防止溢出,代码中 left + (right - left) / 2 就和 (left + right) / 2 的结果相同,但是有效防止了 left 和 right 太大,直接相加导致溢出的情况。

2、寻找一个数(基本)

参考:二分查找

即搜索一个数,如果存在,返回其索引,否则返回 -1。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 class Solution {public : int search (vector<int >& nums, int target) int left = 0 , right = nums.size ()-1 ; while (left <= right){ int mid = left + (right-left)/2 ; if (nums[mid] == target) return mid; else if (nums[mid] < target) left = mid+1 ; else if (nums[mid] > target) right = mid-1 ; } return -1 ; } };

分析:[left, right] 两端都闭的区间,这个区间其实就是每次进行搜索的区间 。那么:

while 循环的条件是 <= 而不是 <。因为 [4,4]是有元素的,而[5,4]才没有元素了,就停止。初始化 right 是 n-1,而不是 n。因为初始是 [0,n-1]才是可以搜索的空间,而[0,n]的最后n是不可搜索的。

若是采用 [left,right) 那么你可以分析得到循环结束,应该是 类似[4,4) 也就是 while 用 left < right就结束了。同时初始化应该是 [0,n) 刚好把所有元素包含且不含最后的n。

为什么是 left = mid + 1,right = mid - 1?

明确了「搜索区间 」这个概念,而且本算法的搜索区间是两端都闭的,即 [left, right]。那么当我们发现索引 mid 不是要找的 target 时,下一步应该去搜索哪里呢?当然是去搜索区间 [left, mid-1] 或者区间 [mid+1, right] 对不对?因为 mid 已经搜索过,应该从搜索区间中去除。

此算法有什么缺陷?

比如说给你有序数组 nums = [1,2,2,2,3],target 为 2,此算法返回的索引是 2,没错。但是如果我想得到 target 的左侧边界,即索引 1,或者我想得到 target 的右侧边界,即索引 3,这样的话此算法是无法处理的。

这样的需求很常见,你也许会说,找到一个 target,然后向左或向右线性搜索不行吗?可以,但是不好,因为这样难以保证二分查找对数级的复杂度了。

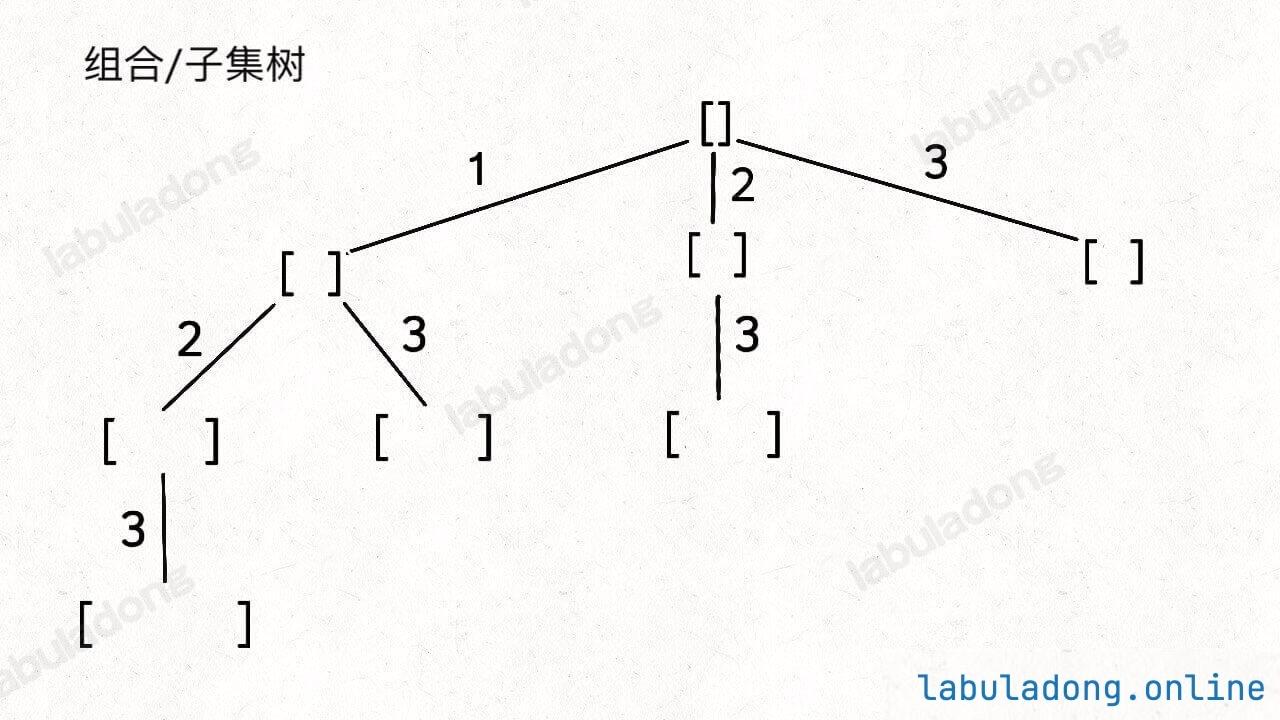

3、寻找左边界

1 2 3 4 5 6 7 8 9 10 11 12 13 int left_bound (vector<int > &nums, int target) int left = 0 , right = nums.size (); while (left < right){ int mid = left + (right-left)/2 ; if (nums[mid] == target) right = mid; else if (nums[mid] < target) left = mid+1 ; else if (nums[mid] > target) right = mid; } return left; }

如果 target 不存在,搜索左侧边界的二分搜索返回的索引是大于 target 的最小索引。

举个例子,nums = [2,3,5,7], target = 4,left_bound 函数返回值是 2,因为元素 5 是大于 4 的最小元素。

为什么是 left = mid + 1 和 right = mid?

「搜索区间 」是 [left, right) 左闭右开,所以当 nums[mid] 被检测之后,下一步应该去 mid 的左侧或者右侧区间搜索,即 [left, mid) 或 [mid + 1, right)。

为什么该算法能够搜索左侧边界?

关键在于对于 nums[mid] == target 这种情况的处理是 right = mid;可见,找到 target 时不要立即返回,而是缩小「搜索区间」的上界 right,在区间 [left, mid) 中继续搜索,即不断向左收缩,达到锁定左侧边界的目的。

为什么返回 left 而不是 right?

一样,都可以。终止条件是 left == right。

可以直接拿来写 floor 函数。

1 2 3 4 5 6 7 8 9 10 int floor (vector<int > &nums, int target) return left_bound (nums, target) - 1 ; }

但是,如果非必要,不要自己手写,尽可能用编程语言提供的标准库函数 ,可以节约时间,而且标准库函数的行为在文档里都有明确的说明,不容易出错。

如果想让 target 不存在时返回 -1 其实很简单,在返回的时候额外判断一下 nums[left] 是否等于 target 就行了,如果不等于,就说明 target 不存在。需要注意的是,访问数组索引之前要保证索引不越界

1 2 3 4 5 if (left < 0 || left >= nums.length) return -1 ; return nums[left] == target ? left : -1 ;

提示:其实上面的 if 中 left < 0 这个判断可以省略,因为对于这个算法,left 不可能小于 0,你看这个算法执行的逻辑,left 初始化就是 0,且只可能一直往右走,那么只可能在右侧越界。不过我这里就同时判断了,因为在访问数组索引之前保证索引在左右两端都不越界是一个好习惯,没有坏处。另一个好处是让二分的模板更统一,降低你的记忆成本,因为等会儿寻找右边界的时候也有类似的出界判断。

只要明白了搜索区间 的概念,实际上,可以统一一下,仍然使用左右都闭的。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 int left_bound (vector<int > &nums, int target) int left = 0 , right = nums.size ()-1 ; while (left <= right){ int mid = left + (right-left)/2 ; if (nums[mid] == target) right = mid-1 ; else if (nums[mid] < target) left = mid+1 ; else if (nums[mid] > target) right = mid-1 ; } if (left<0 || right>=nums.size ()) return -1 ; return nums[left] == target? left : -1 ; }

4、寻找右边界

先还是看左闭右开的代码:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 int right_bound (vector<int > &nums, int target) int left = 0 , right = nums.size (); while (left < right){ int mid = left + (right-left)/2 ; if (nums[mid] == target) left = mid+1 ; else (nums[mid] < target) left = mid+1 ; else (nums[mid] > target) right = mid; } return left-1 ; }

为什么返回 left - 1?为什么不是返回 right?

终止条件是 left == right,所以 left 和 right 是一样的,你非要体现右侧的特点,返回 right - 1 好了。

为什么要减一,这是搜索右侧边界的一个特殊点,关键在锁定右边界时的这个条件判断:left = mid + 1;。

因为我们对 left 的更新必须是 left = mid + 1,就是说 while 循环结束时,nums[left] 一定不等于 target 了,而 nums[left-1] 可能是 target。

至于为什么 left 的更新必须是 left = mid + 1,当然是为了把 nums[mid] 排除出搜索区间,这里就不再赘述。

如果 target 不存在,搜索右侧边界的二分搜索返回的索引是小于target 的最大索引。

比如 nums = [2,3,5,7], target = 4,right_bound 函数返回值是 1,因为元素 3 是小于 4 的最大元素。

统一一下,现在可以改成左右都闭的写法了:left+1 == right 了,那么刚好right = left-1,可以直接换成 right 返回。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 int right_bound (vector<int > &nums, int target) int left = 0 , right = nums.size ()-1 ; while (left <= right){ int mid = left + (right-left)/2 ; if (nums[mid] == target) left = mid+1 ; else if (nums[mid] < target) left = mid+1 ; else if (nums[mid] > target) right = mid-1 ; } if (right<0 || right>=nums.size ()) return -1 ; return nums[right]==target? right : -1 ; }

现在,你可以去做 在排序数组中查找元素的第一个和最后一个位置

在左右边界的代码中,所有的情况,都是需要变动 mid 的,如mid+1或mid-1,记住 !

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 class Solution {public : int left_bound (vector<int > &nums, int target) int left = 0 , right = nums.size ()-1 ; while (left <= right){ int mid = left + (right-left)/2 ; if (nums[mid] == target) right = mid-1 ; else if (nums[mid] < target) left = mid+1 ; else if (nums[mid] > target) right = mid-1 ; } if (left<0 || left>=nums.size ()) return -1 ; return nums[left]==target? left : -1 ; } int right_bound (vector<int > &nums, int target) int left = 0 , right = nums.size ()-1 ; while (left <= right){ int mid = left + (right-left)/2 ; if (nums[mid] == target) left = mid+1 ; else if (nums[mid] < target) left = mid+1 ; else if (nums[mid] > target) right = mid-1 ; } if (right<0 || right>=nums.size ()) return -1 ; return nums[right]==target? right : -1 ; } vector<int > searchRange (vector<int >& nums, int target) { int left = left_bound (nums, target); int right = right_bound (nums, target); return vector<int >{left, right}; } };

二分思维的精髓就是:通过已知信息尽可能多地收缩(折半)搜索空间 ,从而增加穷举效率,快速找到目标。

但实际题目中不会直接让你写二分代码,我会在 【二分查找的运用 】 和 【二分查找的更多习题 】 中进一步讲解如何把二分思维运用到更多算法题中

(五) 递归(一个视角+两种思维)

一个视角是指「树」的视角,两种思维模式是指「遍历」和「分解问题」两种思维模式 。

算法的本质是穷举,递归是一种重要的穷举手段,递归的正确理解方法是从「树 」的角度理解。

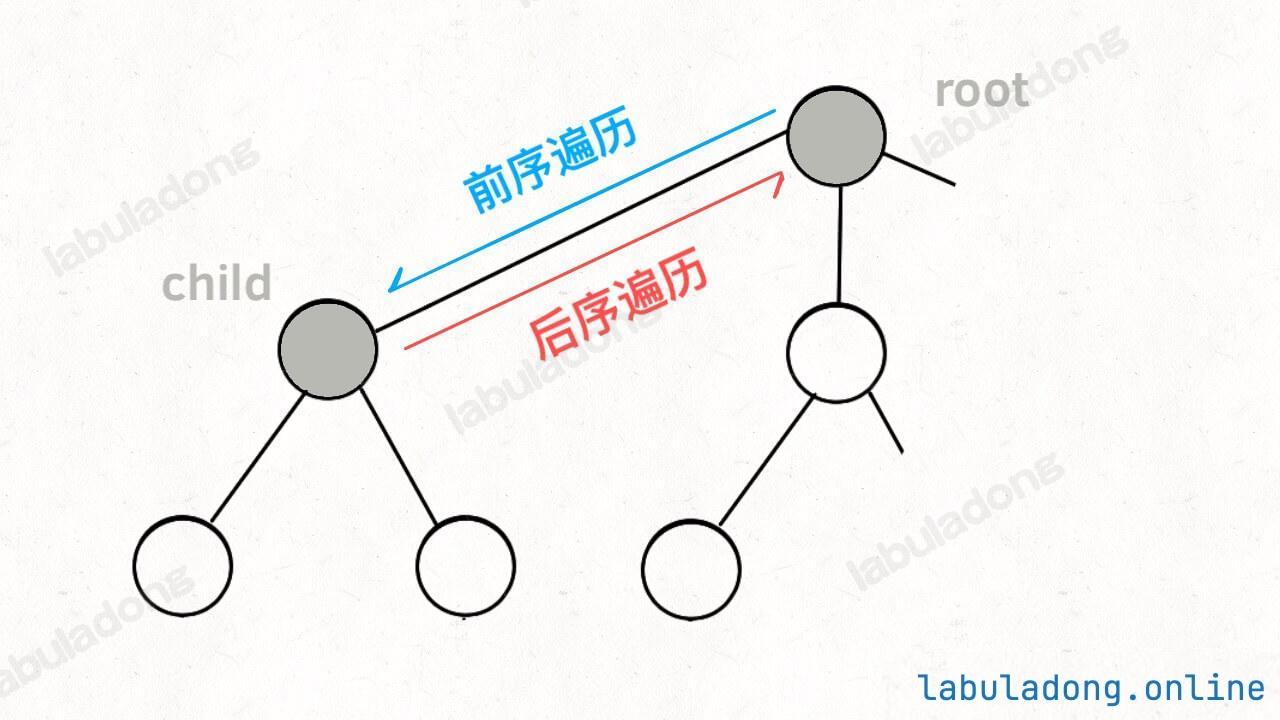

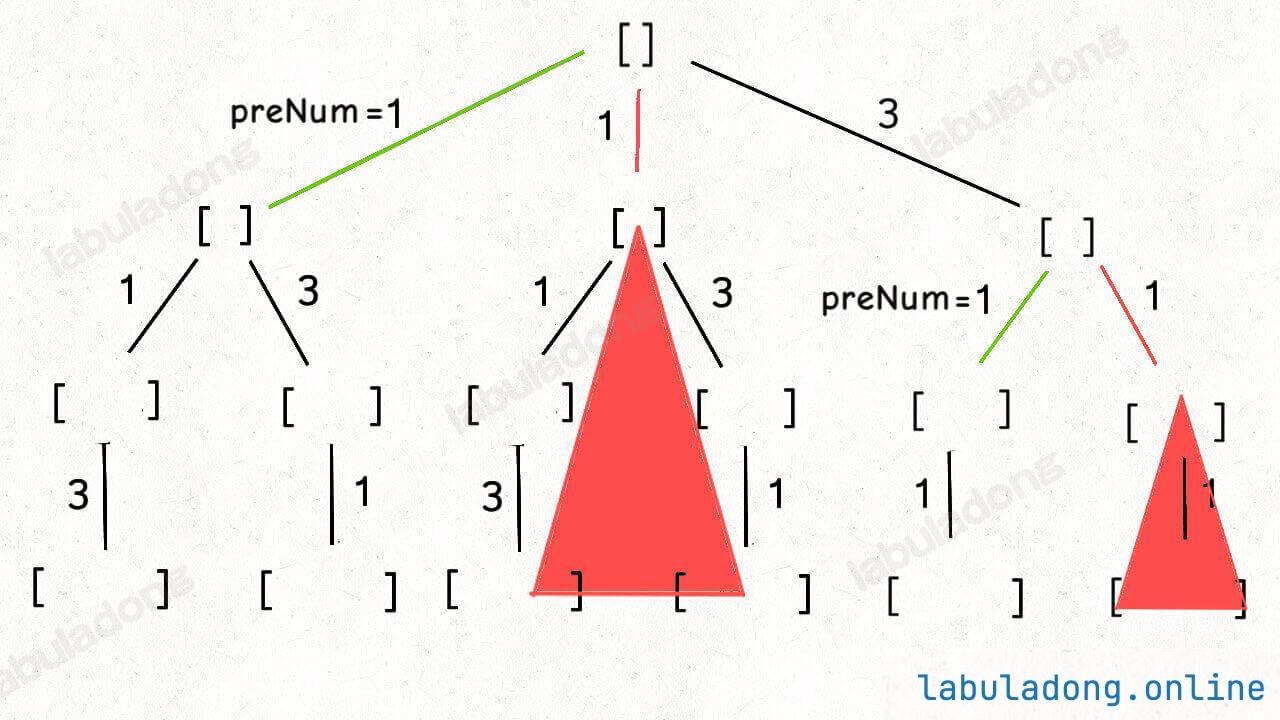

编写递归算法,有两种思维模式:一种是通过「遍历 」一遍树得到答案,另一种是通过「分解问题 」得到答案。

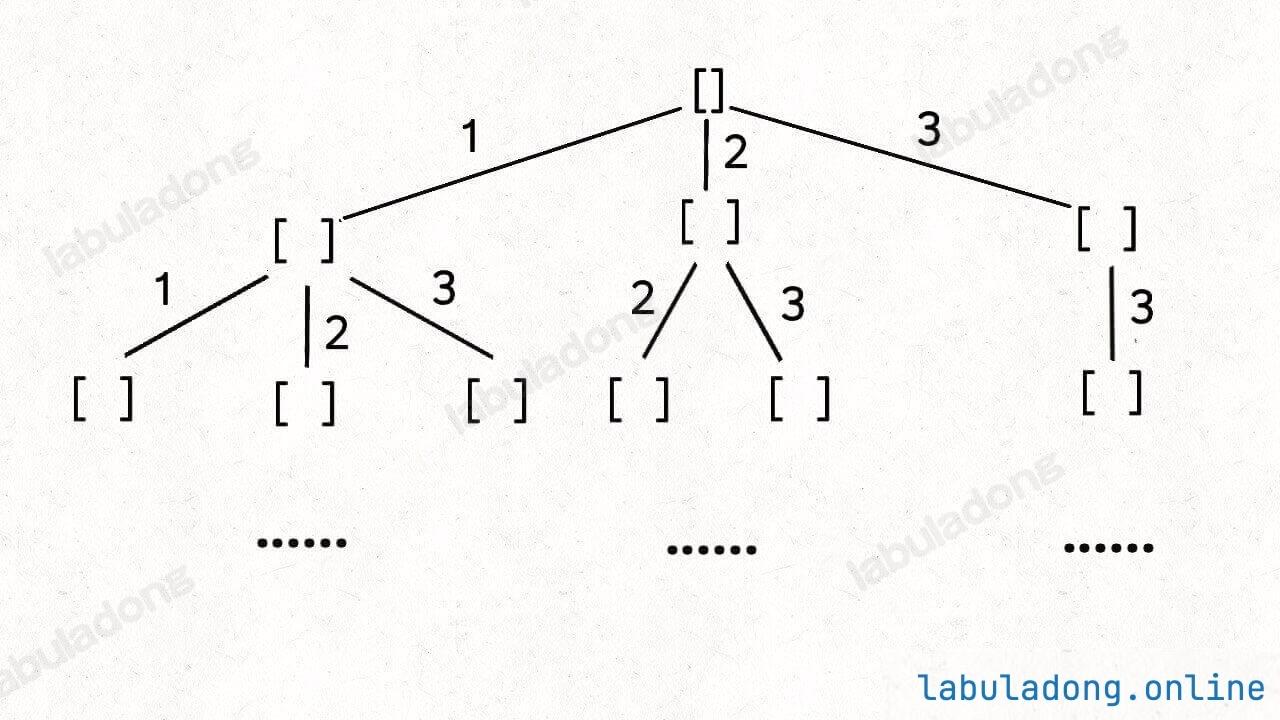

1、从树的角度理解递归

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 int fib (int n) if (n < 2 ) { return n; } return fib (n - 1 ) + fib (n - 2 ); } void traverse (TreeNode root) if (root == null) { return ; } traverse (root.left); traverse (root.right); }

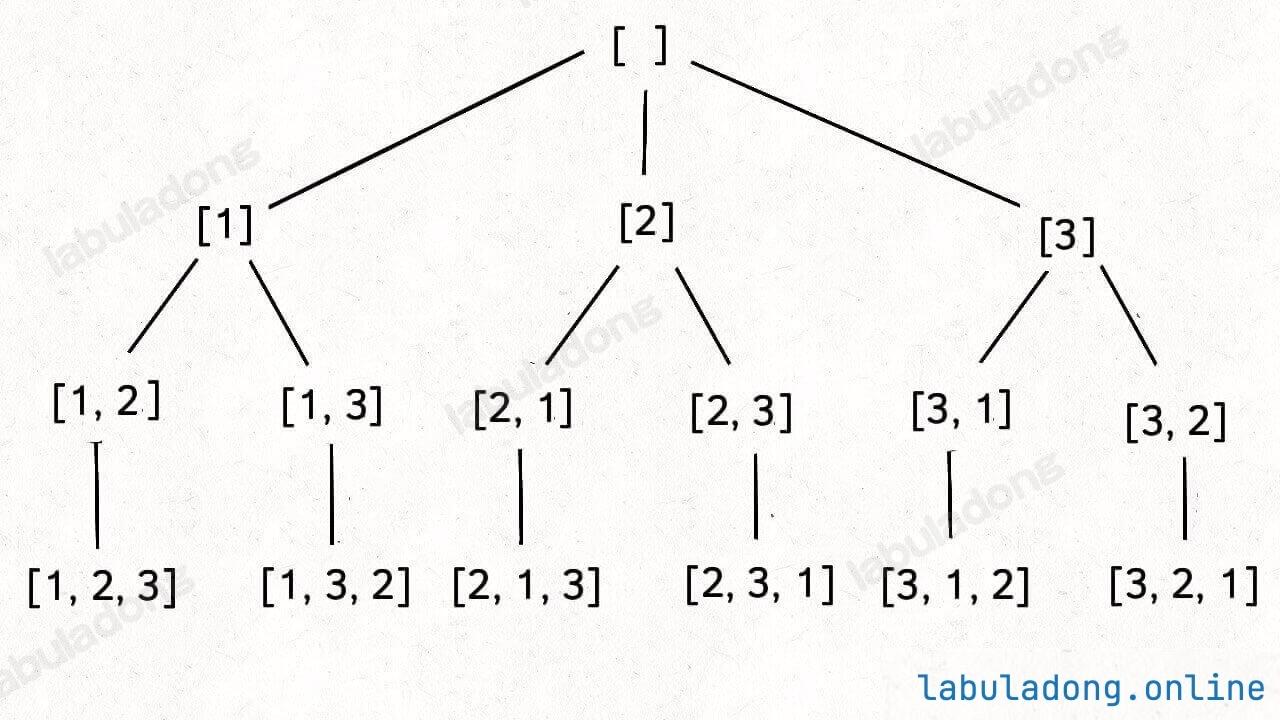

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 class Solution {private : vector<vector<int >> ans; vector<int > path; vector<bool > visit; public : vector<vector<int >> permute (vector<int >& nums) { int n = nums.size (); visit.assign (n, false ); backtrack (nums); return ans; } void backtrack (vector<int >& nums) if (path.size () == nums.size ()){ ans.push_back (path); return ; } for (int i=0 ; i<nums.size (); i++){ if (visit[i]) continue ; path.push_back (nums[i]); visit[i] = true ; backtrack (nums); path.pop_back (); visit[i] = false ; } } };

可以抽象看成:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 void backtrack (int [] nums, List<Integer> track) if (track.size () == nums.length) { return ; } for (int i = 0 ; i < nums.length; i++) { backtrack (nums, track); } } void traverse (TreeNode root) if (root == null) { return ; } for (TreeNode child : root.children) { traverse (child); } }

你应该已经感觉到了,「树」结构是一个非常有效的数据结构。把问题抽象成树结构,然后用代码去遍历这棵树 ,就是递归的本质 。

2、编写递归的两种思维模式

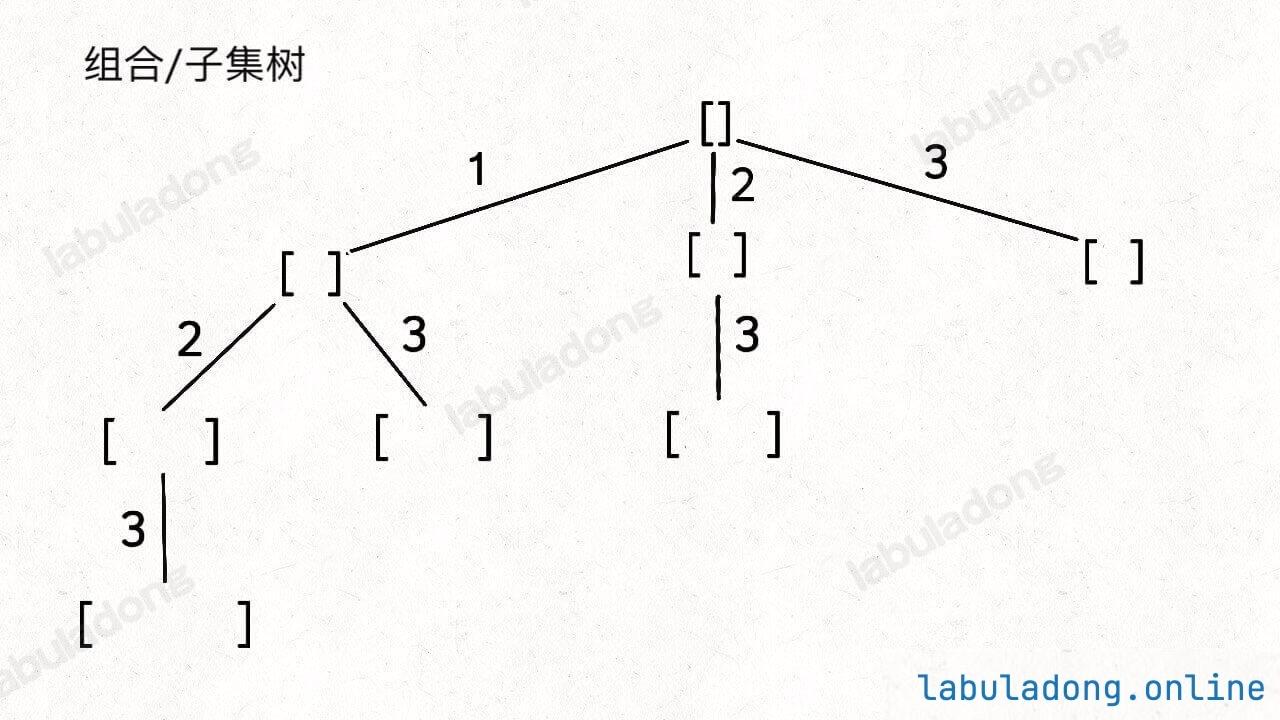

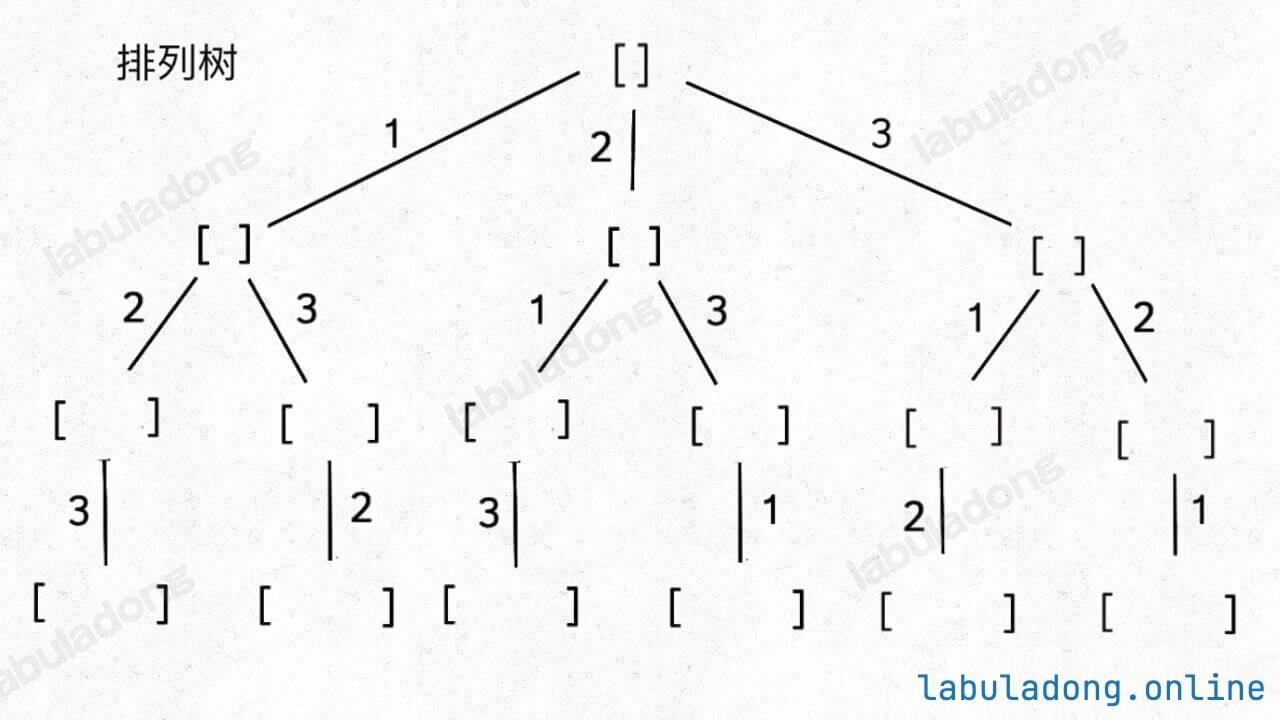

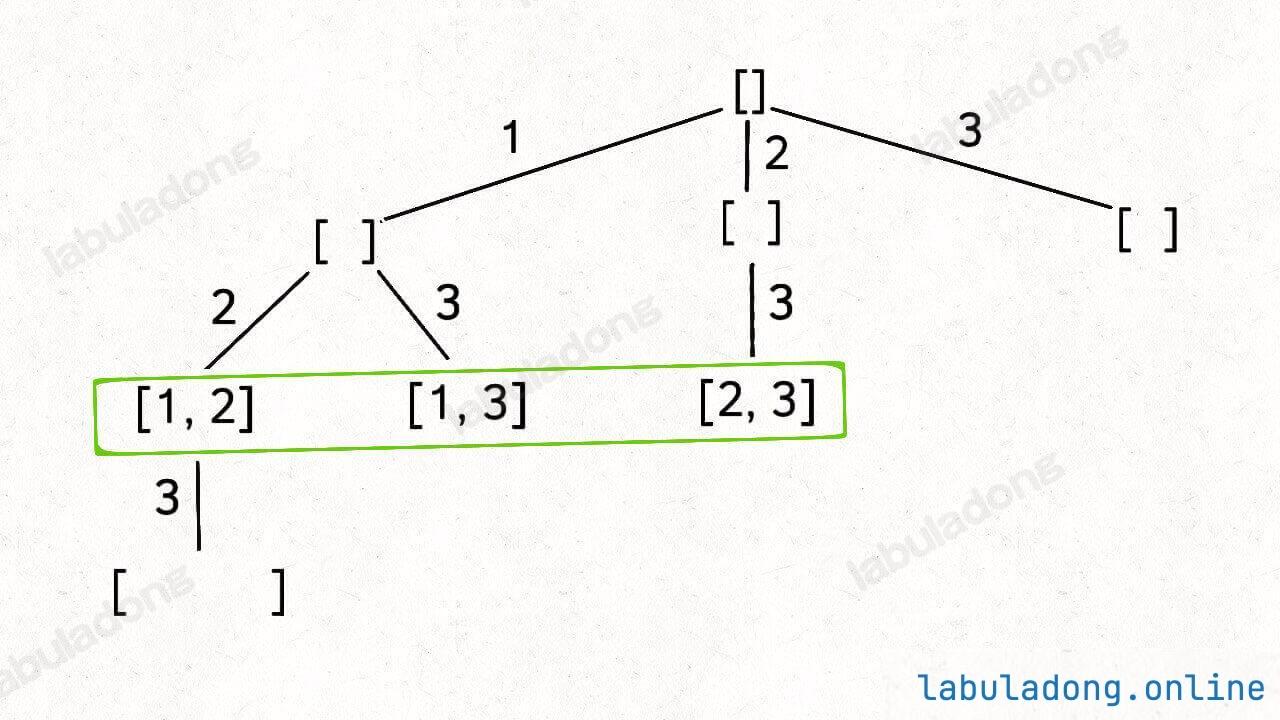

上面讲的两道例题中,它们虽然都抽象成了一棵递归树 ,但斐波那契数列 使用的是「分解问题 」的思维模式求解,全排列 使用的是「遍历 」的思维模式求解。

1 2 3 4 5 6 7 8 9 10 11 12 class Solution {public : int maxDepth (TreeNode* root) if (root == NULL ) return 0 ; return max (maxDepth (root->left), maxDepth (root->right)) + 1 ; } };

遍历的思维模式 无返回值 的遍历函数,在遍历的过程中收集结果 。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 vector<vector<int >> ans; vector<int > path; void backtrack (vector<int >& nums) if (path.size () == nums.size ()){ ans.push_back (path); return ; } for (int i=0 ; i<nums.size (); i++){ path.push_back (nums[i]); backtrack (nums); path.pop_back (); } }

再看前面的二叉树的最大深度,实际上遍历整棵树,在遍历的过程更新最大深度,这样当遍历完所有节点时,必然可以求出整棵树的最大深度:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 class Solution {private : int cur = 0 ; int ans = 0 ; public : void traverse (TreeNode* root) if (root == NULL ){ ans = max (ans, cur); return ; } cur++; traverse (root->left); traverse (root->right); cur--; } int maxDepth (TreeNode* root) traverse (root); return ans; } };

参考以下步骤,运用自如地写出递归算法:

首先,这个问题是否可以抽象成一棵树 结构?如果可以,那么就要用递归算法了。

如果要用递归算法,那么就思考「遍历」和「分解问题」这两种思维模式,看看哪种更适合这个问题。

如果用「分解 问题」的思维模式,那么一定要写清楚这个递归函数的定义 是什么,然后利用这个定义来分解问题,利用子问题的答案推导原问题的答案。

如果用「遍历 」的思维模式,那么要用一个无返回值 的递归函数,单纯起到遍历递归树,到达叶节点收集结果 的作用。

「分解问题 」的思维模式就对应着后面要讲解的 动态规划算法 和 分治算法 。

「遍历 」的思维模式就对应着后面要讲解的 DFS/回溯算法 。

在 二叉树习题章节 ,把所有二叉树相关的题目都用这两种思维模式来解一遍。你只要把二叉树玩明白了,这些递归算法就都玩明白了,真的很简单。

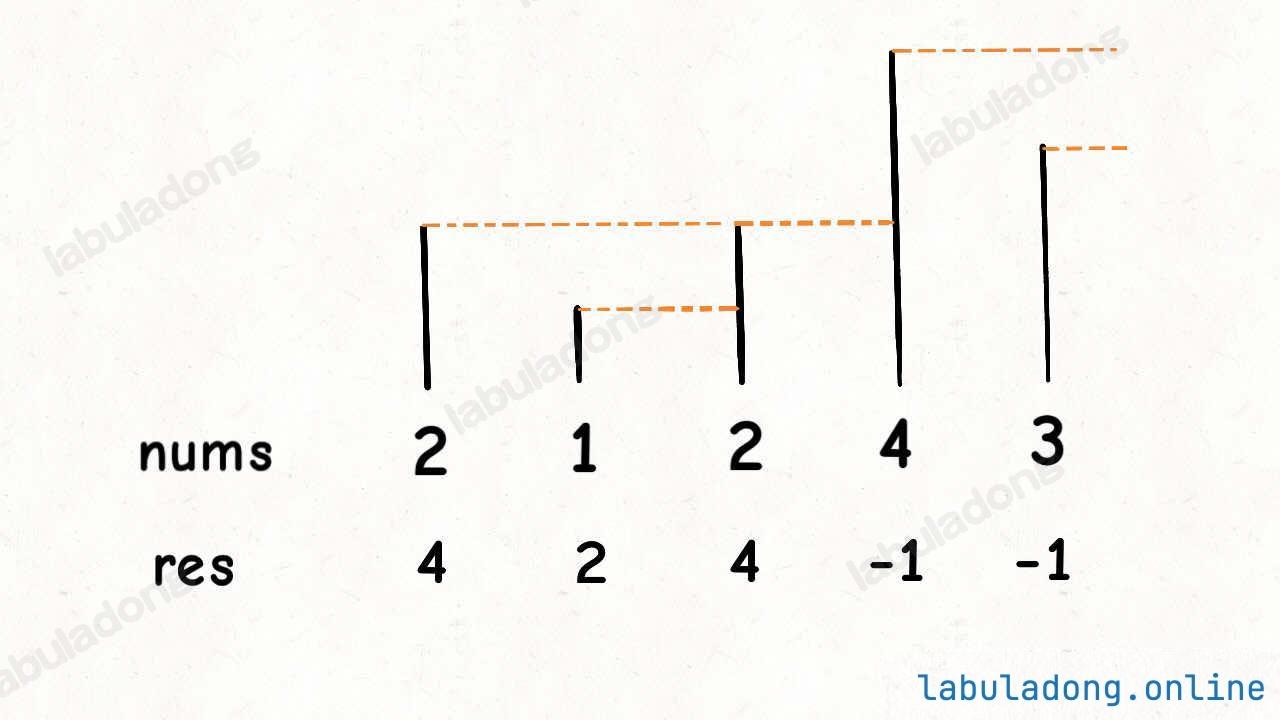

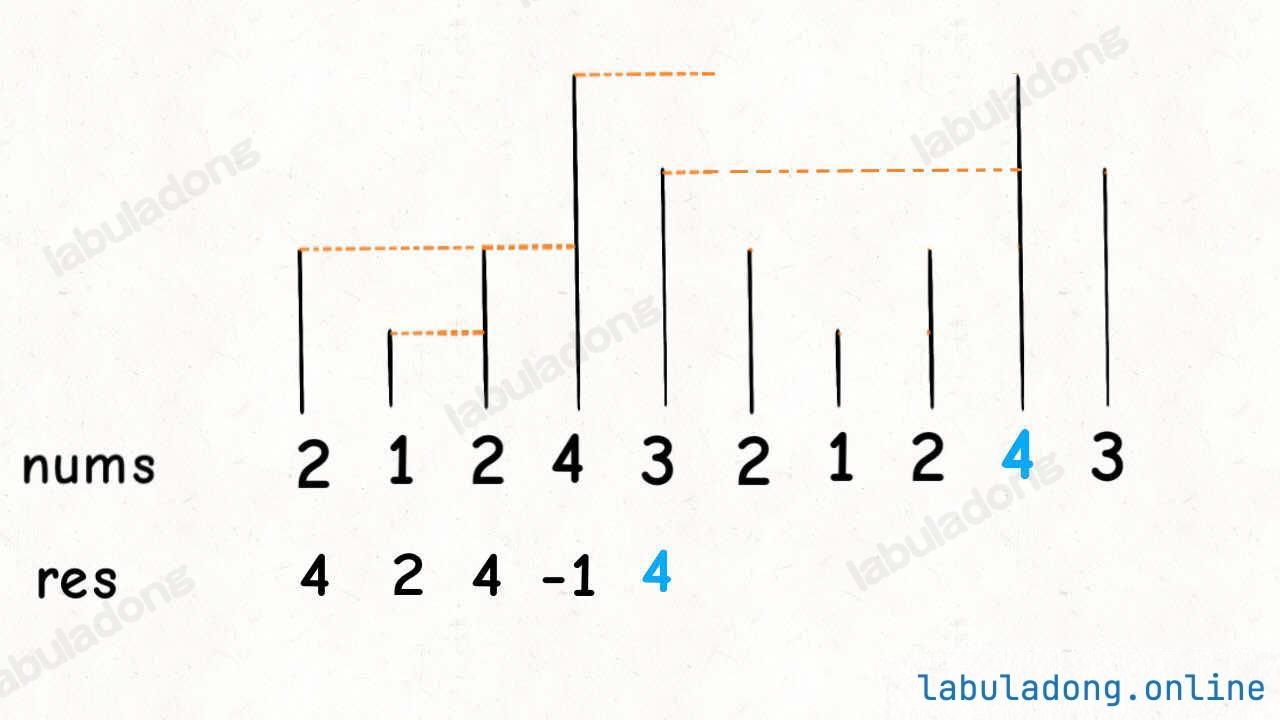

(六) 动态规划

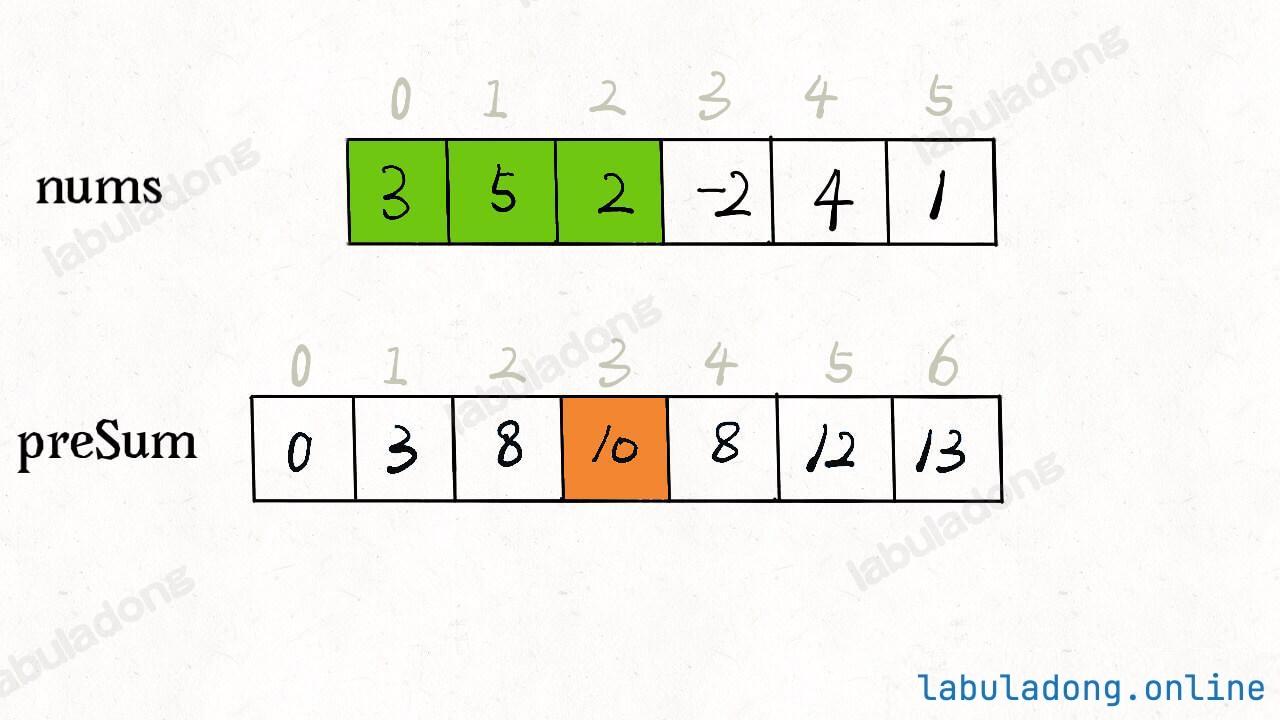

动态规划问题的一般形式就是求最值 。动态规划其实是运筹学的一种最优化方法,只不过在计算机问题上应用比较多,比如说让你求最长递增子序列呀,最小编辑距离呀等等。

求解动态规划的核心问题是穷举 。因为要求最值,肯定要把所有可行的答案穷举出来,然后在其中找最值呗。

只有列出正确的「状态转移方程 」,才能正确地穷举。

是否具备「最优子结构 」: 是否能够通过子问题的最值得到原问题的最值

存在「重叠子问题 」: 需要你使用「备忘录」或者「DP table」来优化穷举过程,避免不必要的计算

动态规划三要素:状态转移方程、最优子结构、重叠子问题

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 def dp (状态1 , 状态2 , ... ): for 选择 in 所有可能的选择: result = 求最值(result, dp(状态1 , 状态2 , ...)) return result dp[0 ][0 ][...] = base case for 状态1 in 状态1 的所有取值: for 状态2 in 状态2 的所有取值: for ... dp[状态1 ][状态2 ][...] = 求最值(选择1 ,选择2. ..)

1、斐波那契数列

参考:509.斐波那契数

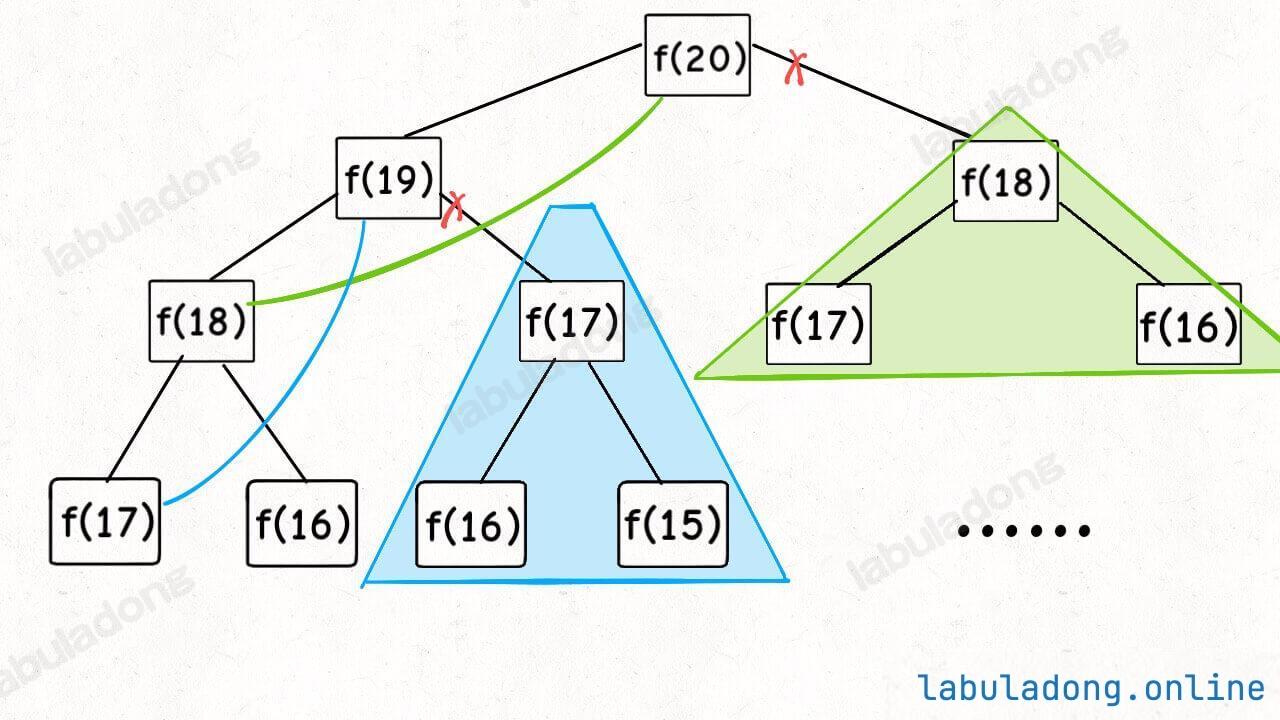

斐波那契数列没有求最值,所以严格来说不是动态规划问题。主要是为了体现重叠子问题。

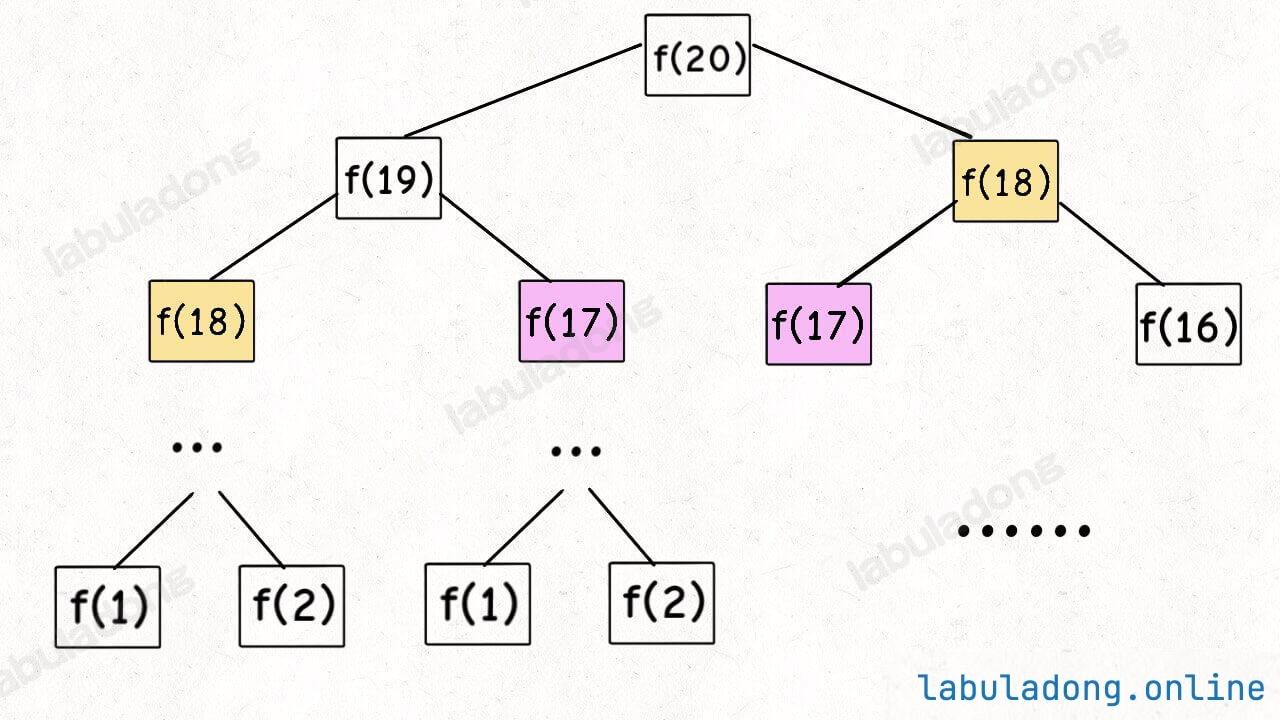

但凡遇到需要递归的问题,最好都画出递归树,这对你分析算法的复杂度,寻找算法低效的原因都有巨大帮助。

二叉树节点总数为指数级别,所以子问题个数为 O ( 2 n ) O(2^n) O ( 2 n ) O ( 1 ) O(1) O ( 1 ) O ( 2 n ) O(2^n) O ( 2 n ) N = 2 h − 1 − 1 N=2^{h-1}-1 N = 2 h − 1 − 1

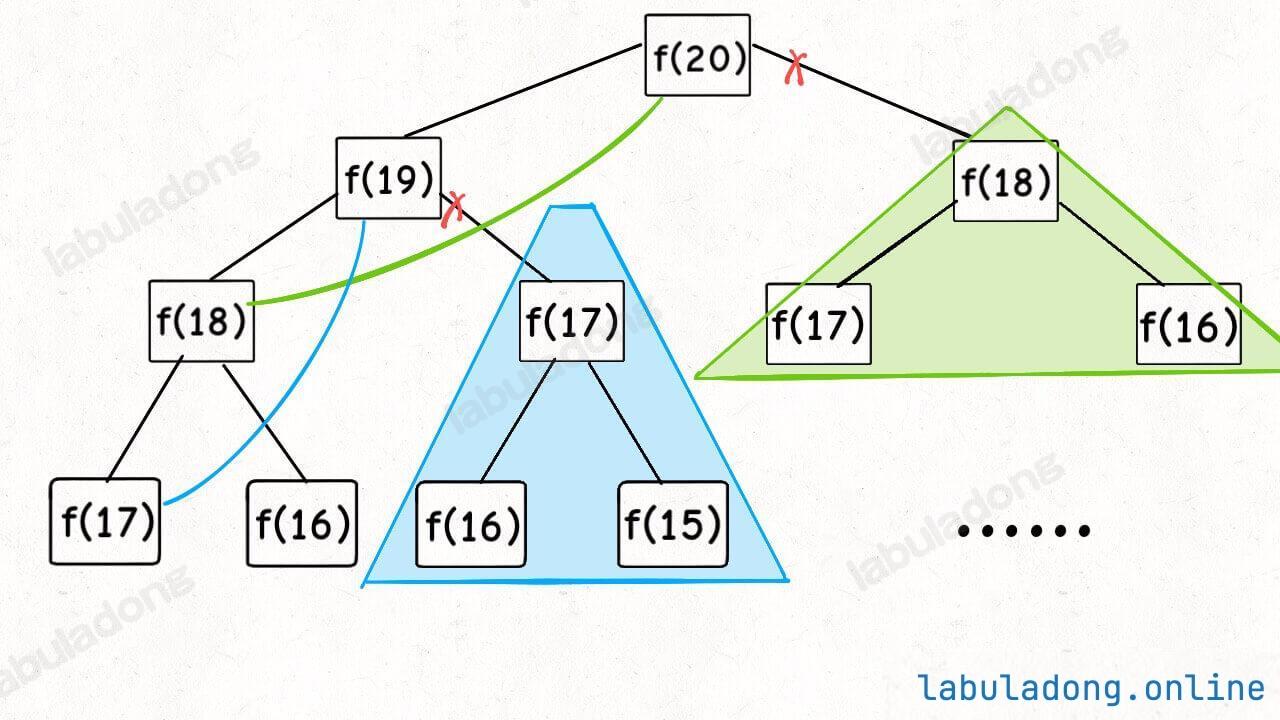

带备忘录的递归解法

即然耗时的原因是重复计算,那么我们可以造一个「备忘录」,每次算出某个子问题的答案后别急着返回,先记到「备忘录」里再返回;每次遇到一个子问题先去「备忘录」里查一查,如果发现之前已经解决过这个问题了,直接把答案拿出来用,不要再耗时去计算了。

一般使用一个数组充当这个「备忘录」,当然你也可以使用哈希表(字典),思想都是一样的。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 class Solution {private : vector<int > memo; public : int fib (int n) memo.assign (n+1 , 0 ); return dp (n); } int dp (int n) if (n==0 || n==1 ) return n; if (memo[n]!=0 ) return memo[n]; memo[n] = dp (n-1 ) + dp (n-2 ); return memo[n]; } };

子问题个数为 O ( n ) O(n) O ( n ) O ( 1 ) O(1) O ( 1 ) O ( n ) O(n) O ( n )

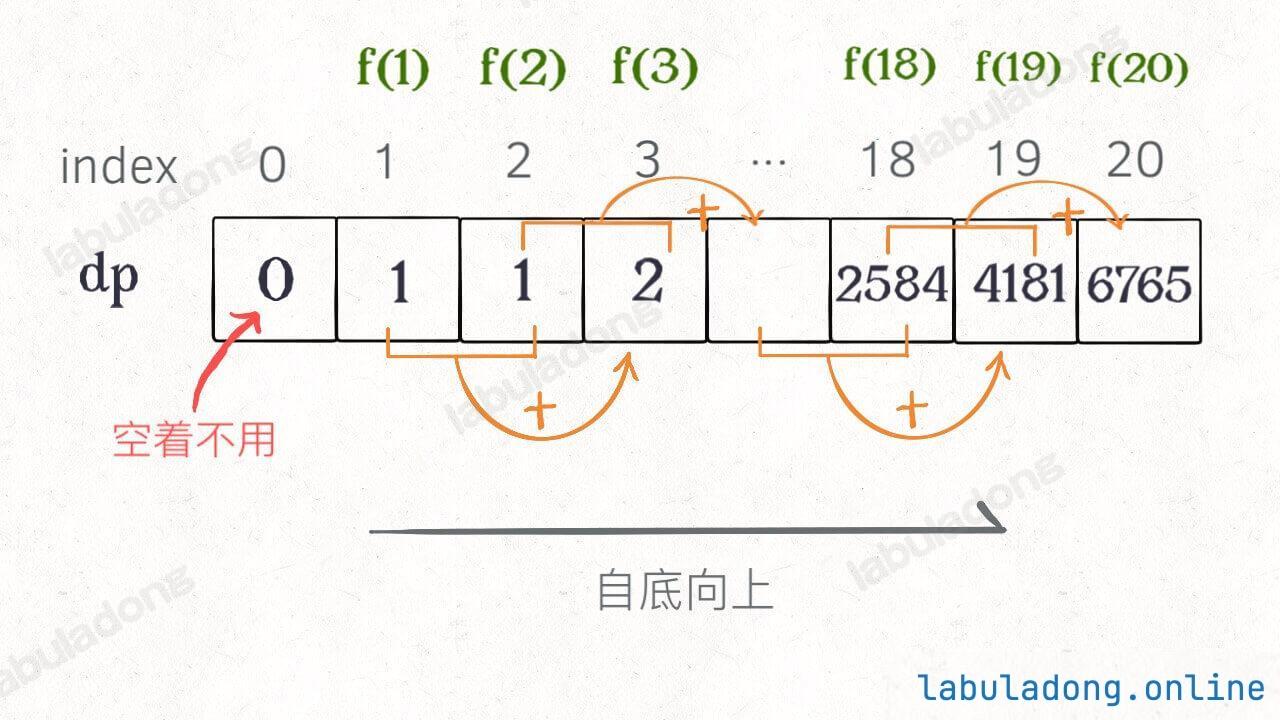

带备忘录的递归 解法的效率已经和迭代的动态规划解法一样了。实际上,这种解法和常见的动态规划解法已经差不多了,只不过这种解法是「自顶向下 」进行「递归 」求解

我们更常见的动态规划 代码是「自底向上 」进行「递推 」求解。

带dp表的动态规划

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 class Solution {private : vector<int > dp; public : int fib (int n) if (n == 0 ) return 0 ; dp.assign (n+1 , 0 ); dp[0 ] = 0 , dp[1 ] = 1 ; for (int i=2 ; i<=n; i++) dp[i] = dp[i-1 ] + dp[i-2 ]; return dp[n]; } };

千万不要看不起暴力解,动态规划问题最困难的就是写出这个暴力解,即状态转移方程 。

只要写出暴力解,优化方法无非是用备忘录或者 DP table,再无奥妙可言。

2、凑零钱

参考:322.零钱兑换

给你 k 种面值的硬币,面值分别为 c1, c2 ... ck,每种硬币的数量无限,再给一个总金额 amount,问你最少需要几枚硬币凑出这个金额,如果不可能凑出,算法返回 -1 。算法的函数签名如下:int coinChange(vector<int>& coins, int amount);

这个问题是动态规划问题,因为它具有「最优子结构 」的。要符合「最优子结构」,子问题间必须互相独立 。

什么是子问题相互独立?

确定「状态 」,也就是原问题和子问题中会变化的变量。

确定「选择 」,也就是导致「状态」产生变化的行为。

明确 dp 函数/数组的定义。

先看直接单纯写出递归:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 class Solution {public : int coinChange (vector<int >& coins, int amount) return dp (coins, amount); } int dp (vector<int >& coins, int amount) if (amount == 0 ) return 0 ; if (amount < 0 ) return -1 ; int ans = -1 ; for (int coin: coins){ int subProblem = dp (coins, amount-coin); if (subProblem == -1 ) continue ; if (ans == -1 ) ans = subProblem+1 ; else ans = min (ans, subProblem+1 ); } return ans; } };

这实际上就是暴力计算:

d p ( n ) = { − 1 , n < 0 0 , n = 0 m i n { d p ( n − c o i n ) + 1 ∣ c o i n ∈ c o i n s } n > 0 dp(n) = \begin{cases}

-1,\quad n<0\\

0,\quad n=0\\

min\{ dp(n-coin)+1 \quad | \quad coin\in coins \}\quad n>0

\end{cases}

d p ( n ) = ⎩ ⎨ ⎧ − 1 , n < 0 0 , n = 0 min { d p ( n − co in ) + 1 ∣ co in ∈ co in s } n > 0

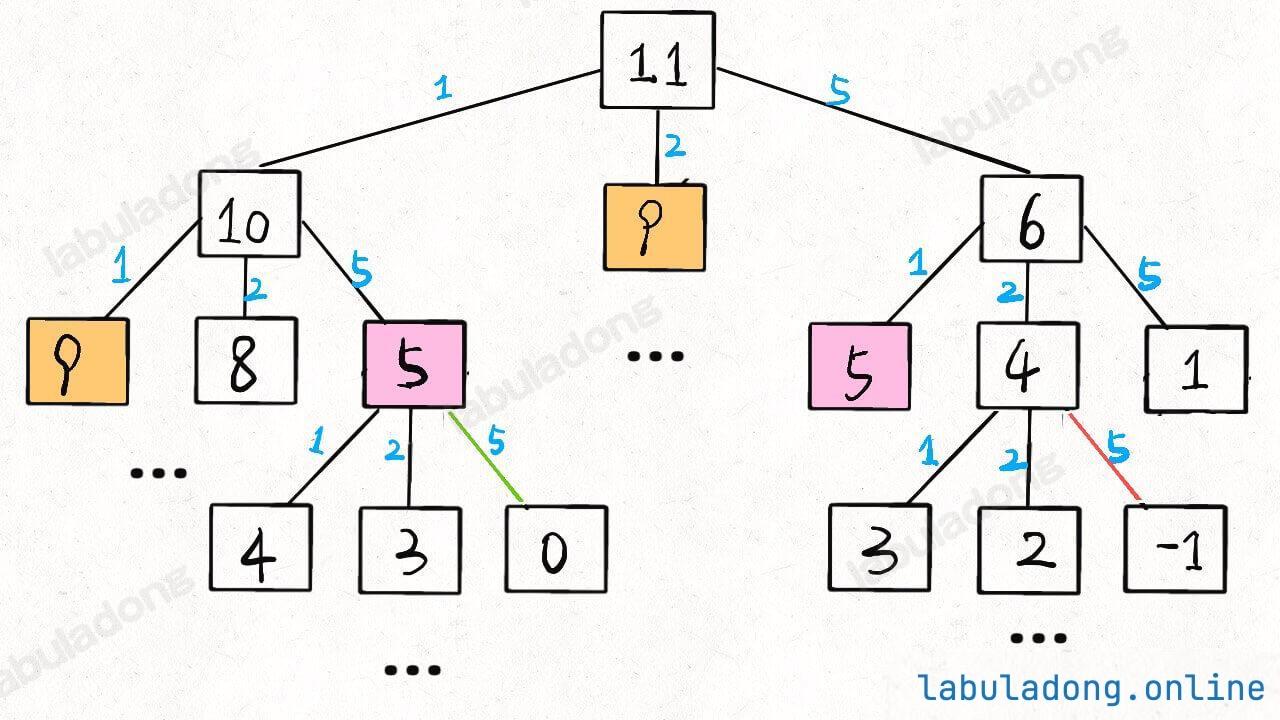

画出递归树:

递归算法的时间复杂度分析:子问题总数 x 解决每个子问题所需的时间 。

假设目标金额为 n,给定的硬币个数为 k,那么递归树最坏情况下高度为 n(全用面额为 1 的硬币),然后再假设这是一棵满 k 叉树,则节点的总数在 O ( k n ) O(k^n) O ( k n ) for 循环,复杂度为 O ( k ) O(k) O ( k ) O ( k n ) O(k^n) O ( k n )

这个问题其实就解决了,只不过需要消除一下重叠子问题。

带备忘录的递归

计算前,看备忘录是不是计算过。

离开前,在备忘录记下计算结果。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 class Solution {private : vector<int > memo; public : int coinChange (vector<int >& coins, int amount) memo.assign (amount+1 , -666 ); return dp (coins, amount); } int dp (vector<int >& coins, int amount) if (amount == 0 ) return 0 ; if (amount < 0 ) return -1 ; if (memo[amount] != -666 ) return memo[amount]; int ans = -1 ; for (int coin: coins){ int subProblem = dp (coins, amount-coin); if (subProblem == -1 ) continue ; if (ans == -1 ) ans = subProblem+1 ; else ans = min (ans, subProblem+1 ); } memo[amount] = ans; return ans; } };

子问题总数不会超过金额数 n,即子问题数目为 O ( n ) O(n) O ( n ) O ( k ) O(k) O ( k ) O ( k n ) O(kn) O ( kn )

带dp的动态规划

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 class Solution {private : vector<int > dp; public : int coinChange (vector<int >& coins, int amount) dp.assign (amount+1 , amount+1 ); dp[0 ] = 0 ; for (int i=1 ; i<=amount; i++){ for (int coin: coins){ if (i-coin < 0 ) continue ; dp[i] = min (dp[i], dp[i-coin]+1 ); } } return dp[amount]>amount? -1 : dp[amount]; } };

为什么凑零钱问题不能用贪心 算法来解?因为想要硬币数最少,那就总是先使用面额大的硬币来凑?

这题不能用贪心,贪心的意思是说,一路按照最优选择选下去,就一定能得到正确答案(专业术语叫做贪心选择性质)。而这道题是不满足贪心选择性质的。你如果无脑选用大额硬币,不一定就能凑出目标金额,即便凑出了,也不一定是最小的数量。

比如要凑8块,有1,4,5面值的钱,贪心就是【5,1,1,1】,正确答案是【4,4】

那么这时候你就要尝试其他较小的金额了,所以说到底还是得暴力穷举所有情况,需要用递归进行暴力穷举。通过观察暴力穷举解法代码,我们发现这道题存在最优子结构和重叠子问题,所以逐步优化写出了带备忘录的递归穷举解法(动态规划)。

注意上面这个思考过程,从暴力穷举 算法开始,逐步尝试各种优化 方法。至于「贪心」「动态规划」这种名词,只不过是对不同优化过程的代称罢了。

计算机解决问题其实没有任何特殊的技巧,它唯一的解决办法就是穷举,穷举所有可能性。算法设计无非就是先思考「如何穷举」,然后再追求「如何聪明地穷举」。

列出状态转移方程 ,就是在解决「如何穷举 」的问题。

备忘录、DP table 就是在追求「如何聪明地穷举 」。

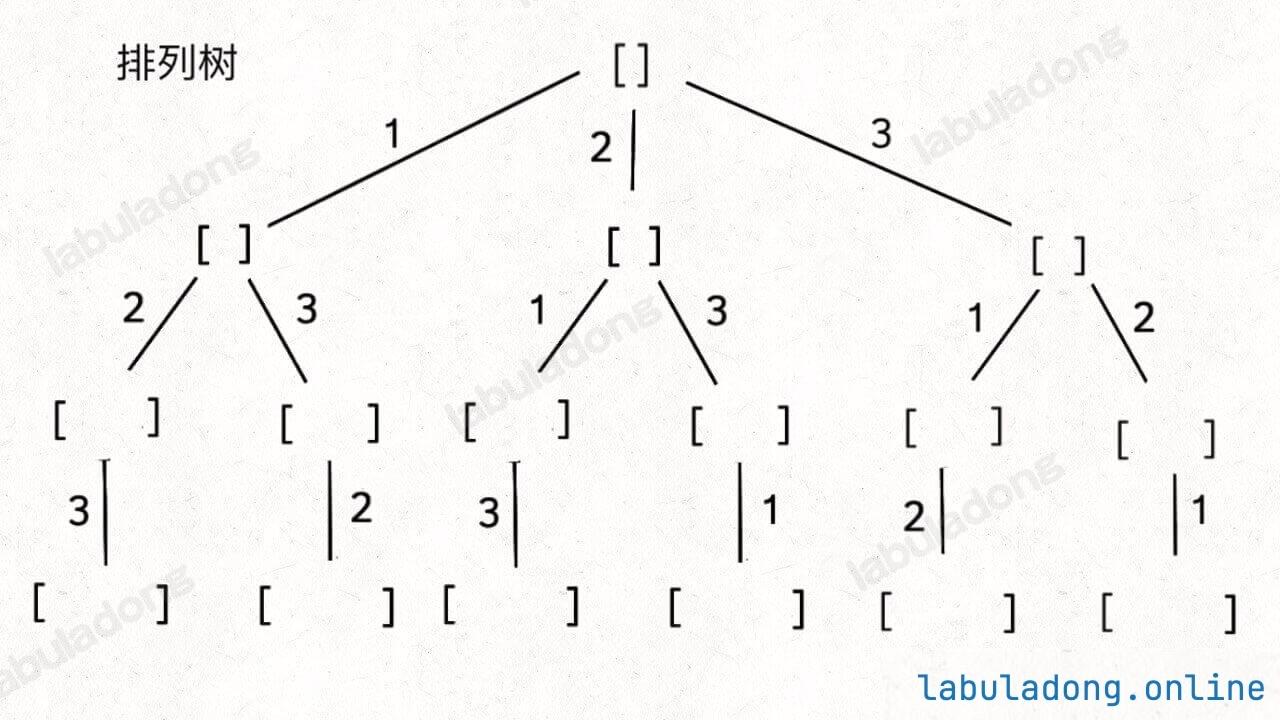

(七) 回溯(DFS)

其实回溯算法和我们常说的 DFS 算法基本可以认为是同一种算法,它们的细微差异在之后章节说明。

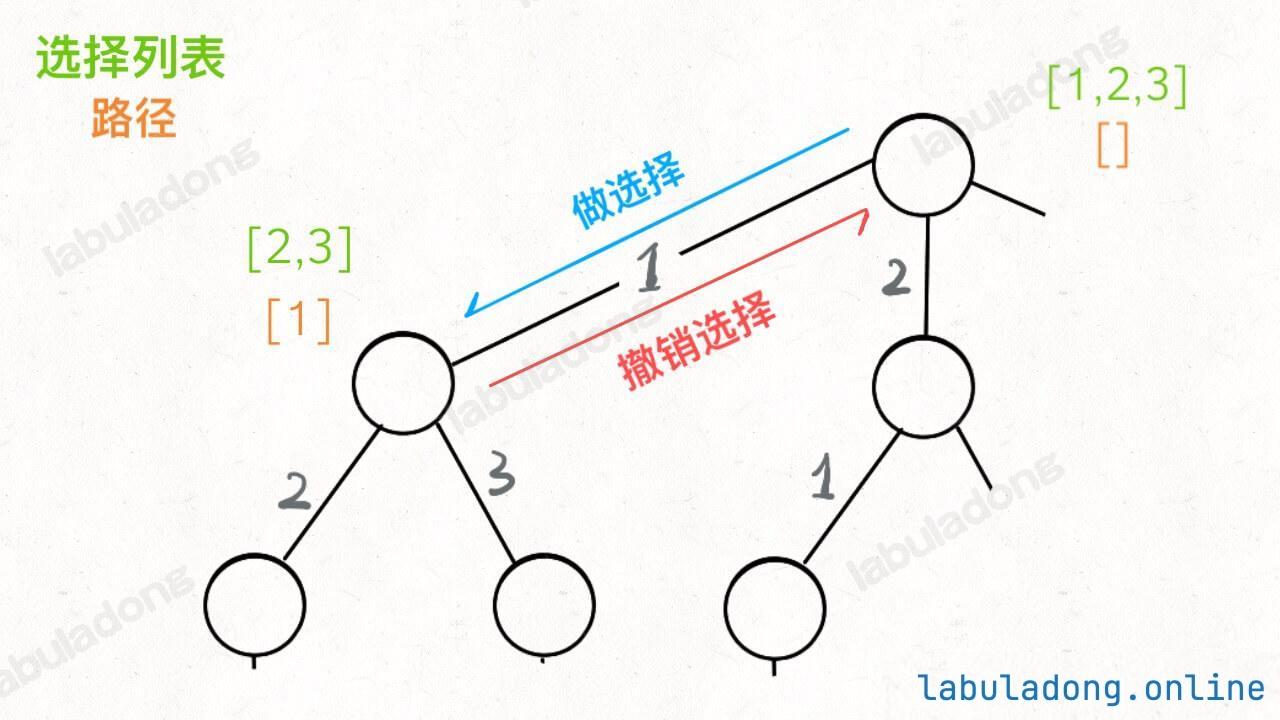

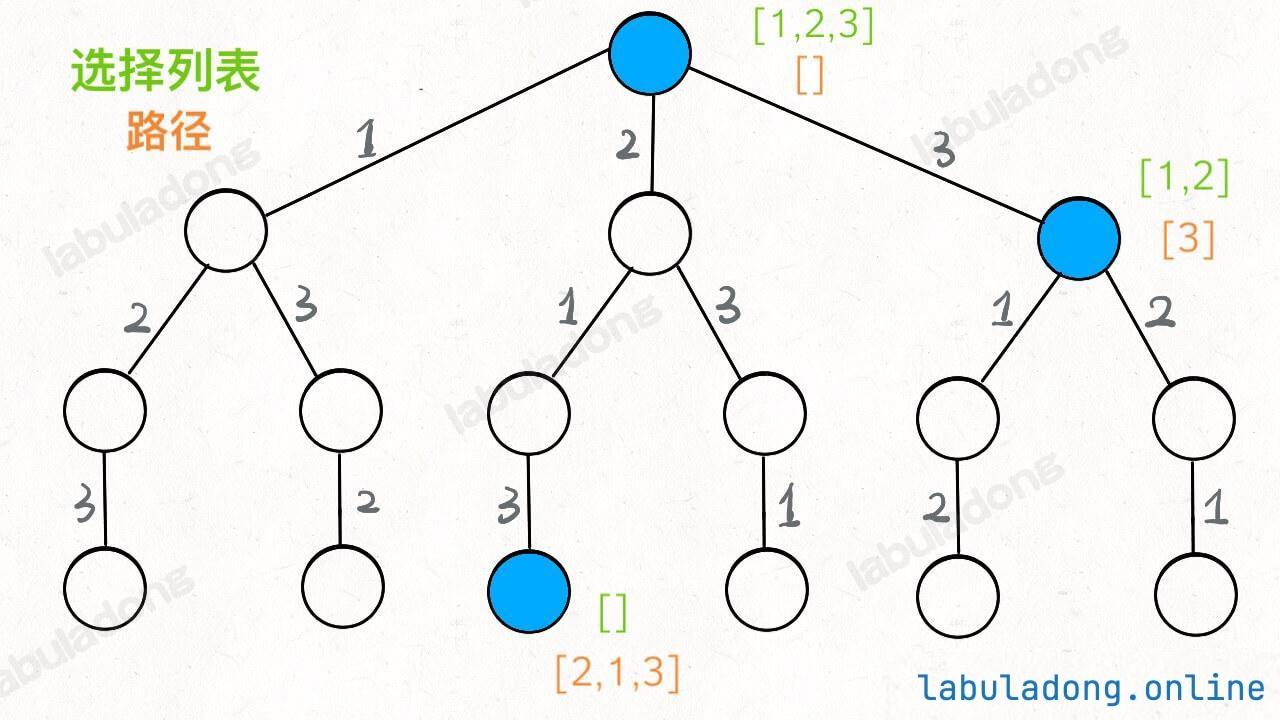

抽象地说,解决一个回溯 问题,实际上就是遍历一棵决策树 的过程,树的每个叶子节点存放着一个合法答案 。你把整棵树遍历一遍,把叶子节点上的答案都收集起来,就能得到所有的合法答案。

站在回溯树的一个节点上,你只需要思考 3 个问题:

路径 :也就是已经做出的选择。选择列表 :也就是你当前可以做的选择。结束条件 :也就是到达决策树底层,无法再做选择的条件。

1 2 3 4 5 6 7 8 9 10 result = [] def backtrack (路径, 选择列表 ): if 满足结束条件: result.add(路径) return for 选择 in 选择列表: 做选择 backtrack(路径, 选择列表) 撤销选择

其核心就是 for 循环里面的递归,在递归调用之前「做选择」,在递归调用之后「撤销选择」 。

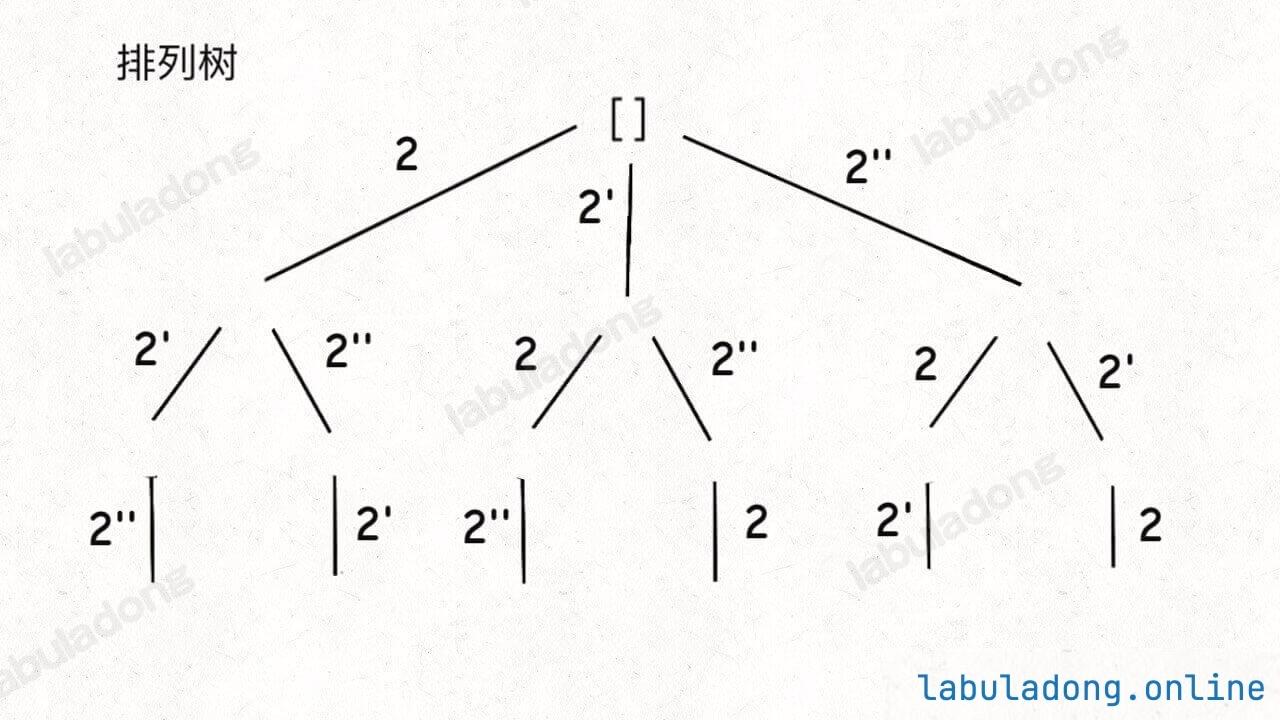

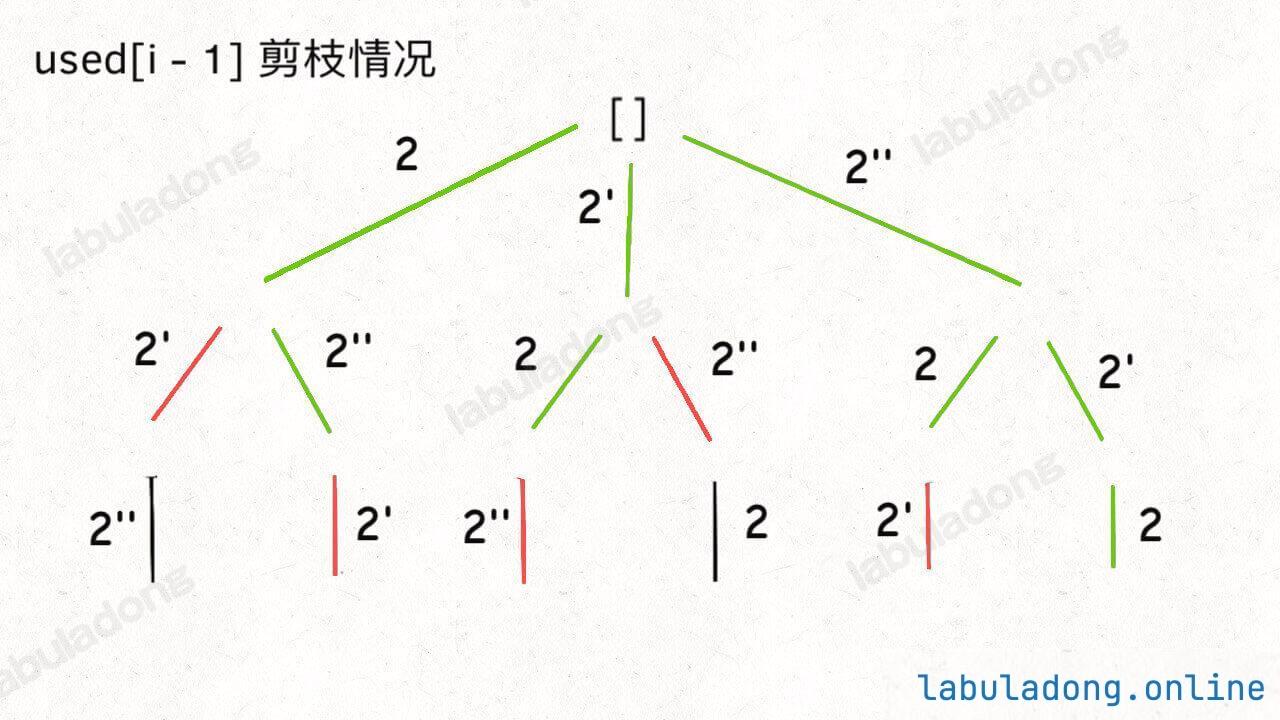

1、全排列

参考:46.全排列

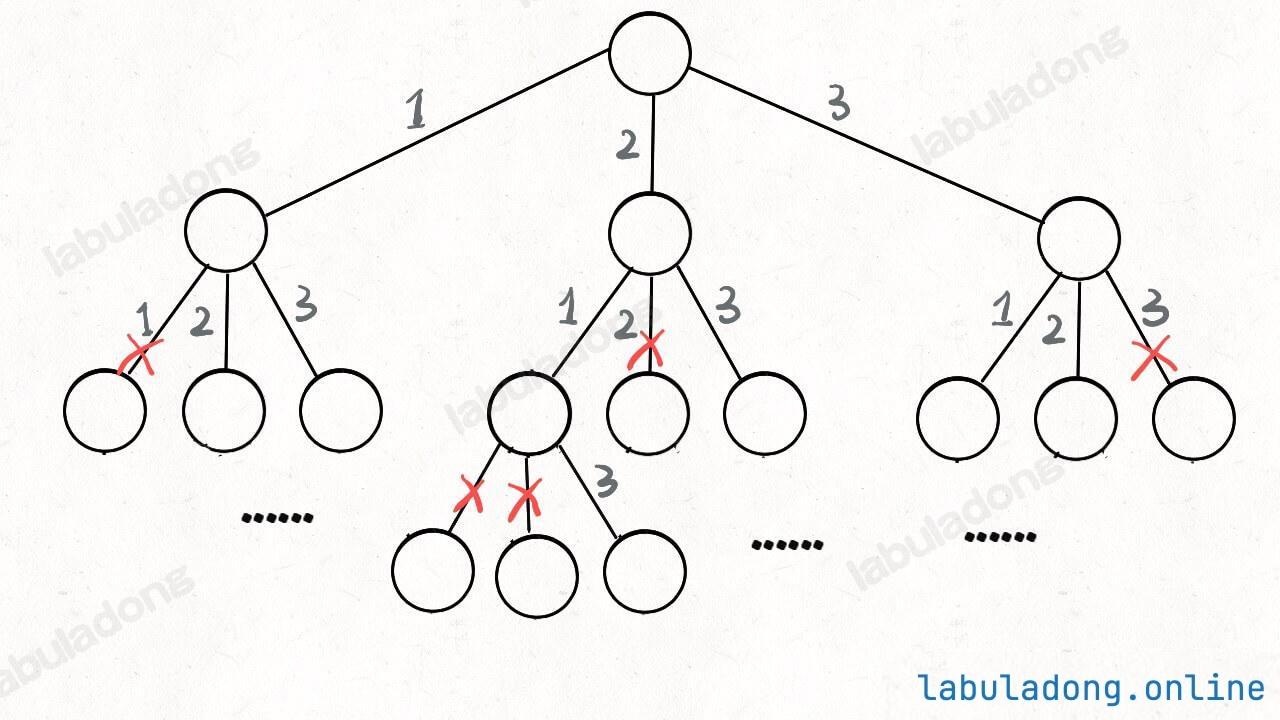

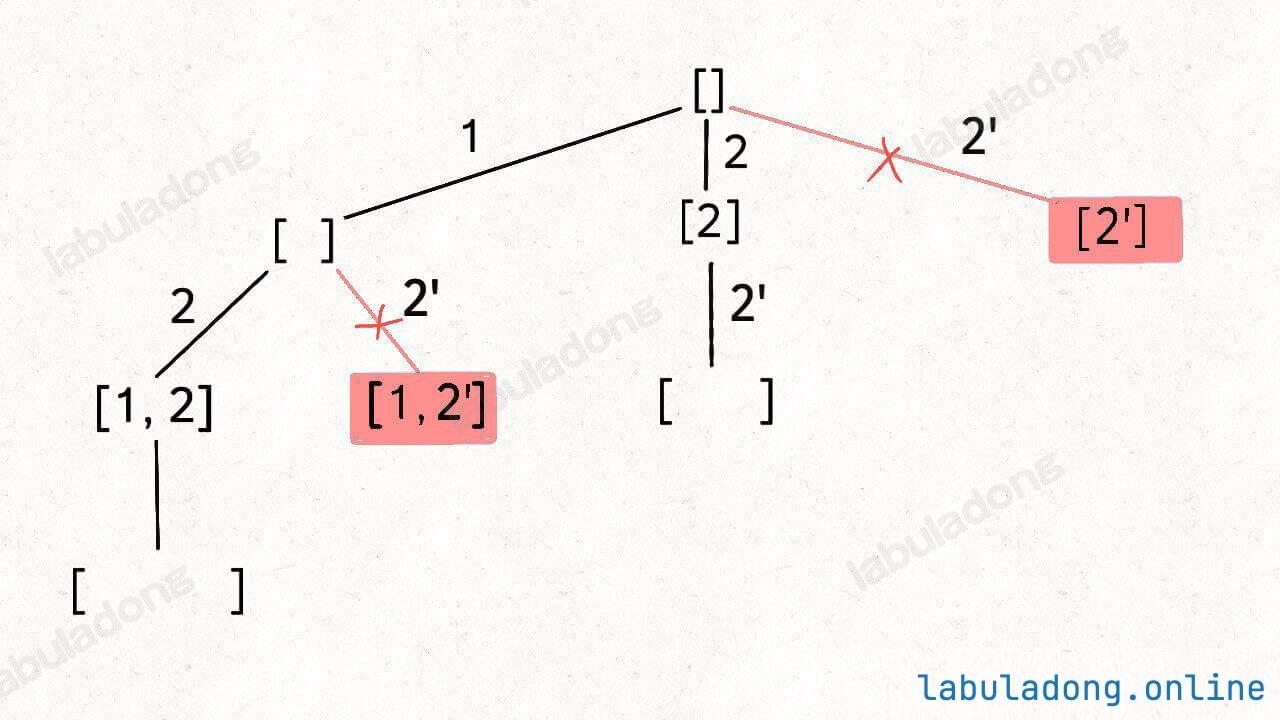

我们这次讨论的全排列问题不包含重复的数字,包含重复数字的扩展场景在之后章节。

框架:

1 2 3 4 5 6 7 void traverse(TreeNode* root) { for (TreeNode* child : root->childern) { // 前序位置需要的操作 traverse(child); // 后序位置需要的操作 } }

疑问:多叉树 DFS 遍历框架的前序位置和后序位置应该在 for 循环外面,并不应该是在 for 循环里面呀?为什么在回溯算法中跑到 for 循环里面了?解答回溯/DFS 算法的若干疑问 会具体讲解,这里可以暂且忽略这个问题。

前序和后序只是两个很有用的时间点:

1 2 3 4 5 6 7 8 for 选择 in 选择列表: 将该选择从选择列表移除 路径.add(选择) backtrack(路径, 选择列表) 路径.remove(选择) 将该选择再加入选择列表

好的,直接看一下完整代码:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 class Solution {private : vector<vector<int >> ans; vector<int > path; vector<bool > visit; public : vector<vector<int >> permute (vector<int >& nums) { visit.assign (nums.size (), false ); backtrace (nums); return ans; } void backtrace (vector<int >& nums) if (path.size () == nums.size ()){ ans.push_back (path); return ; } for (int i=0 ; i<nums.size (); i++){ if (visit[i]) continue ; path.push_back (nums[i]); visit[i] = true ; backtrace (nums); path.pop_back (); visit[i] = false ; } } };

稍微做了些变通,没有显式记录「选择列表」,而是通过 used 数组排除已经存在 track 中的元素,从而推导出当前的选择列表:

但是必须说明的是,不管怎么优化,都符合回溯框架,而且时间复杂度都不可能低于 O ( N ! ) O(N!) O ( N !) N! 种全排列结果。回溯算法就是纯暴力穷举,复杂度一般都很高 。二叉树心法(纲领篇) 你将看到动态规划和回溯算法更深层次的区别和联系。

(八) BFS

DFS/回溯 算法的本质就是递归遍历一棵穷举树(多叉树),而多叉树的递归遍历又是从二叉树的递归遍历衍生出来的。所以我说 DFS/回溯算法的本质是二叉树的递归遍历 。BFS 算法的本质就是遍历一幅图 。而图的遍历算法其实就是多叉树的遍历算法加了个 visited 数组防止死循环;多叉树的遍历算法又是从二叉树遍历算法衍生出来的。所以我说 BFS 算法的本质就是二叉树的层序遍历 。

1、算法框架

在前文图的数据结构里面,已经讲解了有三种写法,这里使用第二种。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 int bfs (const Graph& graph, int s, int target) vector<bool > visited (graph.size(), false ) ; queue<int > q; q.push (s); visited[s] = true ; int step = 0 ; while (!q.empty ()) { int sz = q.size (); for (int i = 0 ; i < sz; i++) { int cur = q.front (); q.pop (); cout << "visit " << cur << " at step " << step << endl; if (cur == target) { return step; } for (int to : neighborsOf (cur)) { if (!visited[to]) { q.push (to); visited[to] = true ; } } } step++; } return -1 ; }

2、滑动谜题

参考:773.滑动谜题

给你一个 2x3 的滑动拼图,用一个 2x3 的数组 board 表示。拼图中有数字 0~5 六个数,其中数字 0 就表示那个空着的格子,你可以移动其中的数字,当 board 变为 [[1,2,3],[4,5,0]] 时,赢得游戏。-1。board = [[4,1,2],[5,0,3]],算法应该返回 5:board = [[1,2,3],[5,4,0]],则算法返回 -1,因为这种局面下无论如何都不能赢得游戏。

抽象出来的图结构也是会包含环的,所以需要一个 visited 数组记录已经走过的节点,避免成环导致死循环。

注意,此时是整张图的状态完全和之前一样了才是成环了,所以visited的索引,应该是一整张图的状态。但二维数组这种可变数据结构是无法直接加入哈希集合的。

再用一点技巧,想办法把二维数组转化成一个不可变类型才能存到哈希集合中。常见的解决方案是把二维数组序列化成一个字符串 ,这样就可以直接存入哈希集合了。

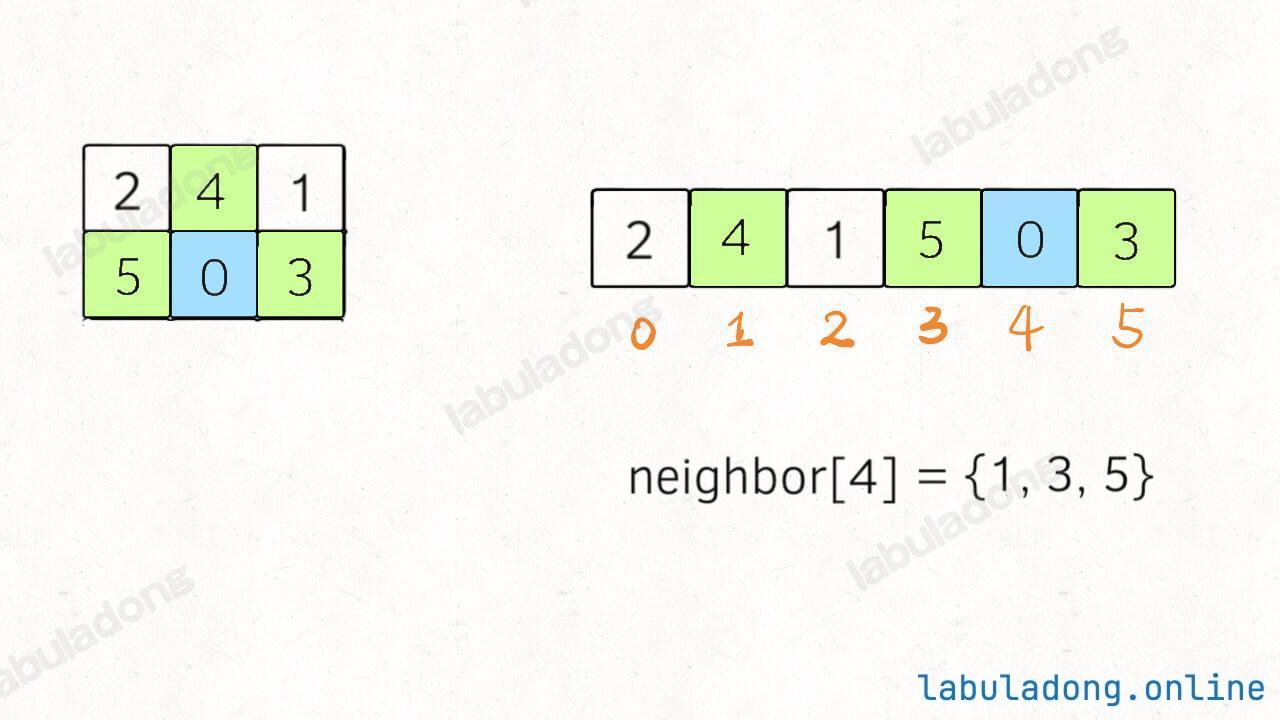

其中比较有技巧性的点在于,二维数组有「上下左右 」的概念,压缩成一维的字符串后后,还怎么把数字 0 和上下左右的数字进行交换?对于这道题,题目说输入的数组大小都是 2 x 3,所以我们可以直接手动写出来这个映射:

1 2 3 4 5 6 7 8 9 int map[6 ][3 ] = { {1 , 3 }, {0 , 2 , 4 }, {1 , 5 }, {0 , 4 }, {1 , 3 , 5 }, {2 , 4 } }

这个映射的含义就是,在一维字符串中,索引 i 在二维数组中的的相邻索引为 neighbor[i] :

如果是 m x n 的二维数组,怎么办?e 在一维数组中的索引为 i,那么 e 的左右相邻元素在一维数组中的索引就是 i - 1 和 i + 1,而 e 的上下相邻元素在一维数组中的索引就是 i - n 和 i + n,其中 n 为二维数组的列数。